Microsoft wprowadza rodzinę modeli Phi-3, które przewyższają innymi modelami swojej klasy

2 minuta. czytać

Opublikowany

Przeczytaj naszą stronę z informacjami, aby dowiedzieć się, jak możesz pomóc MSPoweruser w utrzymaniu zespołu redakcyjnego Czytaj więcej

W grudniu 2023 r. Microsoft wydał Phi-2 model z 2.7 miliardami parametrów, który zapewnił najnowocześniejszą wydajność wśród modeli języka podstawowego z mniej niż 13 miliardami parametrów. W ciągu ostatnich czterech miesięcy kilka innych modeli, które zostały wypuszczone na rynek, uzyskało lepsze wyniki niż Phi-2. Niedawno Meta wypuściła rodzinę modeli Llama-3, która przewyższała wszystkie wcześniej wydane modele open source.

Wczoraj wieczorem dział Microsoft Research ogłosił za pośrednictwem portalu rodzinę modeli Phi-3 raport techniczny. W rodzinie Phi-3 dostępne są trzy modele:

- fi-3-mini (3.8B)

- phi-3-mały (7B)

- phi-3-średni (14B)

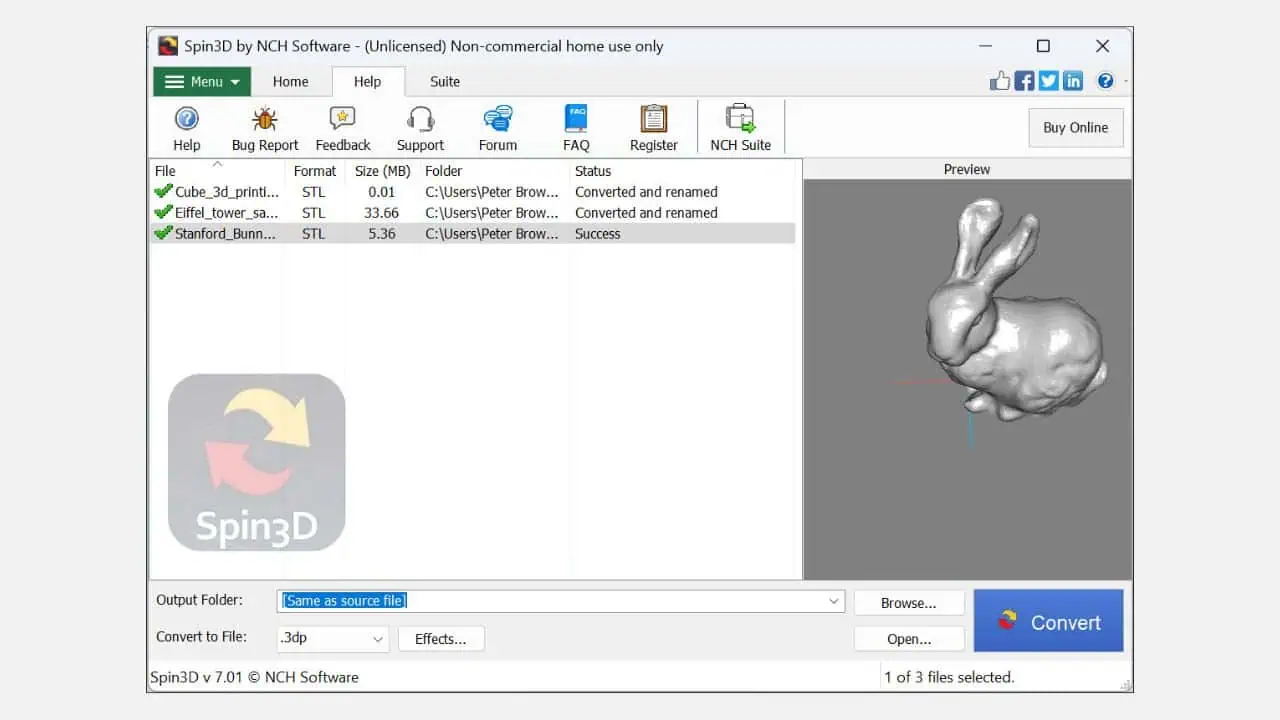

Phi-3-mini z modelem języka o parametrach wynoszącym 3.8 miliarda jest trenowany na 3.3 biliona tokenów. Według benchmarków phi-3-mini pokonuje Mixtral 8x7B i GPT-3.5. Microsoft twierdzi, że ten model jest na tyle mały, że można go zastosować na telefonie. Firma Microsoft użyła powiększonej wersji zbioru danych użytej w przypadku phi-2, składającej się z mocno filtrowanych danych internetowych i danych syntetycznych. Zgodnie z wynikami testów porównawczych Microsoftu przedstawionymi w dokumencie technicznym, phi-3-small i phi-3-medium osiągają imponujący wynik MMLU wynoszący odpowiednio 75.3 i 78.2.

Jeśli chodzi o możliwości LLM, chociaż model Phi-3-mini osiąga podobny poziom rozumienia języka i zdolności rozumowania, jak znacznie większe modele, w przypadku niektórych zadań jego rozmiar jest zasadniczo ograniczony. Model po prostu nie ma możliwości przechowywania obszernej wiedzy faktograficznej, co widać chociażby przy niskiej wydajności na TriviaQA. Uważamy jednak, że tę słabość można zaradzić poprzez rozszerzenie o wyszukiwarkę.