Microsoft Research introduceert Splitwise, een nieuwe techniek om de GPU-efficiëntie voor grote taalmodellen te vergroten

2 minuut. lezen

Uitgegeven op

Lees onze openbaarmakingspagina om erachter te komen hoe u MSPoweruser kunt helpen het redactieteam te ondersteunen Lees meer

Belangrijkste opmerkingen

- Splitwise is een doorbraak in LLM-inferentie-efficiëntie en duurzaamheid.

- Door de prompt- en tokenfasen te scheiden, ontgrendelt Splitwise nieuw potentieel in GPU-gebruik en stelt het cloudproviders in staat om meer vragen sneller te beantwoorden met hetzelfde energiebudget.

Grote taalmodellen (LLM's) transformeren de gebieden van natuurlijke taalverwerking en kunstmatige intelligentie, waardoor toepassingen mogelijk worden zoals het genereren van code, conversatieagenten en het samenvatten van teksten. Deze modellen vormen echter ook aanzienlijke uitdagingen voor cloudproviders, die steeds meer grafische verwerkingseenheden (GPU's) moeten inzetten om aan de groeiende vraag naar LLM-inferentie te voldoen.

Het probleem is dat GPU's niet alleen duur zijn, maar ook veel energie verbruiken, en dat de capaciteit om de elektriciteit te leveren die nodig is om ze te laten werken beperkt is. Als gevolg hiervan worden cloudproviders vaak geconfronteerd met het dilemma dat ze gebruikersvragen moeten afwijzen of hun operationele kosten en impact op het milieu moeten verhogen.

Om dit probleem aan te pakken hebben onderzoekers van Microsoft Azure een nieuwe techniek ontwikkeld, genaamd Splitwise, dat tot doel heeft de LLM-inferentie efficiënter en duurzamer te maken door de berekening in twee afzonderlijke fasen te splitsen en deze aan verschillende machines toe te wijzen. Je kunt uitgebreid over deze techniek lezen in hun “Splitwise: efficiënte generatieve LLM-inferentie met behulp van fasesplitsing’ onderzoekspapier.

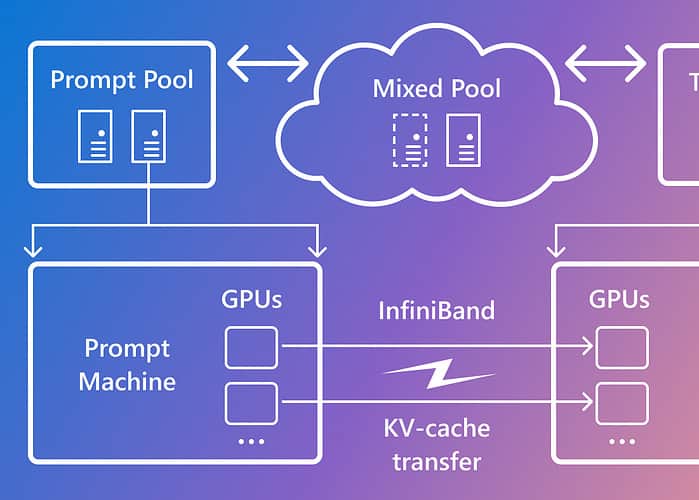

Splitwise is gebaseerd op de observatie dat LLM-inferentie bestaat uit twee fasen met verschillende kenmerken: de promptfase en de tokengeneratiefase. In de promptfase verwerkt het model de gebruikersinvoer (of prompt) parallel, met behulp van veel GPU-rekenkracht. In de fase voor het genereren van tokens genereert het model elk uitvoertoken opeenvolgend, waarbij veel GPU-geheugenbandbreedte wordt gebruikt. Naast het scheiden van de twee LLM-inferentiefasen in twee verschillende machinepools, gebruikte Microsoft een derde machinepool voor gemengde batching over de prompt- en tokenfasen, dynamisch gedimensioneerd op basis van realtime computervereisten.

Met Splitwise kon Microsoft het volgende bereiken:

- 1.4x hogere doorvoer tegen 20% lagere kosten dan huidige ontwerpen.

- 2.35x meer doorvoer met dezelfde kosten- en energiebudgetten.

Splitwise is een doorbraak in LLM-inferentie-efficiëntie en duurzaamheid. Door de prompt- en tokenfasen te scheiden, ontgrendelt Splitwise nieuw potentieel in GPU-gebruik en stelt het cloudproviders in staat om meer vragen sneller te beantwoorden met hetzelfde energiebudget. Splitwise is nu onderdeel van vLLM en kan ook met andere frameworks worden geïmplementeerd. De onderzoekers van Microsoft Azure zijn van plan hun werk voort te zetten om LLM-inferentie efficiënter en duurzamer te maken, en bedenken op maat gemaakte machinepools die zorgen voor maximale doorvoer, lagere kosten en energie-efficiëntie.