Opera wordt de eerste browser die lokale LLM's integreert

1 minuut. lezen

Bijgewerkt op

Lees onze openbaarmakingspagina om erachter te komen hoe u MSPoweruser kunt helpen het redactieteam te ondersteunen Lees meer

Belangrijkste opmerkingen

- Gebruikers kunnen nu rechtstreeks krachtige AI-modellen op hun apparaten beheren en openen, wat verbeterde privacy en snelheid biedt in vergelijking met cloudgebaseerde AI.

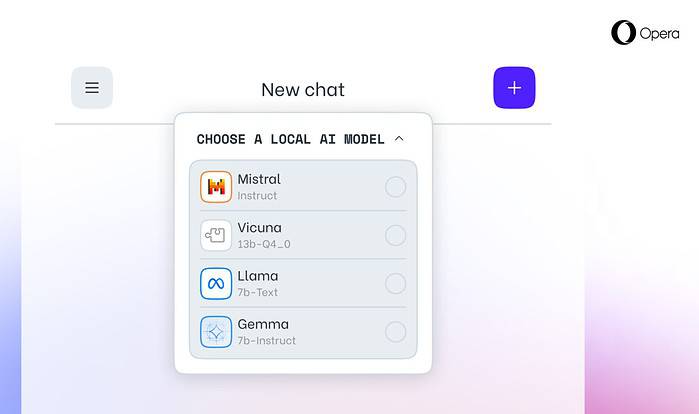

Opera vandaag aangekondigd experimentele ondersteuning voor 150 lokale grote taalmodellen (LLM's) binnen de Opera One-ontwikkelaarsbrowser. Met deze ondersteuning kunnen gebruikers nu rechtstreeks krachtige AI-modellen op hun apparaten beheren en openen, wat verbeterde privacy en snelheid biedt in vergelijking met cloudgebaseerde AI.

Uitgebreide keuze en privacy met lokale LLM's

De integratie van Opera omvat populaire LLM's zoals Meta's Llama, Vicuna, Google's Gemma, Mistral AI's Mixtral en nog veel meer. Lokale LLM's elimineren de noodzaak om gegevens met servers te delen, waardoor de privacy van gebruikers wordt beschermd. Opera's AI Feature Drops Program geeft ontwikkelaars vroegtijdige toegang tot deze geavanceerde functies.

Toegang krijgen tot lokale LLM's in Opera

Gebruikers kunnen bezoeken De ontwikkelaarssite van Opera om te upgraden naar Opera One Developer, waardoor de selectie en download van de lokale LLM van hun voorkeur mogelijk wordt. Hoewel ze opslagruimte nodig hebben (2-10 GB per model), kunnen lokale LLM's een aanzienlijke snelheidsboost bieden ten opzichte van cloudgebaseerde alternatieven, afhankelijk van de hardware.

Opera's toewijding aan AI-innovatie

“Door op deze manier lokale LLM’s te introduceren, kan Opera manieren gaan verkennen om ervaringen en kennis op te bouwen binnen de snel opkomende lokale AI-ruimte”, aldus Krystian Kolondra, EVP Browsers en Gaming bij Opera.