A Microsoft bemutatja a Phi-3 modellcsaládot, amely felülmúlja osztálya többi modelljét

2 perc olvas

Publikálva

Olvassa el közzétételi oldalunkat, hogy megtudja, hogyan segítheti az MSPowerusert a szerkesztői csapat fenntartásában Tovább

2023 decemberében a Microsoft kiadta Phi-2 2.7 milliárd paraméterrel rendelkező modell, amely a 13 milliárdnál kevesebb paramétert tartalmazó alapnyelvi modellek között a legkorszerűbb teljesítményt nyújtotta. Az elmúlt négy hónapban számos más modell, amely megjelent, felülmúlta a Phi-2-t. Nemrég a Meta kiadta a Llama-3 modellcsaládot, amely felülmúlta az összes korábban kiadott nyílt forráskódú modellt.

Tegnap este a Microsoft Research bejelentette a Phi-3 modellcsaládot keresztül műszaki jelentést. Három modell található a Phi-3 családban:

- phi-3-mini (3.8B)

- phi-3-small (7B)

- phi-3-medium (14B)

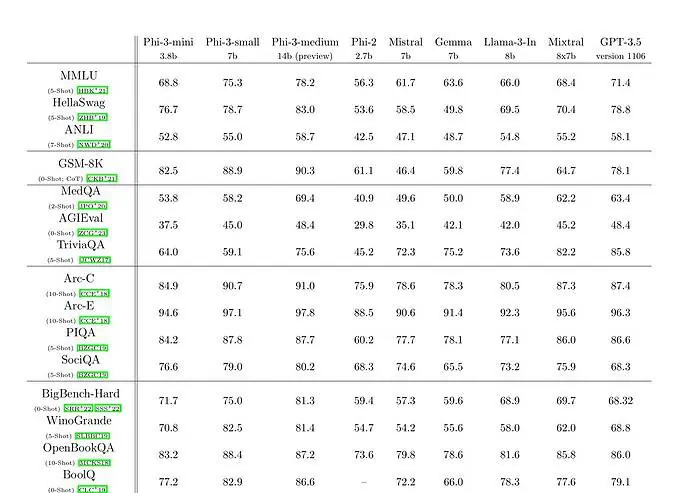

A 3 milliárd paraméteres nyelvi modellel rendelkező phi-3.8-mini 3.3 billió tokenre van kiképezve. A benchmarkok szerint a phi-3-mini legyőzi a Mixtral 8x7B-t és a GPT-3.5-öt. A Microsoft azt állítja, hogy ez a modell elég kicsi ahhoz, hogy telefonon is telepíthető legyen. A Microsoft a phi-2-höz használt adatkészlet felnagyított változatát használta, amely erősen szűrt webadatokból és szintetikus adatokból állt. A Microsoft műszaki dokumentumban szereplő benchmark eredményei szerint a phi-3-small és a phi-3-medium lenyűgöző, 75.3-as, illetve 78.2-es MMLU-pontszámot ér el.

Ami az LLM-képességeket illeti, míg a Phi-3-mini modell hasonló szintű nyelvértést és érvelési képességet ér el, mint a jóval nagyobb modellek esetében, bizonyos feladatoknál mégis alapvetően korlátozza a mérete. A modell egyszerűen nem képes kiterjedt tényszerű ismereteket tárolni, ami például a TriviaQA alacsony teljesítménye mellett is látható. Úgy gondoljuk azonban, hogy ez a gyengeség megoldható egy keresőmotorral történő kiegészítéssel.