微軟研究院推出 Splitwise,一種提升大型語言模式 GPU 效率的新技術

2分鐘讀

發表於

重點說明

- Splitwise 是 LLM 推理效率和永續性的突破。

- 透過分離提示階段和令牌階段,Splitwise 釋放了 GPU 使用的新潛力,並使雲端提供者能夠在相同的功率預算下更快地服務更多查詢。

大型語言模型 (LLM) 正在改變自然語言處理和人工智慧領域,支援程式碼生成、對話代理和文字摘要等應用。然而,這些模型也為雲端供應商帶來了重大挑戰,他們需要部署越來越多的圖形處理單元 (GPU) 來滿足對 LLM 推理不斷增長的需求。

問題在於 GPU 不僅價格昂貴,而且耗電巨大,而且提供運行 GPU 所需電力的能力有限。因此,雲端供應商經常面臨要么拒絕用戶查詢,要么增加營運成本和環境影響的兩難。

為了解決這個問題,Microsoft Azure 的研究人員開發了一種新技術,稱為 Splitwise,旨在透過將計算分為兩個不同的階段並將其分配給不同的機器,使 LLM 推理更加高效和可持續。您可以在他們的“Splitwise:使用相分裂的高效生成 LLM 推理“ 研究論文。

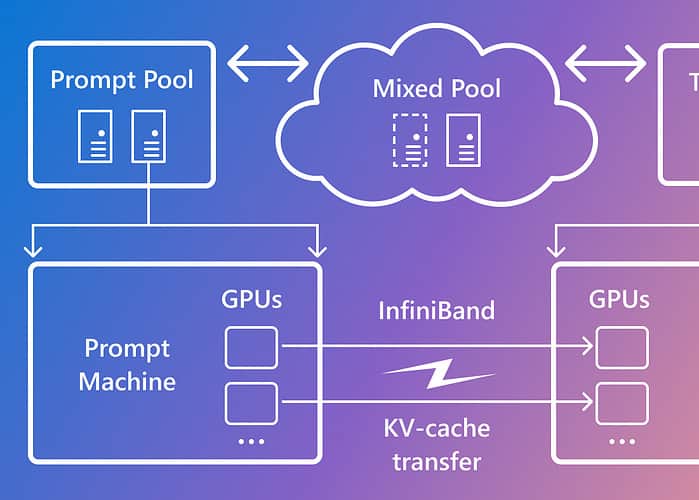

Splitwise 基於這樣的觀察:LLM 推理由具有不同特徵的兩個階段組成:提示階段和令牌生成階段。在提示階段,模型使用大量 GPU 計算並行處理使用者輸入或提示。在令牌產生階段,模型使用大量 GPU 記憶體頻寬依序產生每個輸出令牌。除了將兩個 LLM 推理階段分成兩個不同的機器池之外,微軟還使用第三個機器池在提示和令牌階段進行混合批次處理,並根據即時計算需求動態調整大小。

使用 Splitwise,Microsoft 能夠實現以下目標:

- 與目前設計相比,吞吐量提高了 1.4 倍,成本降低了 20%。

- 在成本和功耗預算相同的情況下,吞吐量提高 2.35 倍。

Splitwise 是 LLM 推理效率和永續性的突破。透過分離提示階段和令牌階段,Splitwise 釋放了 GPU 使用的新潛力,並使雲端提供者能夠在相同的功率預算下更快地服務更多查詢。 Splitwise 現在是 vLLM 的一部分,也可以與其他框架一起實現。 Microsoft Azure 的研究人員計劃繼續致力於使 LLM 推理更加高效和可持續,並設想客製化的機器池可實現最大吞吐量、降低成本和能源效率。