Opera 成為第一個整合本地法學碩士的瀏覽器

1分鐘讀

更新了

重點說明

- 用戶現在可以在其設備上直接管理和存取強大的人工智慧模型,與基於雲端的人工智慧相比,可提供增強的隱私性和速度。

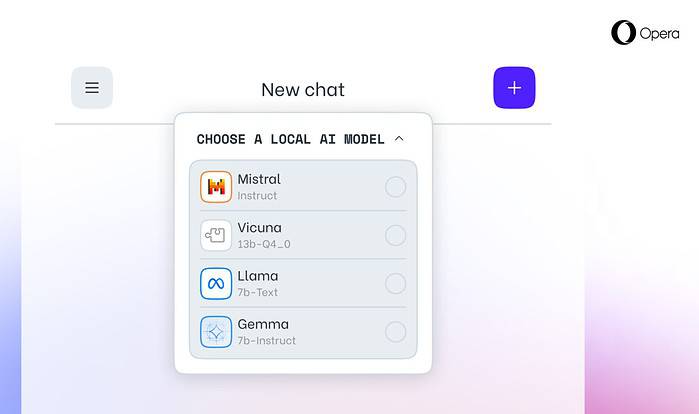

今天的歌劇 宣布 在其 Opera One 開發者瀏覽器中對 150 個本地大語言模型 (LLM) 提供實驗性支援。有了這種支持,用戶現在可以在其設備上直接管理和存取強大的人工智慧模型,與基於雲端的人工智慧相比,提供增強的隱私性和速度。

本地法學碩士的更多選擇和隱私

Opera 的整合包括流行的法學碩士,如 Meta 的 Llama、Vicuna、Google 的 Gemma、Mistral AI 的 Mixtral 等等。本地法學碩士無需與伺服器共享數據,從而保護用戶隱私。 Opera 的 AI 功能投放計畫讓開發人員能夠儘早使用這些尖端功能。

如何在 Opera 中訪問本地法學碩士

用戶可以訪問 Opera 的開發者網站 升級到 Opera One Developer,從而能夠選擇和下載他們首選的本地 LLM。雖然需要儲存空間(每個型號 2-10 GB),但本地 LLM 可以比基於雲端的替代方案提供顯著的速度提升,具體取決於硬體。

Opera 對人工智慧創新的承諾

Opera 瀏覽器和遊戲執行副總裁 Krystian Kolondra 表示:“透過這種方式引入本地法學碩士,Opera 能夠開始探索在快速新興的本地人工智慧領域構建經驗和專業知識的方法。”