如何使用 NVIDIA 本地 AI 聊天机器人 Chat with RTX?

6分钟读

更新

探索本地人工智能聊天机器人的世界 与 RTX 聊天,Nvidia 开发的新解决方案。本指南使用户能够下载、配置并充分利用 Chat with RTX 的潜力,促进离线与智能 AI 模型的互动,并使用数据丰富对话。因此,它向您展示了如何使用 RTX 聊天。

我们将指导您下载、安装和使用 Chat with RTX,包括您的数据(文本文件)和 YouTube 视频,使您能够参与丰富的对话并从离线来源中解锁有价值的见解。

前提课程:

- Nvidia RTX 30 系列或 40 系列图形处理单元 (GPU)

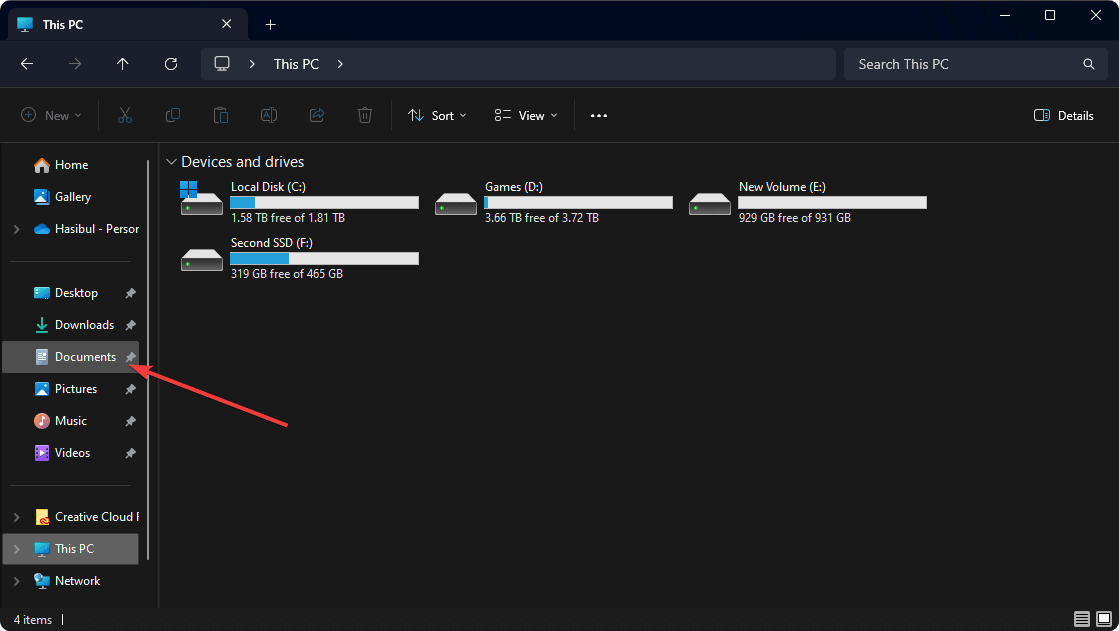

- 至少 100 GB 可用磁盘空间

- 16 GB 系统 RAM

- 11的Windows操作系统

下载 RTX 聊天:

- 开始下载: 下载 与 Nvidia 官方网站上的 RTX 安装程序聊天。该压缩文件大约为 35GB,因此请确保可靠的互联网连接和充足的下载过程时间。

- 提取内容: 下载完成后,右键单击下载的文件夹并选择“全部解压”以解压其内容。

- 运行安装程序: 找到 SETUP.EXE 文件放在解压的文件夹中,然后按照屏幕上的说明继续安装。

- 指定存储位置: 在安装过程中指定一个至少有 100GB 可用空间的目录来存储 Chat with RTX 及其相关数据。

- 安装过程: 安装过程中请耐心等待,最多可能需要 45 分钟才能完成。系统可能会出现暂时的速度减慢,特别是在配置人工智能模型期间。

- 失败时重新安装: 如果安装遇到错误,只需重新运行安装程序并选择相同的数据存储位置即可。该过程将从中断点恢复。

- 启动应用程序: 成功安装后,将创建 Chat with RTX 的桌面快捷方式,并且该应用程序将自动在您的默认 Web 浏览器中启动。这是使用 RTX 聊天的方法。

增强 RTX 与您的数据的聊天

通过将您的数据集集成到平台中,解锁 Chat with RTX 的全部功能。

- 整理您的数据: 创建专用文件夹来存储数据,确保与以下文件格式兼容 .txt、.pdf 或 .doc。

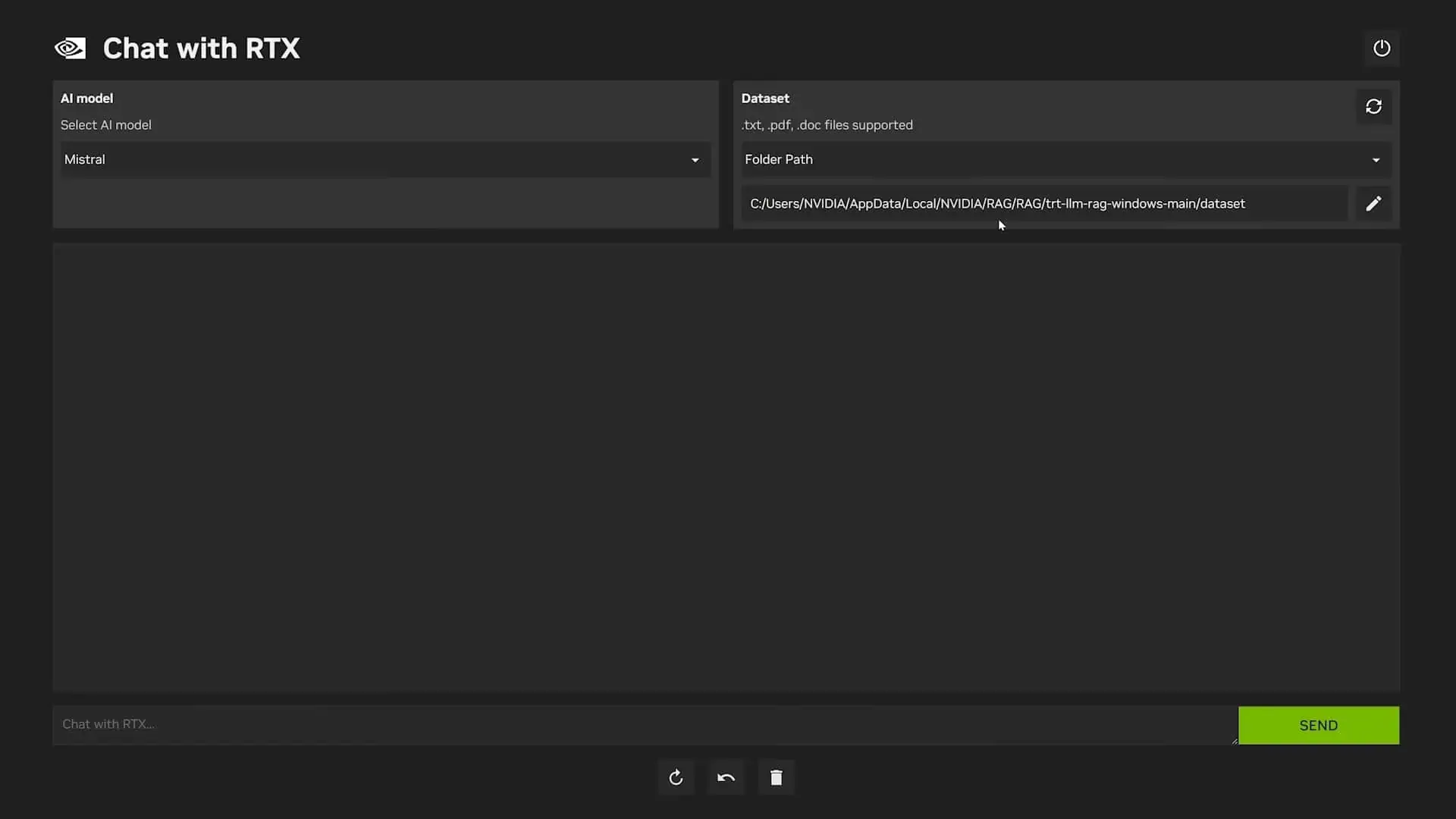

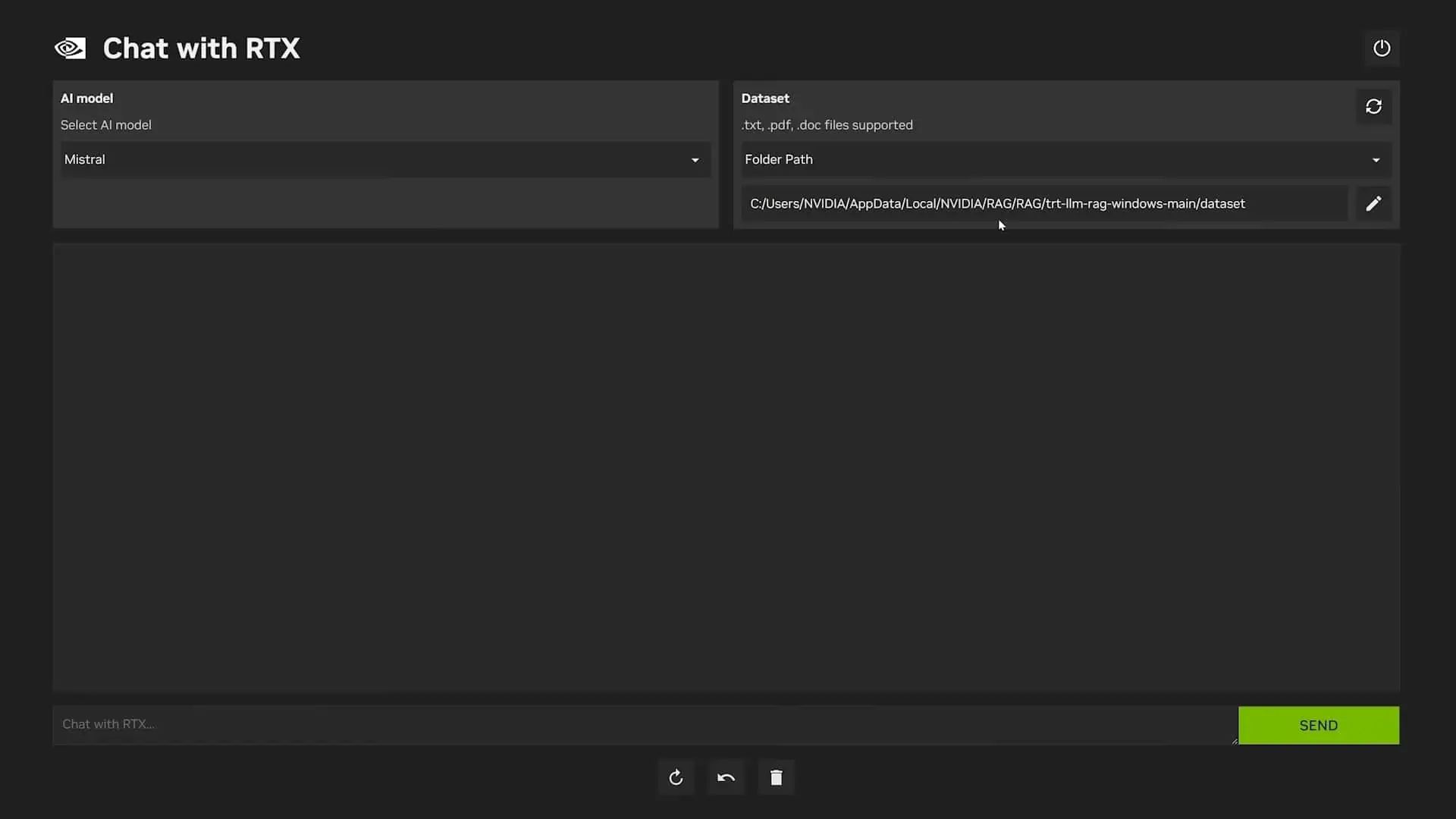

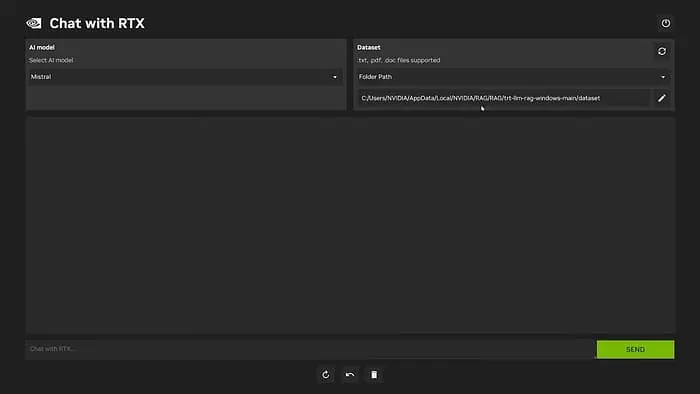

- 访问数据文件夹: 实行 与 RTX 聊天 然后单击“数据集”部分中的钢笔图标以选择您的数据文件夹。

- 确认选择: 导航到包含数据的文件夹并确认选择。

- 刷新模型: 在 Chat with RTX 中刷新模型以合并新添加的数据集。每当添加新数据或在不同数据集之间切换时,请重复此步骤。

- 选择您的人工智能模型: 从可用选项中选择所需的 AI 模型(例如 Llama 2 或 Mistral)并开始查询。请记住,更具体的问题往往会产生更准确的答案。

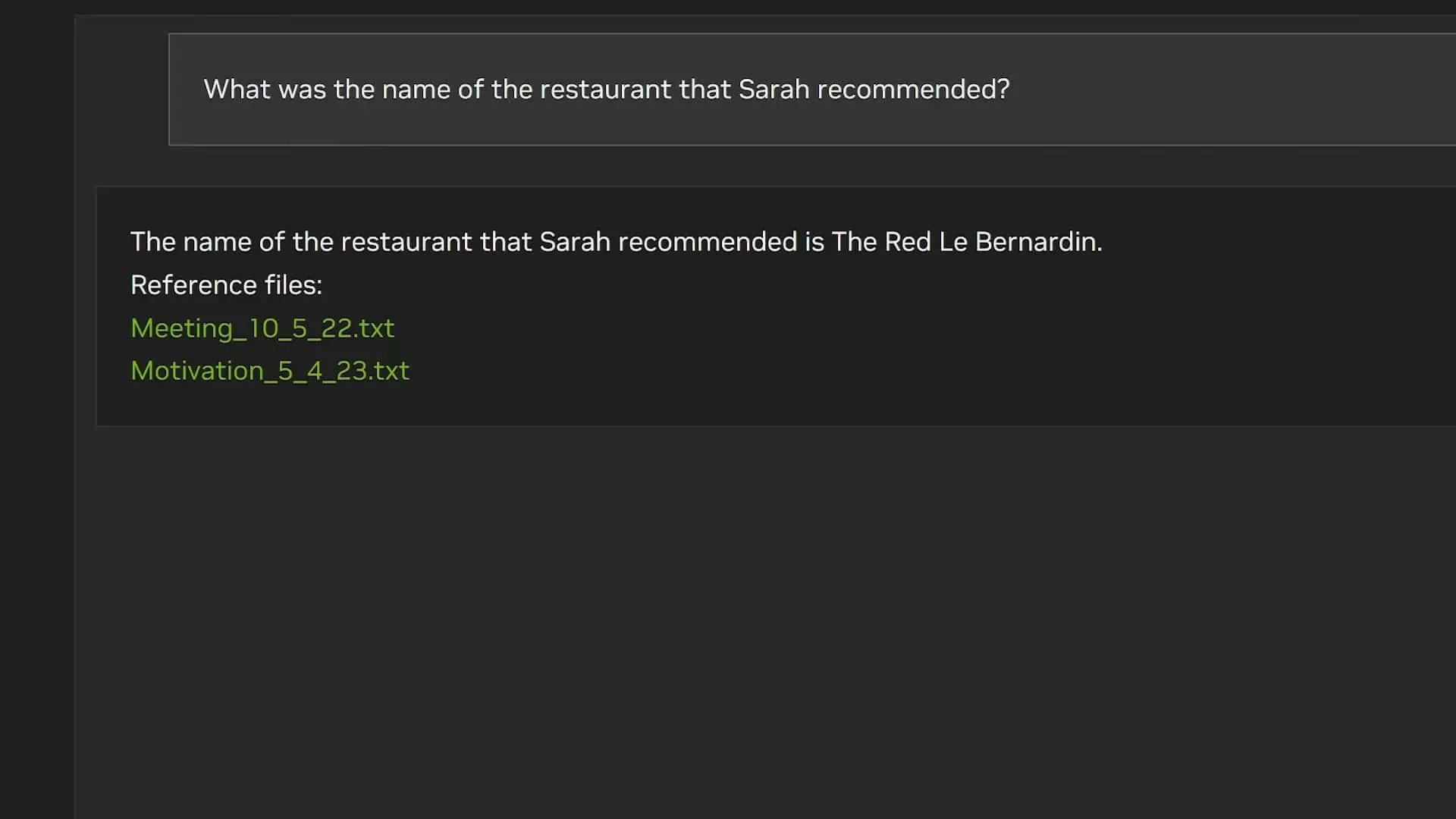

人工智能模型是 在海量数据集上训练的计算机程序 至 识别模式、做出预测或执行特定任务。它们就像数字大脑一样,从所接触的数据中学习并利用这些知识来实现各种目标。 - 上下文限制: Chat with RTX 不考虑响应之间的上下文,有时可能会引用不正确的数据。

- 故障排除: 如果您在使用 RTX 聊天时遇到任何问题,请删除位于“

C:\Users\AppData\Local\NVIDIA\ChatWithRTX\RAG\trt-llm-rag-windows-main\config\preferences.json”可能会解决问题。这是使用 RTX 聊天的方法

如何通过 YouTube 使用 RTX 聊天

通过合并 YouTube 视频及其相应的文字记录,扩展 Chat with RTX 的功能。

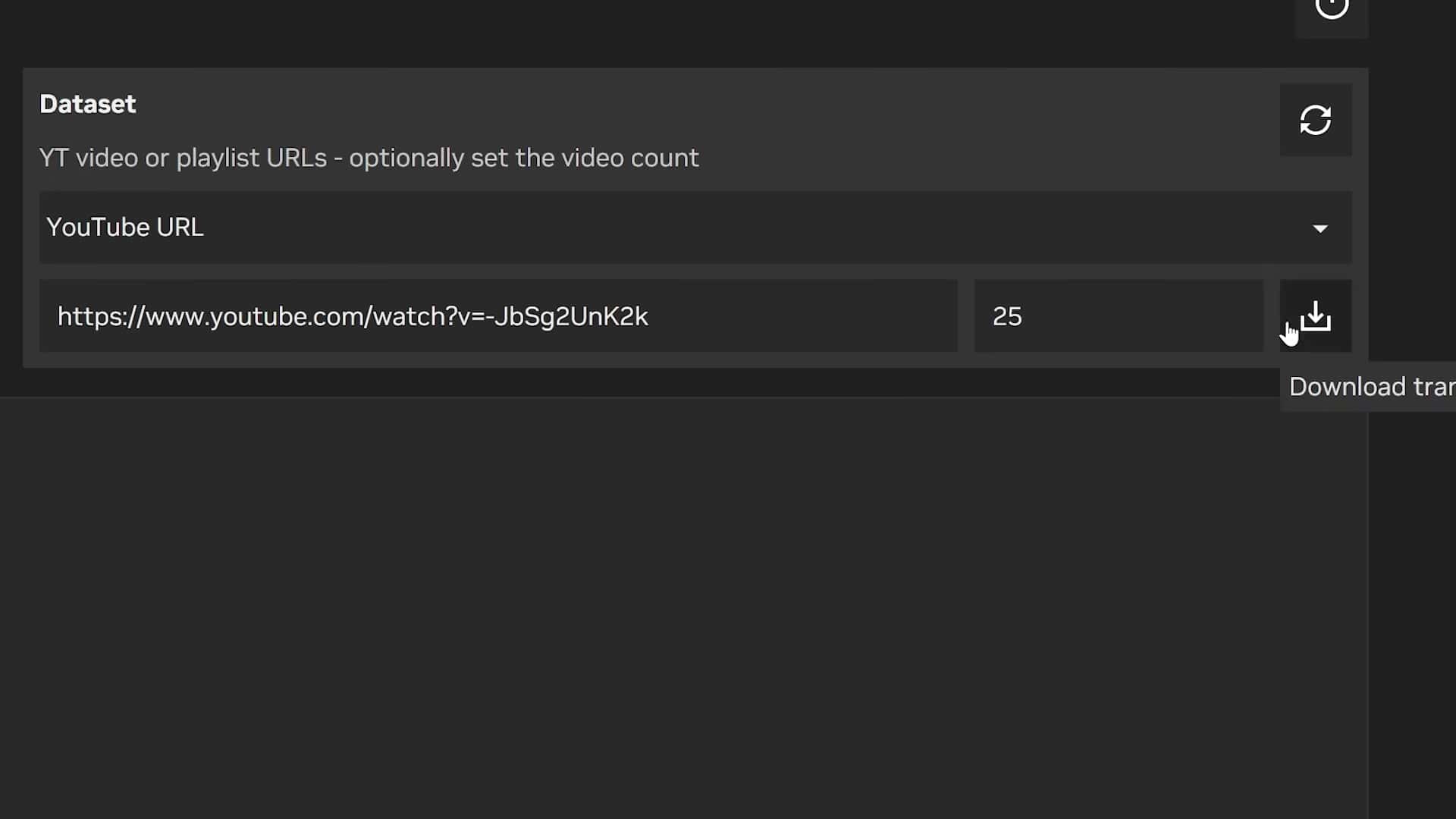

- 选择 YouTube 选项: 在 Chat with RTX 中,从“数据集”下拉菜单中选择“YouTube”选项。

- 提供视频链接: 将链接粘贴到 YouTube 视频或播放列表,并指定您要下载的最大转录本数量。

- 开始下载: 开始下载过程并等待检索成绩单。完成后,刷新数据集。

- 参与对话: 使用基于视频文字记录的特定问题开始使用 Chat with RTX 进行对话。

- 切换视频集: 要切换到另一组视频,请通过应用程序内访问的资源管理器窗口手动删除旧的文字记录。这是使用 RTX 聊天的方法

为什么应该使用 RTX 聊天?

- 1.线下AI互动: 无需依赖互联网连接即可使用智能 AI 模型,即使在远程位置也能确保隐私和不间断访问。

- 2. 个性化聊天机器人创建: 利用您的数据集(文本文档、YouTube 视频)来训练和个性化 Chat with RTX,根据您的特定需求和兴趣定制其响应。

- 3. 增强隐私: 保持对数据的完全控制,因为数据仍然存储在设备本地,从而消除对基于云的存储和潜在隐私泄露的担忧。

- 4. 更快的响应时间: 受益于 Nvidia RTX GPU 的处理能力,Chat with RTX 能够快速高效地生成响应,最大限度地减少对话期间的延迟。

- 5. 多样化应用的潜力: 探索休闲对话之外的各种用例,例如研究协助、从个人数据中提取信息以及创意写作提示。

- 6. 持续学习和改进: 通过添加新数据集和探索不同的 AI 模型来改进 Chat with RTX 的功能,从而促进个性化和不断发展的对话体验。

- 7. 离线任务的可访问性: 利用 Chat with RTX 执行需要在离线情况下访问互联网的任务,例如总结下载的研究论文或在不受在线干扰的情况下生成创意内容。

- 8. 潜在的成本节省: 消除与基于云的人工智能服务相关的订阅费,从长远来看可能会降低成本。

总体而言,Chat with RTX 提供了离线功能、数据隐私、个性化和强大处理功能的独特组合,使其成为寻求多功能且安全的 AI 聊天机器人体验的用户的一个引人注目的选择。这是我们的指南,向您展示如何使用 RTX 聊天。

1. 运行 Chat with RTX 有哪些硬件要求?

使用 RTX 聊天需要强大的显卡来处理复杂的 AI 计算。您需要 Nvidia RTX 30 系列或 40 系列 GPU,具有至少 16 GB 的系统 RAM 和 100 GB 的可用磁盘空间。此外,操作系统必须是 Windows 11。

2. 在没有互联网连接的情况下,我可以使用 RTX 聊天吗?

是的,Chat with RTX 专为离线使用而设计。一旦下载了必要的人工智能模型和数据,您就可以在没有互联网连接的情况下与聊天机器人进行交互。

3. Chat with RTX 可以使用哪些类型的数据?

Chat with RTX 支持基于文本的数据格式,包括 .txt、.pdf 和 .doc 文件。您可以创建一个包含数据的专用文件夹,并将其集成到平台中以进行个性化对话。

4. Chat with RTX 的响应准确度如何?

Chat with RTX 的响应准确性取决于数据质量、相关性和问题特异性。虽然人工智能模型是在大型数据集上进行训练的,但可能会丢失上下文。建议提出格式正确的问题以获得更好的结果。