Opera 成为第一个集成本地法学硕士的浏览器

1分钟读

更新

重点说明

- 用户现在可以在其设备上直接管理和访问强大的人工智能模型,与基于云的人工智能相比,可提供增强的隐私性和速度。

今天的歌剧 公布 在其 Opera One 开发者浏览器中对 150 个本地大语言模型 (LLM) 提供实验性支持。有了这种支持,用户现在可以在其设备上直接管理和访问强大的人工智能模型,与基于云的人工智能相比,提供增强的隐私性和速度。

本地法学硕士的更多选择和隐私

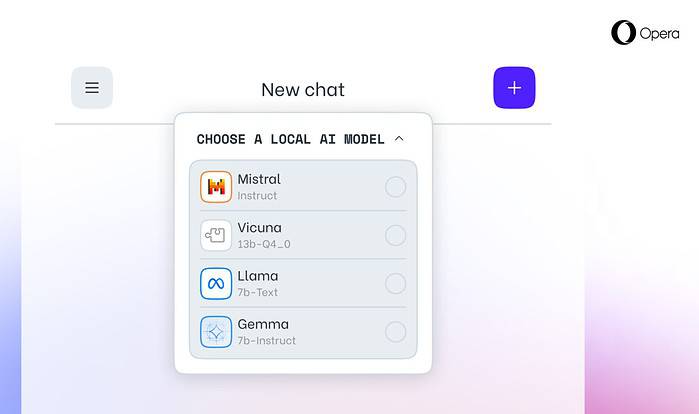

Opera 的集成包括流行的法学硕士,如 Meta 的 Llama、Vicuna、Google 的 Gemma、Mistral AI 的 Mixtral 等等。本地法学硕士无需与服务器共享数据,从而保护用户隐私。 Opera 的 AI 功能投放计划让开发人员能够尽早使用这些尖端功能。

如何在 Opera 中访问本地法学硕士

用户可以访问 Opera 的开发者网站 升级到 Opera One Developer,从而能够选择和下载他们首选的本地 LLM。虽然需要存储空间(每个模型 2-10 GB),但本地 LLM 可以比基于云的替代方案提供显着的速度提升,具体取决于硬件。

Opera 对人工智能创新的承诺

Opera 浏览器和游戏执行副总裁 Krystian Kolondra 表示:“通过这种方式引入本地法学硕士,Opera 能够开始探索在快速新兴的本地人工智能领域构建经验和专业知识的方法。”