Microsoft Research giới thiệu Splitwise, một kỹ thuật mới giúp tăng hiệu suất GPU cho Mô hình ngôn ngữ lớn

2 phút đọc

Được đăng trên

Đọc trang tiết lộ của chúng tôi để tìm hiểu cách bạn có thể giúp MSPoweruser duy trì nhóm biên tập Tìm hiểu thêm

Ghi chú chính

- Splitwise là một bước đột phá về hiệu quả và tính bền vững của suy luận LLM.

- Bằng cách tách biệt các giai đoạn lời nhắc và mã thông báo, Splitwise mở ra tiềm năng mới trong việc sử dụng GPU và cho phép các nhà cung cấp đám mây phân phát nhiều truy vấn nhanh hơn trong cùng một mức năng lượng.

Các mô hình ngôn ngữ lớn (LLM) đang chuyển đổi các lĩnh vực xử lý ngôn ngữ tự nhiên và trí tuệ nhân tạo, cho phép các ứng dụng như tạo mã, tác nhân đàm thoại và tóm tắt văn bản. Tuy nhiên, những mô hình này cũng đặt ra những thách thức đáng kể cho các nhà cung cấp đám mây, những người cần triển khai ngày càng nhiều đơn vị xử lý đồ họa (GPU) để đáp ứng nhu cầu suy luận LLM ngày càng tăng.

Vấn đề là GPU không chỉ đắt tiền mà còn ngốn điện và khả năng cung cấp điện cần thiết để chạy chúng còn hạn chế. Do đó, các nhà cung cấp đám mây thường phải đối mặt với tình thế tiến thoái lưỡng nan là từ chối các truy vấn của người dùng hoặc tăng chi phí vận hành và tác động đến môi trường.

Để giải quyết vấn đề này, các nhà nghiên cứu tại Microsoft Azure đã phát triển một kỹ thuật mới gọi là Chia đôi, nhằm mục đích làm cho suy luận LLM hiệu quả và bền vững hơn bằng cách chia tính toán thành hai giai đoạn riêng biệt và phân bổ chúng cho các máy khác nhau. Bạn có thể đọc chi tiết về kỹ thuật này trong “Splitwise: Suy luận LLM sáng tạo hiệu quả bằng cách sử dụng phân tách pha”Tài liệu nghiên cứu.

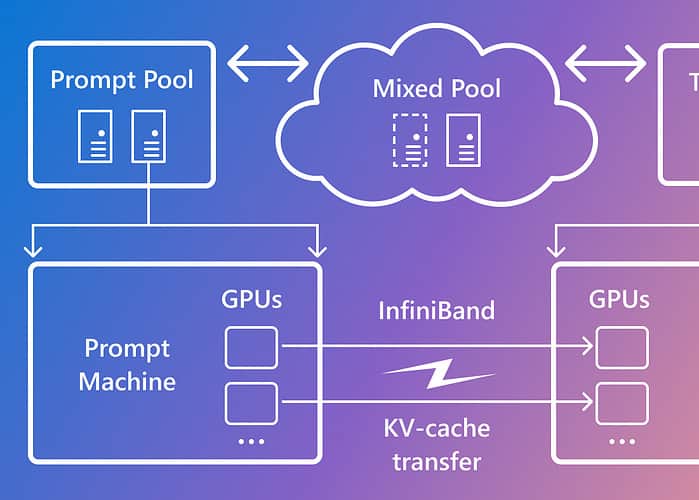

Splitwise dựa trên quan sát rằng suy luận LLM bao gồm hai giai đoạn với các đặc điểm khác nhau: giai đoạn nhắc nhở và giai đoạn tạo mã thông báo. Trong giai đoạn nhắc, mô hình xử lý song song đầu vào của người dùng hoặc lời nhắc, sử dụng nhiều tính toán GPU. Trong giai đoạn tạo mã thông báo, mô hình tạo tuần tự từng mã thông báo đầu ra, sử dụng nhiều băng thông bộ nhớ GPU. Ngoài việc tách hai giai đoạn suy luận LLM thành hai nhóm máy riêng biệt, Microsoft còn sử dụng nhóm máy thứ ba để phân khối hỗn hợp giữa các giai đoạn nhắc và mã thông báo, có kích thước linh hoạt dựa trên nhu cầu tính toán theo thời gian thực.

Sử dụng Splitwise, Microsoft đã có thể đạt được những điều sau:

- Thông lượng cao hơn 1.4 lần với chi phí thấp hơn 20% so với thiết kế hiện tại.

- Thông lượng tăng gấp 2.35 lần với cùng mức chi phí và điện năng.

Splitwise là một bước đột phá về hiệu quả và tính bền vững của suy luận LLM. Bằng cách tách biệt các giai đoạn lời nhắc và mã thông báo, Splitwise mở ra tiềm năng mới trong việc sử dụng GPU và cho phép các nhà cung cấp đám mây phân phát nhiều truy vấn nhanh hơn trong cùng một mức năng lượng. Splitwise hiện là một phần của vLLM và cũng có thể được triển khai với các khung khác. Các nhà nghiên cứu tại Microsoft Azure có kế hoạch tiếp tục công việc làm cho suy luận LLM hiệu quả và bền vững hơn, đồng thời hình dung các nhóm máy được thiết kế riêng sẽ thúc đẩy thông lượng tối đa, giảm chi phí và tiết kiệm năng lượng.