Opera trở thành trình duyệt đầu tiên tích hợp LLM cục bộ

1 phút đọc

Cập nhật vào

Đọc trang tiết lộ của chúng tôi để tìm hiểu cách bạn có thể giúp MSPoweruser duy trì nhóm biên tập Tìm hiểu thêm

Ghi chú chính

- Giờ đây, người dùng có thể trực tiếp quản lý và truy cập các mô hình AI mạnh mẽ trên thiết bị của mình, mang lại sự riêng tư và tốc độ nâng cao so với AI dựa trên đám mây.

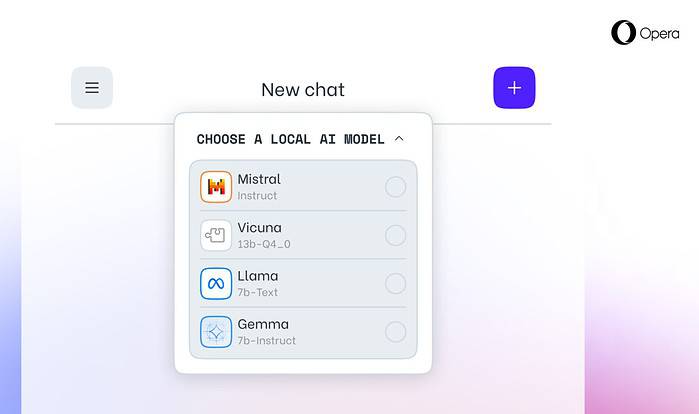

Opera ngày nay công bố hỗ trợ thử nghiệm cho 150 mô hình ngôn ngữ lớn địa phương (LLM) trong trình duyệt dành cho nhà phát triển Opera One. Với sự hỗ trợ này, giờ đây người dùng có thể trực tiếp quản lý và truy cập các mô hình AI mạnh mẽ trên thiết bị của mình, mang lại sự riêng tư và tốc độ nâng cao so với AI dựa trên đám mây.

Lựa chọn mở rộng và quyền riêng tư với LLM địa phương

Sự tích hợp của Opera bao gồm các LLM phổ biến như Llama của Meta, Vicuna, Gemma của Google, Mixtral của Mistral AI và nhiều LLM khác. LLM cục bộ loại bỏ nhu cầu chia sẻ dữ liệu với máy chủ, bảo vệ quyền riêng tư của người dùng. Chương trình giảm tính năng AI của Opera cho phép các nhà phát triển truy cập sớm vào các tính năng tiên tiến này.

Cách truy cập LLM cục bộ trong Opera

Người dùng có thể truy cập Trang web dành cho nhà phát triển của Opera để nâng cấp lên Opera One Developer, cho phép lựa chọn và tải xuống LLM cục bộ ưa thích của họ. Mặc dù yêu cầu dung lượng lưu trữ (2-10 GB cho mỗi kiểu máy), LLM cục bộ có thể tăng tốc độ đáng kể so với các lựa chọn thay thế dựa trên đám mây, tùy thuộc vào phần cứng.

Cam kết của Opera đối với sự đổi mới AI

Krystian Kolondra, EVP Browsers and Gaming tại Opera cho biết: “Việc giới thiệu LLM địa phương theo cách này cho phép Opera bắt đầu khám phá các cách xây dựng trải nghiệm và bí quyết trong không gian AI địa phương đang phát triển nhanh chóng”.