Opera blir den första webbläsaren som integrerar lokala LLM:er

1 min. läsa

Uppdaterad den

Läs vår informationssida för att ta reda på hur du kan hjälpa MSPoweruser upprätthålla redaktionen Läs mer

Viktiga anteckningar

- Användare kan nu direkt hantera och komma åt kraftfulla AI-modeller på sina enheter, vilket erbjuder förbättrad integritet och snabbhet jämfört med molnbaserad AI.

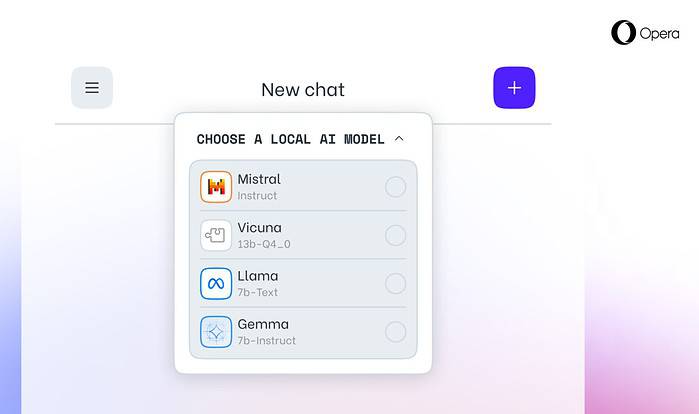

Opera idag meddelade experimentellt stöd för 150 lokala stora språkmodeller (LLM) i sin Opera One-utvecklarwebbläsare. Med det här stödet kan användare nu direkt hantera och komma åt kraftfulla AI-modeller på sina enheter, vilket erbjuder förbättrad integritet och snabbhet jämfört med molnbaserad AI.

Utökat val och sekretess med lokala LLM:er

Operas integration inkluderar populära LLM:er som Metas Llama, Vicuna, Googles Gemma, Mistral AI:s Mixtral och många fler. Lokala LLM:er eliminerar behovet av att dela data med servrar, vilket skyddar användarnas integritet. Operas AI Feature Drops Program ger utvecklare tidig tillgång till dessa banbrytande funktioner.

Hur man kommer åt lokala LLM i Opera

Användare kan besöka Operas utvecklarsajt för att uppgradera till Opera One Developer, vilket möjliggör val och nedladdning av deras föredragna lokala LLM. Samtidigt som de kräver lagringsutrymme (2-10 GB per modell), kan lokala LLM:er erbjuda en betydande hastighetsökning jämfört med molnbaserade alternativ, beroende på hårdvara.

Operas engagemang för AI-innovation

"Att introducera lokala LLM på detta sätt gör att Opera kan börja utforska sätt att bygga upplevelser och kunnande inom det snabbt framväxande lokala AI-området", säger Krystian Kolondra, EVP Browsers and Gaming på Opera.