Microsoft Research introducerar Splitwise, en ny teknik för att öka GPU-effektiviteten för stora språkmodeller

2 min. läsa

Publicerad den

Läs vår informationssida för att ta reda på hur du kan hjälpa MSPoweruser upprätthålla redaktionen Läs mer

Viktiga anteckningar

- Splitwise är ett genombrott inom LLM slutledningseffektivitet och hållbarhet.

- Genom att separera prompt- och tokenfaserna låser Splitwise upp ny potential i GPU-användning och gör det möjligt för molnleverantörer att betjäna fler frågor snabbare under samma energibudget.

Stora språkmodeller (LLM) omvandlar områdena naturlig språkbehandling och artificiell intelligens, vilket möjliggör tillämpningar som kodgenerering, konversationsagenter och textsammanfattning. Men dessa modeller innebär också betydande utmaningar för molnleverantörer, som behöver distribuera fler och fler grafikprocessorer (GPU) för att möta den växande efterfrågan på LLM-inferens.

Problemet är att grafikprocessorer inte bara är dyra, utan också strömkrävande, och kapaciteten att tillhandahålla den elektricitet som behövs för att driva dem är begränsad. Som ett resultat står molnleverantörer ofta inför dilemmat att antingen avvisa användarfrågor eller öka deras driftskostnader och miljöpåverkan.

För att lösa detta problem har forskare vid Microsoft Azure utvecklat en ny teknik som kallas Splitwise, som syftar till att göra LLM-inferens mer effektiv och hållbar genom att dela upp beräkningen i två distinkta faser och allokera dem till olika maskiner. Du kan läsa om denna teknik i detalj i deras "Splitwise: Effektiv generativ LLM-inferens med hjälp av fasdelning" uppsats.

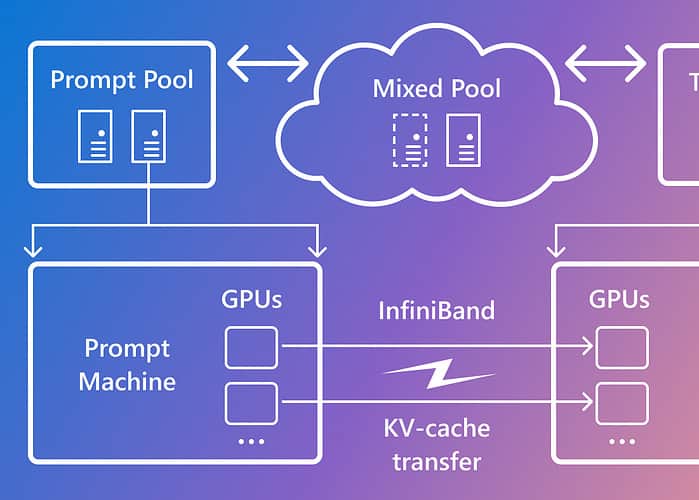

Splitwise är baserad på observationen att LLM-inferens består av två faser med olika egenskaper: promptfasen och tokengenereringsfasen. I promptfasen bearbetar modellen användarinmatningen, eller prompten, parallellt med mycket GPU-beräkning. I tokengenereringsfasen genererar modellen varje utdatatoken sekventiellt och använder mycket GPU-minnesbandbredd. Förutom att separera de två LLM-inferensfaserna i två distinkta maskinpooler, använde Microsoft en tredje maskinpool för blandad batchning över prompt- och tokenfaserna, dynamiskt dimensionerade baserat på realtidsberäkningskrav.

Med Splitwise kunde Microsoft uppnå följande:

- 1.4 gånger högre genomströmning till 20 % lägre kostnad än nuvarande konstruktioner.

- 2.35 gånger mer genomströmning med samma kostnads- och energibudgetar.

Splitwise är ett genombrott inom LLM slutledningseffektivitet och hållbarhet. Genom att separera prompt- och tokenfaserna låser Splitwise upp ny potential i GPU-användning och gör det möjligt för molnleverantörer att betjäna fler frågor snabbare under samma energibudget. Splitwise är nu en del av vLLM och kan även implementeras med andra ramverk. Forskarna vid Microsoft Azure planerar att fortsätta sitt arbete med att göra LLM-inferens mer effektiv och hållbar och föreställer sig skräddarsydda maskinpooler som driver maximal genomströmning, minskade kostnader och energieffektivitet.