22 Chockerande AI-elektricitetsanvändningsstatistik för 2024 och framåt

9 min. läsa

Publicerad den

Läs vår informationssida för att ta reda på hur du kan hjälpa MSPoweruser upprätthålla redaktionen Läs mer

AI tar världen med storm och innovativa industrier på sätt som man aldrig trodde var möjligt. Men idag slog jag ihop siffrorna för att hitta den mest chockerande statistiken över AI-elanvändning.

Den stora mängden data och processorkraft som krävs för att träna och utveckla AI-modeller och algoritmer, såväl som den stora ökningen av dagliga förfrågningar, kräver enorma mängder elektricitet. Kan vi anpassa oss för att möta en sådan efterfrågan?

Låt oss se!

Viktig AI-elektricitetsanvändningsstatistik

AI-strömförbrukningen växer exponentiellt. Dessa nyckel AI Elstatistik visar var vi är nu och vilka problem världen kan möta i framtiden.

- 2022 bidrog AI till 2 % av den globala energianvändningen – lika mycket som ett litet land.

- År 2026 uppskattar IEA att AI kommer att använda lika mycket el som Japan.

- Att köra AI-modeller och servrar kräver två till tre gånger kraften jämfört med konventionella applikationer.

- AI kommer att vara ett starkt bidrag till den förväntade ökningen på 80 % av efterfrågan på datacenter i USA till 2030.

- 200 miljoner ChatGPT-förfrågningar görs varje dag, vilket förbrukar en halv miljon kilowattimmar elektricitet.

- GPT-3-modellen använder lika mycket ström som 130 amerikanska hem på ett år.

- Elon Musk tror att det inte kommer att finnas tillräckligt med el för att driva alla AI-chips till 2025.

Global AI-elektricitetsanvändningsstatistik

Dessa elanvändningsstatistik för AI ger en global översikt över de nuvarande nivåerna av AI-strömförbrukning.

1. 2022 bidrog AI till 2 % av den globala energianvändningen – lika mycket som ett litet land.

(Källa: Vox)

Internationella energibyrån (IEA) varnade för att bara 2022 gick 2% av världens energi till att driva AI och kryptovalutarelaterade uppgifter. Förutom elektricitet kräver den infrastruktur som behövs för att stödja denna teknik stora datacenter, plast, metaller, ledningar, vatten och arbetskraft, vilket också utgör en oro för miljön.

2. Att köra AI-modeller och servrar kräver två till tre gånger kraften jämfört med konventionella applikationer.

(Källa: S&P Global)

AI-system körs på kraftfulla servrar i datacenter, som förbrukar stora mängder elektricitet för att upprätthålla kylning och säkerhet och underlätta höghastighetsbehandling.

Ett traditionellt rack i ett datacenter använder mellan 30-40 kW el. När AI kastas in i mixen med processorer som NVIDIA Grace Hopper H100, ökas denna strömförbrukning med två till tre gånger.

3. AI GPU:er förbrukar i genomsnitt 650 watt elektricitet.

(Källa: Barron's)

AI-uppgifter använder GPU:er, som förbrukar en betydligt större mängd energi jämfört med processorer. Bortsett från NVIDIA är det gemensamma genomsnittet för alla AI-GPU:er för närvarande 650 watt, betydligt mer energikrävande än traditionella toppgrafikkort som sällan är mer än hälften så mycket.

4. Det görs 200 miljoner ChatGPT-förfrågningar varje dag, samma som en halv miljon kilowattimmar el.

(Källa: The New Yorker)

ChatGPT är bara ett AI-system, men som det mest populära förbrukar det en svindlande mängd el. Med ett snitt på 200 miljoner generativ AI begär om dagen, motsvarar det mer än en halv miljon kilowattimmar el per dag. Som jämförelse förbrukar ett genomsnittligt hem i USA bara tjugonio kilowattimmar om dagen.

5. GPT-3-modellen använder lika mycket ström som 130 amerikanska hem på ett år.

(Källor: The Verge, Statista)

Redan innan vi redogjorde för de senaste modellerna förbrukade träningen av GPT-3-modellen redan lika mycket el som 130 amerikanska hem (1,300 200 MWh) och XNUMX tyska gör på ett år. Att träna en stor språkmodell tar mer kraft än någon traditionell datacenteruppgift och denna förbrukning ökar bara när nya modeller dyker upp, utvecklas och kräver mer data.

6. GPT-3 förbrukar mer resurser än de 20 mest kraftfulla superdatorerna i världen.

(Källa: Forbes)

När man tittar på processorkraft vid sidan av elektricitet kräver GPT-3 800 petaflops, samma mängd processorkraft som de nuvarande 20 mest kraftfulla superdatorerna i världen tillsammans.

7. 15 % av Googles energianvändning för datacenter förbrukas av maskininlärning.

(Källa: Yale)

Google är en av få AI-pionjärer som är uppmärksamma på elanvändning. Från och med 2024 medger sökjätten att 15 % av dess datacenters energianvändning nu kommer från maskininlärning.

AI energimarknadsstatistik

Det är inte bara förbrukningen av el och annan energi från AI som är värt att överväga. AI används också på dessa marknader.

8. AI i energi värderades till 4 miljarder dollar.

(Källa: Allied Market Research)

AI på energimarknaden värderades till 4.0 miljarder USD globalt 2021 och förväntas nå 19.8 miljarder USD år 2031. Bidragsgivare inkluderar Smart Grids, maskininlärning och effekter av klimatförändringar och utsläppsminskningar.

9. Nordamerika har en andel på 37.08 % av den globala AI-energimarknaden.

(Källa: Statista)

De senaste tillgängliga uppgifterna från 2019 visar att Nordamerika är världsledande på energimarknaden för artificiell intelligens, med en andel på 37.08 %. I slutet av 2024 förväntas detta värderas till 7.78 miljarder dollar.

10. AI har mer än 50 olika tillämpningar inom energibranschen.

(Källa: Latitude Media)

En färsk uppskattning avslöjade cirka 100 energirelaterade leverantörer som erbjuder AI-lösningar, med mer än 50 möjliga tillämpningar, inklusive underhåll av nät och belastningsprognoser.

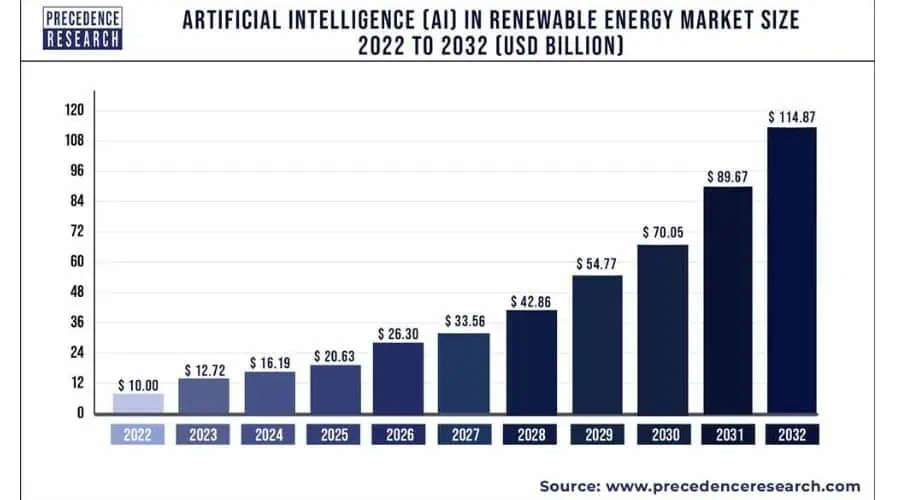

11. AI på marknaden för förnybar energi värderas till över 16 miljarder dollar.

(Källa: Precedence Research)

Inte bara ett elsvin, AI har växande tillämpningar inom förnybar energi. Den globala marknaden värderas för närvarande till 16.19 miljarder dollar och förväntas nå över 114 miljarder dollar år 2032. Ledande är Asien-Stillahavsområdet, vilket motsvarar en marknadsandel på 4.4 miljarder dollar, som beräknas nå 44.4 miljarder dollar år 2032.

AI Elanvändningsprognoser

Det är en sak att förstå strömförbrukningen för AI idag, men denna AI-elanvändningsstatistik utforskar tillväxten som är precis runt hörnet.

12. Till 2026 uppskattar IEA att AI kommer att använda lika mycket el som Japan.

(Källor: Vox, Data Commons)

Japan har en stor befolkning på över 125 miljoner människor. Det är också bland de 10 största elkonsumerande länderna. IEA räknar med att AI-elanvändningen kommer att matcha hela Japan redan 2026.

13. AI-datacenter skulle kunna lägga till 323 terawattimmar el i USA till 2030.

(Källor: CNBC, Wells Fargo)

I takt med att AI blir mer allmänt antagen och dess tillämpningar blir mer komplexa, måste energiförbrukningen öka för att möta de växande kraven.

Wells Fargo förutspår att elbehovet från AI-datacenter kan lägga till 323 terawattimmar elektricitet i USA år 2030. Det är hela sju gånger mer än New Yorks nuvarande elförbrukning.

14. NVIDIA kommer att leverera 1.5 miljoner AI-servrar per år till 2027.

(Källa: Scientific American)

Allt handlar inte om spel för NVIDIA. Kort- och chiptillverkaren ligger i framkant av AI-servrar och förväntas nå 1.5 miljoner i den årliga leveransen av dessa specialiserade system till 2027. Detta skulle motsvara 85.4 terawattimmar el per år, mer än vad många små nationer förbrukar .

15. AMD kan snart konkurrera med NVIDIA på marknaden för AI GPU.

(Källa: Investors.com)

NVIDIA dominerar för närvarande AI GPU-marknaden med sin fullstack A100-lösning för AI-datorer. Analytiker tror dock att AMD potentiellt kan nå 20% marknadsandel, inte alltför långt efter sin totala GPU-marknadsandel.

Dess AI-bidrag har fördelen av konkurrenskraftiga prestanda men till ett mer överkomligt pris.

16. De flesta grafikprocessorer som används för AI kommer att förbruka 1,000 2026 watt elektricitet år XNUMX.

(Källa: Barron's)

När AI GPU:er utvecklas kommer var och en att kräva i genomsnitt 1,000 2026 watt elektricitet till 650, en anmärkningsvärd ökning från genomsnittet på XNUMX watt som förbrukas idag.

17. AI kommer att vara en starkt bidragande orsak till den förväntade ökningen på 80 % av efterfrågan på datacenter i USA till 2030.

(Källa: S&P Global)

Navitas Semiconductor förutspår en ökning av USA:s datacenterefterfrågan på 80 % mellan 2023 och 2030, med majoriteten av detta tillskrivet kraften som behövs för att träna AI-modeller, som, som nämnts, är mellan två till tre gånger högre än vanliga applikationer.

18. Google Search skulle fördubbla sin energianvändning genom att byta till enbart AI-servrar.

(Källa: Cell)

En nyligen genomförd akademisk studie noterar att Google i allt högre grad tar till sig AI-servrar i sökfunktioner. Om jätten bytte hela sin söksida av verksamheten till AI skulle den fördubbla sin elförbrukning, vilket ungefär skulle vara samma mängd el som används av landet Irland.

19. Naturgasföretag förväntar sig att efterfrågan på AI-elektricitet kommer att orsaka en affärsboom.

(Källa: CNBC)

Med vissa uppskattningar som tyder på att efterfrågan på el kommer att öka med 20 % till 2030 tack vare AI, tror naturgasproducenter att de kan fylla luckan där förnybar energi kommer att misslyckas. AI kan leda till en ökning av naturgasförbrukningen med så mycket som 10 miljarder kubikfot per dag.

20. Elon Musk tror att det inte kommer att finnas tillräckligt med el för att driva alla AI-chips till 2025.

(Källa: Barron's)

Även med naturgas och andra källor kvarstår frågan: har världen ens energikapaciteten att hänga med i ökningen av AI-elanvändningen? SpaceX och Tesla-chefen Elon Musk tror att det inte ens nästa år kommer att finnas tillräckligt med el för att driva de chips som driver AI.

21. Förnybar energi kan vara svaret.

(Källa: Barron's)

Det Virginia-baserade globala energiföretaget AES går i spetsen för övergången till ren energi. Den förutspår att datacenter kommer att nå 7.5 % av USA:s totala elförbrukning år 2030, men möjligheten att använda förnybar kraft för AI är det säkraste alternativet för att möta efterfrågan rent.

22. AI-drivna smarta hem skulle kunna minska hushållens CO2-utsläpp med 40 %.

(Källor: BI Team, GESI)

Ett annat tecken på att uppkomsten av AI inte är helt dåligt för planeten är dess förmåga att göra smarta hem effektivare. Forskning tyder på att smarta värmesystem kommer att minska gasförbrukningen med cirka 5 %, medan automatisering i hemenergisystem kan minska det genomsnittliga hemmets CO2-utsläpp med upp till 40 %.

Sammanfattning

Det finns ingen tvekan om att AI är här för att stanna. Men om takten för AI-anpassningen överstiger tillväxten av elproduktion, kan tillgången på el kämpa för att hålla jämna steg med effektbehovet, vilket potentiellt kan leda till strömbrist eller ökade energikostnader.

Som denna elanvändningsstatistik avslöjar, görs ansträngningar för att förbättra energieffektiviteten för AI-system, och några av dess tillämpningar kan faktiskt gynna planeten i form av ökat fokus på förnybara energikällor och energieffektivitet i hemmen.

Men eftersom AI fortsätter att utvecklas och expandera, kommer efterfrågan på el sannolikt fortfarande att förbli hög.

Källor:

1. Vox

2. S&P Global

3. Barrons

4. New Yorker

5. Gränsen

6. Statista

7. forbes

8. Yale

9. Allierad marknadsundersökning

10. Statista

13. Data Commons

16. För Investerare

17. Cell

18. BI Team

19. GESI

Användarforum

0 meddelanden