Microsoft Research apresenta Splitwise, uma nova técnica para aumentar a eficiência da GPU para modelos de linguagem grande

2 minutos. ler

Publicado em

Leia nossa página de divulgação para descobrir como você pode ajudar o MSPoweruser a sustentar a equipe editorial Saiba mais

Notas chave

- Splitwise é um avanço em eficiência e sustentabilidade de inferência LLM.

- Ao separar as fases de prompt e token, o Splitwise revela um novo potencial no uso de GPU e permite que os provedores de nuvem atendam mais consultas com mais rapidez sob o mesmo orçamento de energia.

Os grandes modelos de linguagem (LLMs) estão transformando os campos do processamento de linguagem natural e da inteligência artificial, permitindo aplicações como geração de código, agentes de conversação e resumo de texto. No entanto, estes modelos também representam desafios significativos para os fornecedores de nuvem, que precisam de implementar cada vez mais unidades de processamento gráfico (GPUs) para satisfazer a crescente procura de inferência LLM.

O problema é que as GPUs não são apenas caras, mas também consomem muita energia, e a capacidade de fornecer a eletricidade necessária para operá-las é limitada. Como resultado, os fornecedores de cloud enfrentam frequentemente o dilema de rejeitar as consultas dos utilizadores ou de aumentar os seus custos operacionais e impacto ambiental.

Para resolver esse problema, os pesquisadores do Microsoft Azure desenvolveram uma nova técnica chamada Splitwise, que visa tornar a inferência LLM mais eficiente e sustentável, dividindo a computação em duas fases distintas e alocando-as em máquinas diferentes. Você pode ler sobre esta técnica em detalhes em “Splitwise: Inferência LLM generativa eficiente usando divisão de fase”artigo de pesquisa.

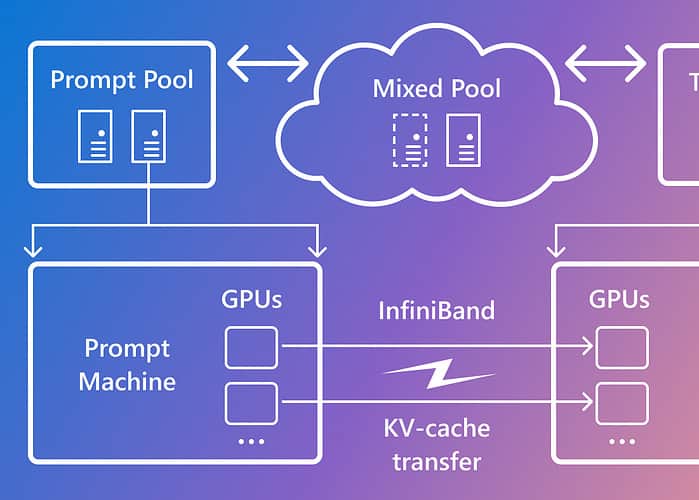

Splitwise baseia-se na observação de que a inferência LLM consiste em duas fases com características diferentes: a fase de prompt e a fase de geração de token. Na fase de prompt, o modelo processa a entrada do usuário, ou prompt, em paralelo, usando muita computação da GPU. Na fase de geração de token, o modelo gera cada token de saída sequencialmente, usando muita largura de banda de memória da GPU. Além de separar as duas fases de inferência do LLM em dois pools de máquinas distintos, a Microsoft usou um terceiro pool de máquinas para lotes mistos nas fases de prompt e token, dimensionados dinamicamente com base nas demandas computacionais em tempo real.

Usando Splitwise, a Microsoft conseguiu o seguinte:

- Rendimento 1.4x maior a um custo 20% menor do que os projetos atuais.

- 2.35x mais rendimento com os mesmos orçamentos de custo e energia.

Splitwise é um avanço em eficiência e sustentabilidade de inferência LLM. Ao separar as fases de prompt e token, o Splitwise revela um novo potencial no uso de GPU e permite que os provedores de nuvem atendam mais consultas com mais rapidez sob o mesmo orçamento de energia. Splitwise agora faz parte do vLLM e também pode ser implementado com outros frameworks. Os pesquisadores do Microsoft Azure planejam continuar seu trabalho para tornar a inferência LLM mais eficiente e sustentável, e prevêem pools de máquinas personalizados que gerem rendimento máximo, custos reduzidos e eficiência energética.