AMD przedstawia nowe akceleratory AI i APU dla chmury i przedsiębiorstw

3 minuta. czytać

Zaktualizowano na

Przeczytaj naszą stronę z informacjami, aby dowiedzieć się, jak możesz pomóc MSPoweruser w utrzymaniu zespołu redakcyjnego Czytaj więcej

AMD ogłosił swoje najnowsze produkty i technologie w zakresie sztucznej inteligencji (AI) i obliczeń o wysokiej wydajności (HPC) na wtorkowym wydarzeniu Advancing AI, którego celem jest zakwestionowanie dominacji takich rywali, jak Nvidia Corp. i Intel Corp. na szybko rozwijającym się rynku.

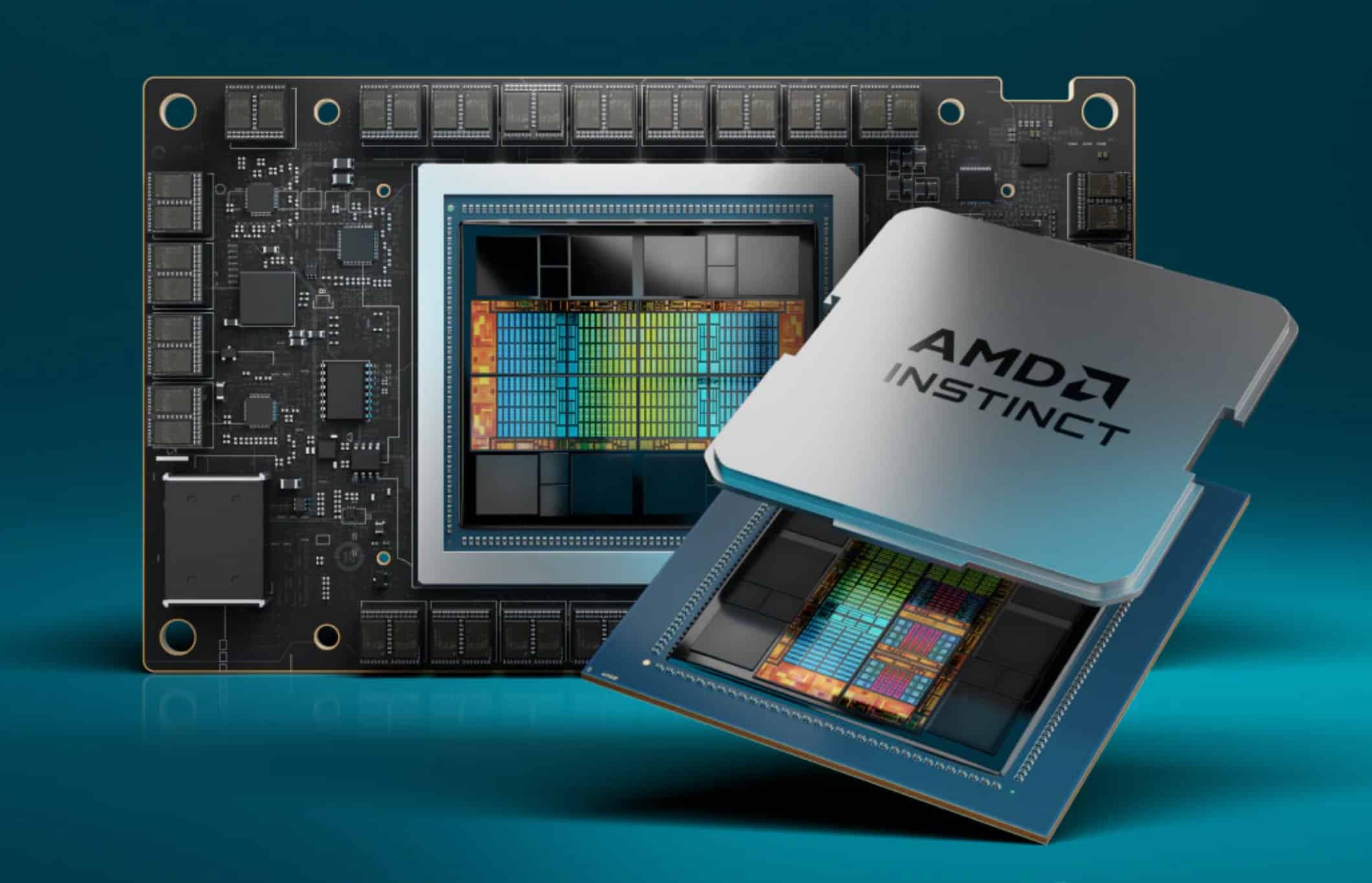

Producent chipów zaprezentował akceleratory AMD Instinct MI300 Series, które oferują największą w branży przepustowość pamięci na potrzeby generatywnej sztucznej inteligencji oraz najwyższą wydajność na potrzeby uczenia i wnioskowania z wykorzystaniem modelu dużego języka (LLM). Firma wprowadziła także jednostkę przyspieszonego przetwarzania AMD Instinct MI300A (APU), stanowiącą połączenie najnowszej architektury AMD CDNA 3 i procesorów „Zen 4”, zaprojektowaną w celu zapewnienia przełomowej wydajności dla obciążeń HPC i AI.

Adopcja klientów i partnerów

Wśród klientów korzystających z najnowszej oferty akceleratorów AMD Instinct jest firma Microsoft Corp., która niedawno ogłosiła nową serię maszyn wirtualnych (VM) Azure ND MI300x v5, zoptymalizowaną pod kątem obciążeń AI i obsługiwaną przez akceleratory AMD Instinct MI300X. Co więcej, oczekuje się, że El Capitan, superkomputer napędzany jednostkami APU AMD Instinct MI300A i znajdujący się w Lawrence Livermore National Laboratory, będzie drugim superkomputerem klasy eksaskalowej napędzanym przez firmę AMD, zapewniającym ponad dwa eksaflopy wydajności z podwójną precyzją po pełnym wdrożeniu. Oracle Corp. planuje także dodanie instancji bare metal opartych na technologii AMD Instinct MI300X do wysokowydajnych instancji obliczeniowych przyspieszonych dla sztucznej inteligencji, przy czym instancje oparte na MI300X mają obsługiwać OCI Supercluster z ultraszybką siecią RDMA.

Kilku głównych producentów OEM również zaprezentowało przyspieszone systemy obliczeniowe w związku z wydarzeniem AMD Advancing AI. Firma Dell Technologies Inc. zaprezentowała serwer Dell PowerEdge XE9680 wyposażony w osiem akceleratorów AMD Instinct z serii MI300 oraz nowy projekt Dell Validated Design for Generative AI z platformami AI opartymi na AMD ROCm. Firma Hewlett Packard Enterprise Co. ogłosiła wprowadzenie na rynek HPE Cray Supercomputing EX255a, pierwszego ostrza akceleratora superkomputerowego zasilanego przez układy APU AMD Instinct MI300A, który będzie dostępny na początku 2024 r. Lenovo Group Ltd. ogłosiła wsparcie projektowe dla nowych akceleratorów AMD Instinct serii MI300 z planowanymi dostępność w pierwszej połowie 2024 r. Firma Super Micro Computer Inc. ogłosiła wprowadzenie nowych produktów do swojej generacji akcelerowanych serwerów H13 wyposażonych w procesory AMD EPYC czwartej generacji i akceleratory AMD Instinct MI4 Series.

Cechy i specyfikacje produktu

Akceleratory AMD Instinct MI300X są zasilane nową architekturą AMD CDNA 3 i oferują prawie 40% więcej jednostek obliczeniowych, 1.5 razy większą pojemność pamięci, 1.7 razy większą szczytową teoretyczną przepustowość pamięci, a także obsługę nowych formatów matematycznych, takich jak FP8 i sparsity , a wszystko to z myślą o obciążeniach związanych ze sztuczną inteligencją i HPC. Procesory APU AMD Instinct MI300A, pierwsze na świecie APU dla centrów danych dla HPC i sztucznej inteligencji, wykorzystują opakowania 3D i architekturę AMD Infinity czwartej generacji, aby zapewnić wiodącą wydajność w przypadku krytycznych obciążeń, będąc zbieżnością HPC i sztucznej inteligencji.

| AMD Instynkt™ | Architektura | GPU CU | Rdzenie procesora | Pamięć | Przepustowość pamięci (Szczyt teoretyczny) |

Węzeł procesowy | Opakowanie 3D z 4th Architektura AMD Infinity generacji |

| MI300A | AMD CDNA™ 3 | 228 | 24 „Zen 4” | 128GB HBM3 | 5.3 TB / s | 5nm / 6nm | Tak |

| MI300X | AMD CDNA™ 3 | 304 | N / A | 192GB HBM3 | 5.3 TB / s | 5nm / 6nm | Tak |

| Platforma | AMD CDNA™ 3 | 2,432 | N / A | 1.5 TB HMB3 | 5.3 TB/s na OAM | 5nm / 6nm | Tak |

Aktualizacje oprogramowania i ekosystemu

Firma AMD ogłosiła także najnowszą platformę otwartego oprogramowania AMD ROCm 6 oraz zobowiązanie firmy do udostępniania społeczności open source najnowocześniejszych bibliotek, wspierając w ten sposób wizję firmy dotyczącą tworzenia oprogramowania AI typu open source. AMD w dalszym ciągu inwestuje w możliwości oprogramowania poprzez przejęcia Nod.AI i Mipsology, a także poprzez strategiczne partnerstwa ekosystemowe, takie jak Lamini i MosaicML.