Microsoft avduker 'PyRIT'-verktøysettet for å beskytte Generative AI-systemer

2 min. lese

Publisert på

Les vår avsløringsside for å finne ut hvordan du kan hjelpe MSPoweruser opprettholde redaksjonen Les mer

Viktige merknader

-

Programvaregiganten introduserer åpen kildekode-rammeverk for å gjøre det mulig for sikkerhetseksperter å proaktivt lokalisere sårbarheter i AI-modeller.

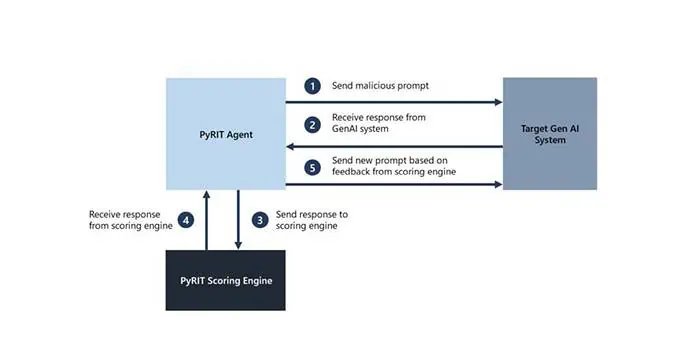

Microsoft i dag annonsert utgivelsen av PyRIT (Python Risk Identification Toolkit), et automatiseringsrammeverk med åpen kildekode som gir sikkerhetsteam mulighet til å identifisere risikoer innenfor generative AI-systemer. Flyttingen understreker Microsofts dype forpliktelse til ansvarlig AI-utvikling og bygging av sikre verktøy for det raskt voksende generative AI-landskapet.

AI Red Teaming Automation: En nødvendighet

Red teaming, prosessen med å simulere angrep for å teste forsvar, er avgjørende for generativ AI. Imidlertid er disse systemene komplekse, med flere feilpunkter, i motsetning til tradisjonell programvare. Microsofts omfattende erfaring innen AI red teaming førte til etableringen av PyRIT, som adresserer de unike utfordringene generativ AI utgjør.

"Selv om automatisering ikke fullt ut kan erstatte menneskelige røde teamers, er det viktig for å skalere innsats og fremheve områder som krever dypere etterforskning," sa Microsoft.

PyRIT: Nøkkelfunksjoner og fordeler

- tilpasnings~~POS=TRUNC: Fungerer med ulike generative AI-modeller og kan utvides til å støtte nye inputtyper (f.eks. bilder, video).

- Risikofokuserte datasett: Aktiverer testing for både sikkerhetsproblemer og potensielle skjevheter eller unøyaktigheter.

- Fleksibel scoringsmotor: Tillater scoring av AI-utganger ved hjelp av maskinlæring eller direkte LLM-er for selvtesting.

- Angrepsstrategier for flere svinger: Simulerer mer realistiske, vedvarende angrep for dybdetesting.

- Minnekapasitet: Forenkler analyse og gir mulighet for lengre, mer komplekse interaksjoner.

Bransjeomfattende innvirkning

PyRITs utgivelse er satt til å skape bølger i AI-sikkerhetsindustrien. Microsoft oppfordrer organisasjoner på tvers av sektorer til å bruke PyRIT i deres generative AI-sikkerhetsarbeid. Selskapet inviterer også til samarbeid, og understreker at en samlet innsats er avgjørende for å bygge robuste forsvar mot nye AI-risikoer.

Det er viktig å merke seg at PyRIT ikke er en erstatning for manuell red teaming av generative AI-systemer. I stedet forsterker den en AI red teamers eksisterende domeneekspertise og automatiserer de kjedelige oppgavene for dem.

Du kan komme i gang med PyRIT-prosjektet her..