Opera blir den første nettleseren som integrerer lokale LLM-er

1 min. lese

Oppdatert på

Les vår avsløringsside for å finne ut hvordan du kan hjelpe MSPoweruser opprettholde redaksjonen Les mer

Viktige merknader

- Brukere kan nå direkte administrere og få tilgang til kraftige AI-modeller på enhetene sine, og tilbyr forbedret personvern og hastighet sammenlignet med skybasert AI.

Opera i dag annonsert eksperimentell støtte for 150 lokale store språkmodeller (LLM) i Opera One-utviklernettleseren. Med denne støtten kan brukere nå direkte administrere og få tilgang til kraftige AI-modeller på enhetene sine, noe som tilbyr forbedret personvern og hastighet sammenlignet med skybasert AI.

Utvidet valg og personvern med lokale LLM-er

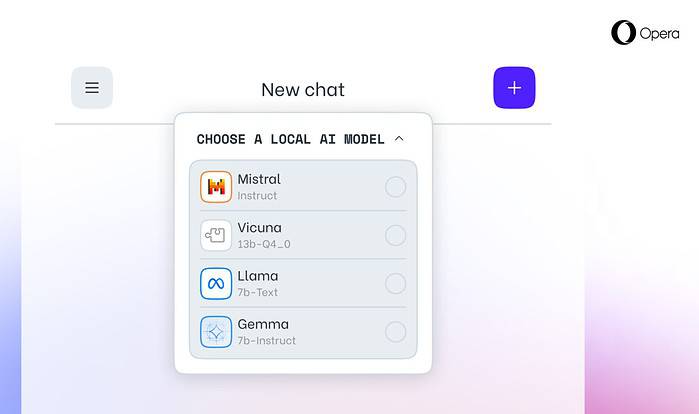

Operas integrasjon inkluderer populære LLM-er som Metas Llama, Vicuna, Googles Gemma, Mistral AIs Mixtral og mange flere. Lokale LLM-er eliminerer behovet for å dele data med servere, og beskytter brukernes personvern. Operas AI Feature Drops Program gir utviklere tidlig tilgang til disse banebrytende funksjonene.

Hvordan få tilgang til lokale LLM-er i Opera

Brukere kan besøke Operas utviklerside for å oppgradere til Opera One Developer, som muliggjør valg og nedlasting av deres foretrukne lokale LLM. Mens de krever lagringsplass (2-10 GB per modell), kan lokale LLM-er tilby en betydelig hastighetsøkning i forhold til skybaserte alternativer, avhengig av maskinvare.

Operas forpliktelse til AI-innovasjon

"Å introdusere lokale LLM-er på denne måten lar Opera begynne å utforske måter å bygge opplevelser og kunnskap innenfor det raskt voksende lokale AI-området," sa Krystian Kolondra, EVP Browsers and Gaming hos Opera.