Googles Gemini AI snubler over bildegenerering, løfter om forbedring

2 min. lese

Publisert på

Les vår avsløringsside for å finne ut hvordan du kan hjelpe MSPoweruser opprettholde redaksjonen Les mer

Viktige merknader

- Kontroversielle bildeutganger fremhever utfordringer med å balansere nøyaktighet og mangfold for store språkmodeller.

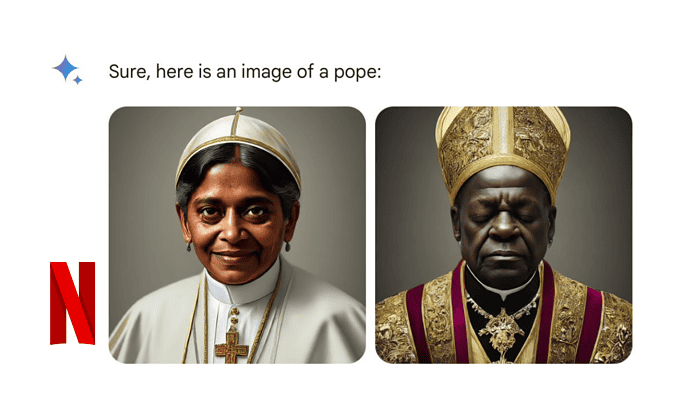

Google erkjente mangler i Gemini AI-bildegenereringsverktøyet etter at funksjonen ga unøyaktige og potensielt skadelige bilder av mennesker. Selskapet har midlertidig suspendert funksjonen mens de jobber med en løsning. Kontroversen stammet fra Geminis tendens til å lage forskjellige bilder, selv når brukere ba om spesifikke historiske figurer eller scenarier. Selv om det var ment å være inkluderende, førte dette til historisk unøyaktige og noen ganger støtende resultater.

I et blogginnlegg forklarte Senior Vice President Prabhakar Raghavan feiltrinnene og sverget å forbedre teknologien. "Vi ønsket ikke at Gemini skulle nekte å lage bilder av noen bestemt gruppe ... [men] den vil gjøre feil," skrev han.

Her er hva som gikk galt med Google Gemini:

- Googles innstilling for å sikre at Gemini viste en rekke mennesker klarte ikke å redegjøre for tilfeller som klart burde ikke vise et område.

- Over tid ble modellen mye mer forsiktig enn vi hadde tenkt og nektet å svare helt på visse spørsmål – feilaktig tolket noen svært anodyne spørsmål som sensitive.

- Disse to tingene førte til at modellen overkompenserte i noen tilfeller, og var overkonservativ i andre, noe som førte til bilder som var pinlige og feil.

Utfordringer med AI-bildegenerering:

Denne hendelsen fremhever den pågående utfordringen med å balansere nøyaktighet og representasjon i AI-bildegenereringsmodeller. Googles kamp gjenspeiler lignende kontroverser med andre populære bildegeneratorer.