Microsoft, Generative AI 시스템을 보호하는 데 도움이 되는 'PyRIT' 툴킷 공개

2 분. 읽다

에 게시됨

공개 페이지를 읽고 MSPoweruser가 편집팀을 유지하는 데 어떻게 도움을 줄 수 있는지 알아보세요. 자세히 보기

주요 사항

-

거대 소프트웨어 회사는 보안 전문가가 AI 모델의 취약점을 사전에 찾을 수 있도록 오픈 소스 프레임워크를 도입했습니다.

오늘 마이크로 소프트 발표 보안 팀이 생성 AI 시스템 내에서 위험을 식별할 수 있도록 지원하는 오픈 소스 자동화 프레임워크인 PyRIT(Python Risk Identification Toolkit) 출시. 이러한 움직임은 책임 있는 AI 개발과 빠르게 확장되는 생성 AI 환경을 위한 보안 도구 구축에 대한 Microsoft의 깊은 의지를 강조합니다.

AI 레드팀 자동화: 필요성

방어를 테스트하기 위해 공격을 시뮬레이션하는 프로세스인 레드팀 구성은 생성 AI에 매우 중요합니다. 그러나 이러한 시스템은 기존 소프트웨어와 달리 여러 오류 지점이 있어 복잡합니다. AI 레드 팀 구성에 대한 Microsoft의 광범위한 경험을 바탕으로 생성 AI가 제기하는 고유한 문제를 해결하는 PyRIT가 탄생했습니다.

마이크로소프트는 “자동화는 인간 레드팀을 완전히 대체할 수는 없지만 노력을 확장하고 심층 조사가 필요한 영역을 강조하는 데 필수적”이라고 말했습니다.

PyRIT: 주요 기능 및 이점

- 적응성: 다양한 생성 AI 모델과 함께 작동하며 새로운 입력 유형(예: 이미지, 비디오)을 지원하도록 확장될 수 있습니다.

- 위험 중심 데이터 세트: 보안 문제와 잠재적인 편견 또는 부정확성을 모두 테스트할 수 있습니다.

- 유연한 채점 엔진: 자체 테스트를 위해 기계 학습 또는 직접 LLM을 사용하여 AI 출력의 점수를 매길 수 있습니다.

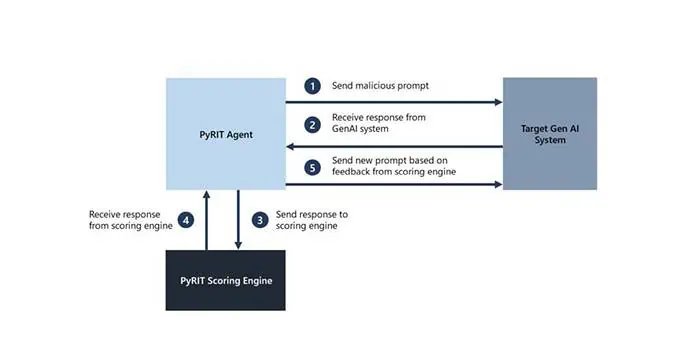

- 다중 턴 공격 전략: 심층 테스트를 위해 보다 현실적이고 지속적인 공격을 시뮬레이션합니다.

- 메모리 용량: 분석을 촉진하고 더 길고 복잡한 상호 작용을 허용합니다.

업계 전반에 미치는 영향

PyRIT의 출시는 AI 보안 산업에 큰 파장을 일으킬 예정입니다. Microsoft는 다양한 부문의 조직이 생성적 AI 보안 노력에 PyRIT를 활용하도록 권장합니다. 또한 회사는 새로운 AI 위험에 대한 강력한 방어 체계를 구축하려면 공동의 노력이 중요하다는 점을 강조하면서 협력을 권장합니다.

PyRIT는 생성 AI 시스템의 수동 레드팀 구성을 대체하지 않는다는 점에 유의하는 것이 중요합니다. 대신 AI 레드 팀 구성원의 기존 도메인 전문 지식을 강화하고 지루한 작업을 자동화합니다.

PyRIT 프로젝트를 시작할 수 있습니다 여기에서 지금 확인해 보세요..