Microsoft Research が、大規模言語モデルの GPU 効率を高める新しい手法である Splitwise を導入

2分。 読んだ

上で公開

MSPoweruser の編集チームの維持にどのように貢献できるかについては、開示ページをお読みください。 続きを読む

キーノート

- Splitwise は、LLM 推論の効率と持続可能性における画期的な進歩です。

- Splitwise は、プロンプト フェーズとトークン フェーズを分離することで、GPU 使用の新たな可能性を解き放ち、クラウド プロバイダーが同じ電力バジェットでより多くのクエリをより速く処理できるようにします。

大規模言語モデル (LLM) は、自然言語処理と人工知能の分野を変革し、コード生成、会話エージェント、テキスト要約などのアプリケーションを可能にします。ただし、これらのモデルは、LLM 推論に対する需要の高まりに応えるために、ますます多くのグラフィックス プロセッシング ユニット (GPU) を導入する必要があるクラウド プロバイダーにとって、重大な課題ももたらします。

問題は、GPU が高価であるだけでなく、多くの電力を消費し、GPU の実行に必要な電力を供給する能力が限られていることです。その結果、クラウド プロバイダーは、ユーザーのクエリを拒否するか、運用コストと環境への影響を増大させるかのジレンマに直面することがよくあります。

この問題に対処するために、Microsoft Azure の研究者は、と呼ばれる新しい技術を開発しました。 Splitwiseこれは、計算を 2 つの異なるフェーズに分割し、それらを異なるマシンに割り当てることで、LLM 推論をより効率的かつ持続可能なものにすることを目的としています。このテクニックについて詳しくは、「Splitwise: 位相分割を使用した効率的な生成 LLM 推論" 研究論文。

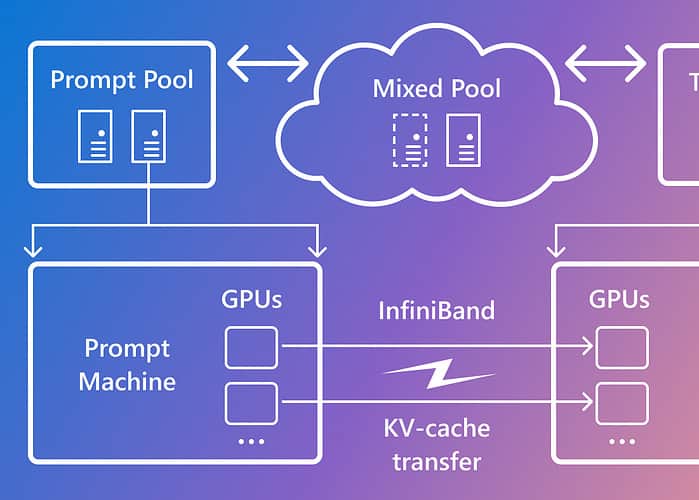

Splitwise は、LLM 推論がプロンプト フェーズとトークン生成フェーズという異なる特性を持つ 2 つのフェーズで構成されているという観察に基づいています。プロンプト段階では、モデルは大量の GPU コンピューティングを使用して、ユーザー入力またはプロンプトを並列処理します。トークン生成フェーズでは、モデルは多くの GPU メモリ帯域幅を使用して、各出力トークンを順番に生成します。 2 つの LLM 推論フェーズを 2 つの異なるマシン プールに分離することに加えて、Microsoft はプロンプト フェーズとトークン フェーズにわたる混合バッチ処理に 3 番目のマシン プールを使用し、リアルタイムの計算需要に基づいて動的にサイズ設定しました。

Splitwise を使用することで、Microsoft は次のことを達成できました。

- 現在の設計よりも 1.4% 低いコストで 20 倍のスループットが向上します。

- 同じコストと電力予算で 2.35 倍のスループット。

Splitwise は、LLM 推論の効率と持続可能性における画期的な進歩です。 Splitwise は、プロンプト フェーズとトークン フェーズを分離することで、GPU 使用の新たな可能性を解き放ち、クラウド プロバイダーが同じ電力バジェットでより多くのクエリをより速く処理できるようにします。 Splitwise は vLLM の一部となり、他のフレームワークでも実装できます。 Microsoft Azure の研究者らは、LLM 推論をより効率的かつ持続可能なものにするための取り組みを継続する予定で、カスタマイズされたマシン プールが最大のスループット、コストの削減、電力効率を促進することを構想しています。