Opera がローカル LLM を統合する最初のブラウザとなる

1分。 読んだ

更新日

MSPoweruser の編集チームの維持にどのように貢献できるかについては、開示ページをお読みください。 続きを読む

キーノート

- ユーザーは自分のデバイス上で強力な AI モデルを直接管理してアクセスできるようになり、クラウドベースの AI と比較してプライバシーと速度が強化されました。

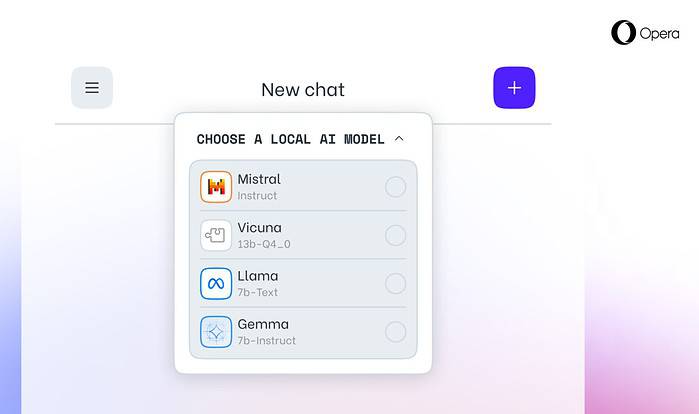

今日のオペラ 発表の Opera One 開発者ブラウザ内で 150 のローカルラージ言語モデル (LLM) を実験的にサポートします。このサポートにより、ユーザーはデバイス上で強力な AI モデルを直接管理およびアクセスできるようになり、クラウドベースの AI と比較してプライバシーと速度が強化されました。

ローカル LLM による選択肢とプライバシーの拡大

Opera の統合には、Meta の Llama、Vicuna、Google の Gemma、Mistral AI の Mixtral などの人気のある LLM が含まれています。ローカル LLM により、サーバーとデータを共有する必要がなくなり、ユーザーのプライバシーが保護されます。 Opera の AI Feature Drops プログラムを利用すると、開発者はこれらの最先端の機能に早期にアクセスできます。

Opera でローカル LLM にアクセスする方法

ユーザーが訪問できます Opera の開発者サイト Opera One Developer にアップグレードすると、好みのローカル LLM を選択してダウンロードできるようになります。ローカル LLM はストレージ スペース (モデルごとに 2 ~ 10 GB) を必要としますが、ハードウェアに応じて、クラウドベースの代替手段よりも大幅な速度向上を実現できます。

Opera の AI イノベーションへの取り組み

「この方法でローカル LLM を導入することで、Opera は急速に出現するローカル AI スペース内でエクスペリエンスとノウハウを構築する方法を模索し始めることができます」と Opera のブラウザーおよびゲーム担当副社長の Krystian Kolondra 氏は述べています。