Microsoft は、同クラスの他のモデルよりも優れたパフォーマンスを発揮する Phi-3 ファミリのモデルを発表

2分。 読んだ

上で公開

MSPoweruser の編集チームの維持にどのように貢献できるかについては、開示ページをお読みください。 続きを読む

2023 年 XNUMX 月にマイクロソフトはリリースしました。 ファイ-2 パラメータ数が 2.7 億未満の基本言語モデルの中で最先端のパフォーマンスを実現する 13 億パラメータのモデル。過去 2 か月間で、リリースされた他のいくつかのモデルが Phi-3 を上回りました。最近、Meta は、以前にリリースされたすべてのオープンソース モデルを上回るパフォーマンスを発揮する Llama-XNUMX ファミリのモデルをリリースしました。

昨夜、Microsoft Research は、次の方法で Phi-3 ファミリのモデルを発表しました。 テクニカルレポート。 Phi-3 ファミリには XNUMX つのモデルがあります。

- ファイ-3-ミニ (3.8B)

- ファイ-3-スモール (7B)

- ファイ-3-ミディアム (14B)

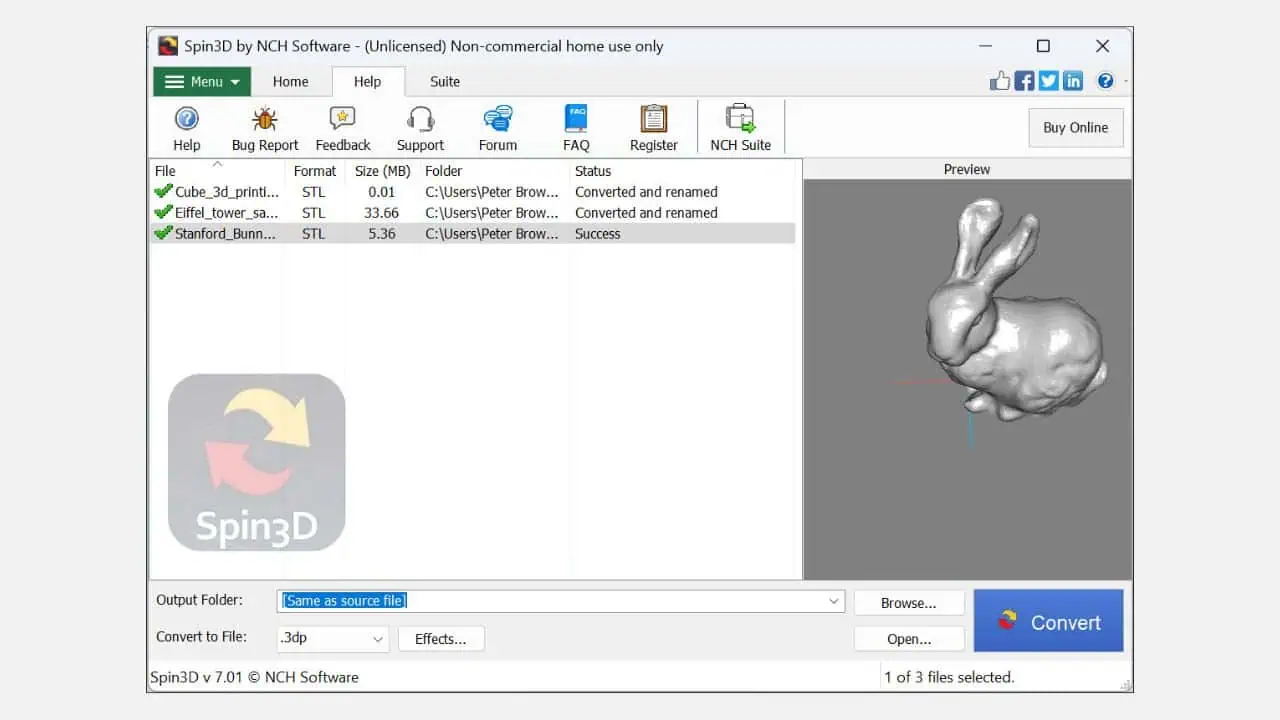

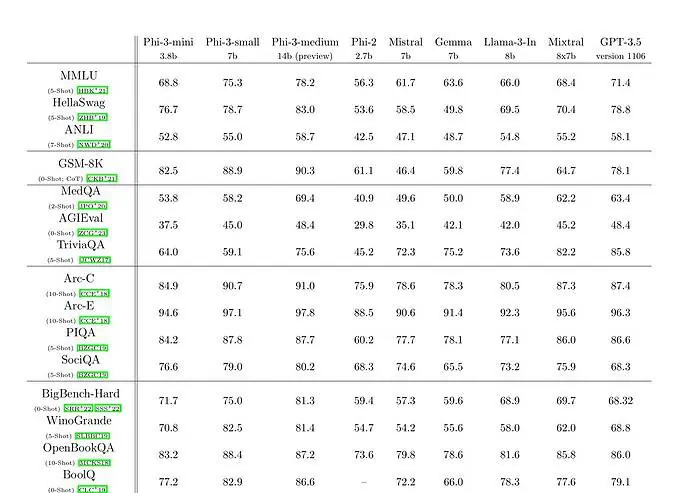

3 億のパラメーター言語モデルを備えた phi-3.8-mini は、3.3 兆 3 億のトークンでトレーニングされています。ベンチマークによると、phi-8-mini は Mixtral 7x3.5B および GPT-2 を上回っています。 Microsoft は、このモデルは携帯電話に導入できるほど小さいと主張しています。 Microsoft は、phi-3 に使用されたデータセットのスケールアップ バージョンを使用しました。これは、高度にフィルタリングされた Web データと合成データで構成されています。 Microsoft のテクニカル ペーパーのベンチマーク結果によると、phi-3-small と phi-75.3-medium はそれぞれ 78.2 と XNUMX という優れた MMLU スコアを達成しています。

LLM 機能の点では、Phi-3-mini モデルは、はるかに大きなモデルと同様のレベルの言語理解と推論能力を達成していますが、特定のタスクでは依然としてそのサイズによって根本的に制限されています。このモデルには、広範な事実に関する知識を保存する能力がありません。たとえば、TriviaQA のパフォーマンスが低いことがわかります。ただし、この弱点は検索エンジンを強化することで解決できると考えています。