Microsoft Research introduce Splitwise, una nuova tecnica per aumentare l'efficienza della GPU per modelli linguistici di grandi dimensioni

2 minuto. leggere

Edizione del

Leggi la nostra pagina informativa per scoprire come puoi aiutare MSPoweruser a sostenere il team editoriale Per saperne di più

Note chiave

- Splitwise rappresenta una svolta nell'efficienza e nella sostenibilità dell'inferenza LLM.

- Separando le fasi di prompt e token, Splitwise sblocca un nuovo potenziale nell'uso della GPU e consente ai fornitori di servizi cloud di servire più query più velocemente con lo stesso budget energetico.

I modelli linguistici di grandi dimensioni (LLM) stanno trasformando i campi dell'elaborazione del linguaggio naturale e dell'intelligenza artificiale, consentendo applicazioni come la generazione di codice, agenti conversazionali e riepilogo di testi. Tuttavia, questi modelli pongono anche sfide significative per i fornitori di servizi cloud, che devono implementare sempre più unità di elaborazione grafica (GPU) per soddisfare la crescente domanda di inferenza LLM.

Il problema è che le GPU non sono solo costose, ma anche assetate di energia, e la capacità di fornire l’elettricità necessaria per farle funzionare è limitata. Di conseguenza, i fornitori di servizi cloud spesso si trovano ad affrontare il dilemma se rifiutare le richieste degli utenti o aumentare i costi operativi e l’impatto ambientale.

Per risolvere questo problema, i ricercatori di Microsoft Azure hanno sviluppato una nuova tecnica chiamata Splitwise, che mira a rendere l'inferenza LLM più efficiente e sostenibile suddividendo il calcolo in due fasi distinte e assegnandole a macchine diverse. Puoi leggere questa tecnica in dettaglio nel loro "Splitwise: inferenza LLM generativa efficiente utilizzando la suddivisione delle fasi"documento di ricerca.

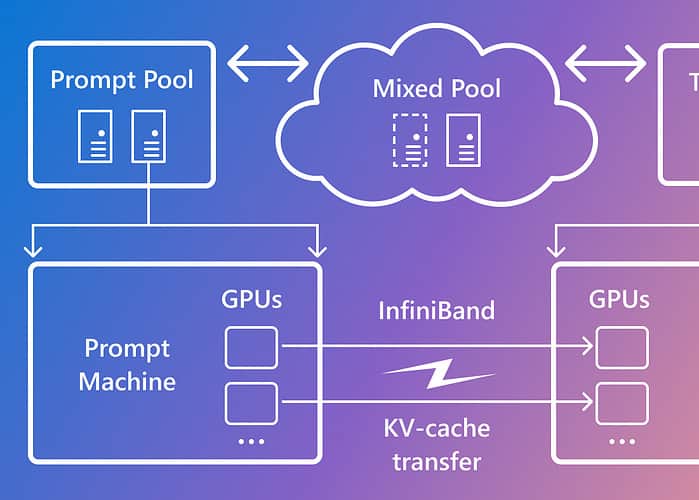

Splitwise si basa sull'osservazione che l'inferenza LLM è composta da due fasi con caratteristiche diverse: la fase di prompt e la fase di generazione del token. Nella fase di prompt, il modello elabora l'input dell'utente, o prompt, in parallelo, utilizzando molto calcolo della GPU. Nella fase di generazione dei token, il modello genera ciascun token di output in sequenza, utilizzando molta larghezza di banda della memoria della GPU. Oltre a separare le due fasi di inferenza LLM in due pool di macchine distinti, Microsoft ha utilizzato un terzo pool di macchine per il batching misto nelle fasi di prompt e token, dimensionato dinamicamente in base alle richieste di calcolo in tempo reale.

Utilizzando Splitwise, Microsoft è stata in grado di ottenere quanto segue:

- Produttività 1.4 volte superiore a un costo inferiore del 20% rispetto ai progetti attuali.

- Produttività 2.35 volte maggiore con gli stessi costi e budget energetici.

Splitwise rappresenta una svolta nell'efficienza e nella sostenibilità dell'inferenza LLM. Separando le fasi di prompt e token, Splitwise sblocca un nuovo potenziale nell'uso della GPU e consente ai fornitori di servizi cloud di servire più query più velocemente con lo stesso budget energetico. Splitwise ora fa parte di vLLM e può essere implementato anche con altri framework. I ricercatori di Microsoft Azure intendono continuare il loro lavoro per rendere l'inferenza LLM più efficiente e sostenibile e prevedono pool di macchine su misura che garantiscono il massimo throughput, costi ridotti ed efficienza energetica.