Microsoft Research memperkenalkan Splitwise, sebuah teknik baru untuk meningkatkan efisiensi GPU untuk Model Bahasa Besar

2 menit Baca

Ditampilkan di

Baca halaman pengungkapan kami untuk mengetahui bagaimana Anda dapat membantu MSPoweruser mempertahankan tim editorial Baca lebih lanjut

Catatan kunci

- Splitwise adalah terobosan dalam efisiensi dan keberlanjutan inferensi LLM.

- Dengan memisahkan fase prompt dan token, Splitwise membuka potensi baru dalam penggunaan GPU dan memungkinkan penyedia cloud melayani lebih banyak kueri dengan lebih cepat dengan anggaran daya yang sama.

Model bahasa besar (LLM) mentransformasi bidang pemrosesan bahasa alami dan kecerdasan buatan, memungkinkan aplikasi seperti pembuatan kode, agen percakapan, dan peringkasan teks. Namun, model ini juga menimbulkan tantangan yang signifikan bagi penyedia cloud, yang perlu menerapkan lebih banyak unit pemrosesan grafis (GPU) untuk memenuhi permintaan inferensi LLM yang terus meningkat.

Masalahnya adalah GPU tidak hanya mahal, tetapi juga haus daya, dan kapasitas untuk menyediakan listrik yang diperlukan untuk menjalankannya terbatas. Akibatnya, penyedia cloud sering kali menghadapi dilema dalam menolak pertanyaan pengguna atau meningkatkan biaya operasional dan dampak lingkungan.

Untuk mengatasi masalah ini, para peneliti di Microsoft Azure telah mengembangkan teknik baru yang disebut Splitwise, yang bertujuan untuk membuat inferensi LLM lebih efisien dan berkelanjutan dengan membagi komputasi menjadi dua fase berbeda dan mengalokasikannya ke mesin berbeda. Anda dapat membaca tentang teknik ini secara detail di “Splitwise: Inferensi LLM Generatif yang Efisien Menggunakan Pemisahan Fase” makalah penelitian.

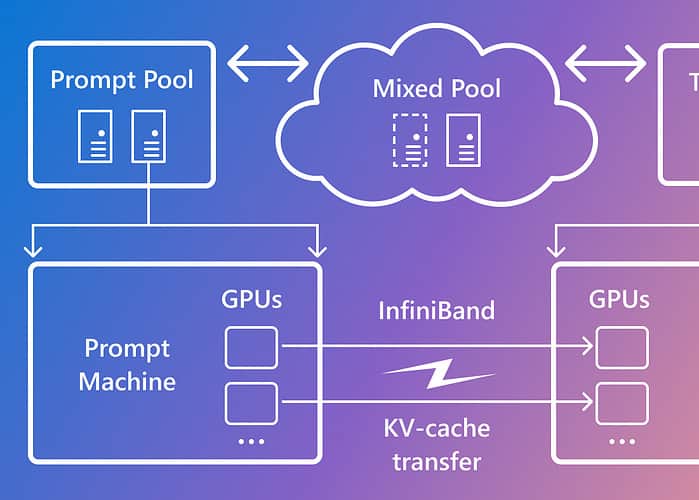

Splitwise didasarkan pada pengamatan bahwa inferensi LLM terdiri dari dua fase dengan karakteristik berbeda: fase prompt dan fase pembuatan token. Pada fase prompt, model memproses input pengguna, atau prompt, secara paralel, menggunakan banyak komputasi GPU. Pada fase pembuatan token, model menghasilkan setiap token keluaran secara berurutan, menggunakan banyak bandwidth memori GPU. Selain memisahkan dua fase inferensi LLM menjadi dua kumpulan mesin yang berbeda, Microsoft menggunakan kumpulan mesin ketiga untuk pengelompokan campuran di seluruh fase prompt dan token, yang diukur secara dinamis berdasarkan permintaan komputasi waktu nyata.

Dengan menggunakan Splitwise, Microsoft dapat mencapai hal berikut:

- Throughput 1.4x lebih tinggi dengan biaya 20% lebih rendah dibandingkan desain saat ini.

- Throughput 2.35x lebih banyak dengan anggaran biaya dan daya yang sama.

Splitwise adalah terobosan dalam efisiensi dan keberlanjutan inferensi LLM. Dengan memisahkan fase prompt dan token, Splitwise membuka potensi baru dalam penggunaan GPU dan memungkinkan penyedia cloud melayani lebih banyak kueri dengan lebih cepat dengan anggaran daya yang sama. Splitwise sekarang menjadi bagian dari vLLM dan juga dapat diimplementasikan dengan framework lain. Para peneliti di Microsoft Azure berencana untuk melanjutkan pekerjaan mereka dalam membuat inferensi LLM lebih efisien dan berkelanjutan, dan membayangkan kumpulan mesin yang disesuaikan akan mendorong hasil maksimum, pengurangan biaya, dan efisiensi daya.