Opera menjadi browser pertama yang mengintegrasikan LLM Lokal

1 menit Baca

Diperbarui pada

Baca halaman pengungkapan kami untuk mengetahui bagaimana Anda dapat membantu MSPoweruser mempertahankan tim editorial Baca lebih lanjut

Catatan kunci

- Pengguna kini dapat secara langsung mengelola dan mengakses model AI yang canggih di perangkat mereka, menawarkan privasi dan kecepatan yang lebih baik dibandingkan AI berbasis cloud.

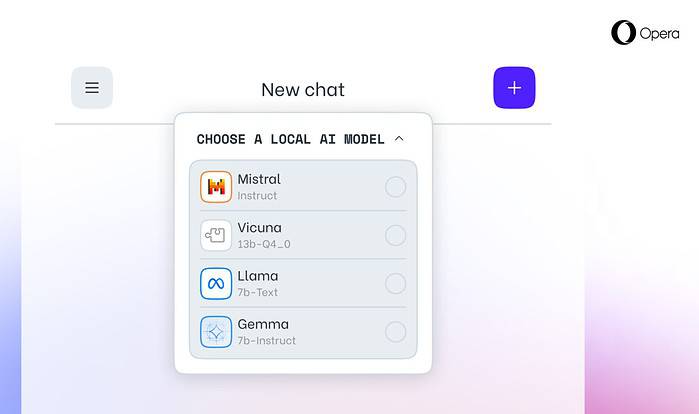

Opera hari ini mengumumkan dukungan eksperimental untuk 150 model bahasa besar lokal (LLM) dalam browser pengembang Opera One. Dengan dukungan ini, pengguna kini dapat secara langsung mengelola dan mengakses model AI yang kuat di perangkat mereka, menawarkan privasi dan kecepatan yang lebih baik dibandingkan AI berbasis cloud.

Pilihan yang Diperluas dan Privasi dengan LLM Lokal

Integrasi Opera mencakup LLM populer seperti Meta's Llama, Vicuna, Google's Gemma, Mistral AI's Mixtral, dan banyak lagi. LLM lokal menghilangkan kebutuhan untuk berbagi data dengan server, sehingga melindungi privasi pengguna. Program Penurunan Fitur AI Opera memungkinkan pengembang mengakses lebih awal ke fitur-fitur mutakhir ini.

Cara Mengakses LLM Lokal di Opera

Pengguna dapat mengunjungi Situs pengembang Opera untuk meningkatkan ke Opera One Developer, memungkinkan pemilihan dan pengunduhan LLM lokal pilihan mereka. Meskipun memerlukan ruang penyimpanan (2-10 GB per model), LLM lokal dapat menawarkan peningkatan kecepatan yang signifikan dibandingkan alternatif berbasis cloud, bergantung pada perangkat keras.

Komitmen Opera terhadap Inovasi AI

“Memperkenalkan LLM Lokal dengan cara ini memungkinkan Opera untuk mulai mengeksplorasi cara membangun pengalaman dan pengetahuan dalam ruang AI lokal yang berkembang pesat,” kata Krystian Kolondra, EVP Browsers and Gaming di Opera.