Opera postaje prvi preglednik koji integrira lokalne LLM-ove

1 min. čitati

Ažurirano

Pročitajte našu stranicu za otkrivanje kako biste saznali kako možete pomoći MSPoweruseru da održi urednički tim Čitaj više

Ključne napomene

- Korisnici sada mogu izravno upravljati i pristupati moćnim AI modelima na svojim uređajima, nudeći poboljšanu privatnost i brzinu u usporedbi s AI temeljenom na oblaku.

Opera danas najavio eksperimentalna podrška za 150 lokalnih modela velikih jezika (LLM) unutar svog preglednika za programere Opera One. Uz ovu podršku, korisnici sada mogu izravno upravljati i pristupati snažnim AI modelima na svojim uređajima, nudeći poboljšanu privatnost i brzinu u usporedbi s AI-om temeljenim na oblaku.

Proširen izbor i privatnost s lokalnim LLM-ima

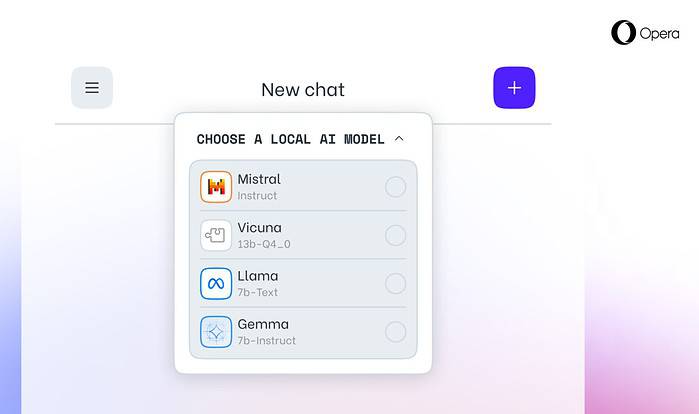

Integracija Opere uključuje popularne LLM-ove kao što su Meta's Llama, Vicuna, Google's Gemma, Mistral AI's Mixtral i mnoge druge. Lokalni LLM eliminiraju potrebu za dijeljenjem podataka s poslužiteljima, štiteći privatnost korisnika. Opera's AI Feature Drops Program programerima omogućuje rani pristup ovim vrhunskim značajkama.

Kako pristupiti lokalnim LLM-ovima u Operi

Korisnici mogu posjetiti Operino web mjesto za programere za nadogradnju na Opera One Developer, omogućujući odabir i preuzimanje željenog lokalnog LLM-a. Iako zahtijevaju prostor za pohranu (2-10 GB po modelu), lokalni LLM-ovi mogu ponuditi značajno povećanje brzine u odnosu na alternative temeljene na oblaku, ovisno o hardveru.

Operina predanost AI inovacijama

“Uvođenje lokalnih LLM-ova na ovaj način omogućuje Operi da počne istraživati načine izgradnje iskustava i znanja unutar lokalnog prostora umjetne inteligencije koji se brzo razvija”, rekao je Krystian Kolondra, EVP preglednika i igara u Operi.