Microsoft Research présente Splitwise, une nouvelle technique pour augmenter l'efficacité du GPU pour les grands modèles de langage

2 minute. lis

Publié le

Lisez notre page de divulgation pour savoir comment vous pouvez aider MSPoweruser à soutenir l'équipe éditoriale En savoir plus

Notes clés

- Splitwise est une percée dans l’efficacité et la durabilité de l’inférence LLM.

- En séparant les phases d'invite et de jeton, Splitwise libère un nouveau potentiel dans l'utilisation du GPU et permet aux fournisseurs de cloud de traiter plus de requêtes plus rapidement avec le même budget énergétique.

Les grands modèles de langage (LLM) transforment les domaines du traitement du langage naturel et de l'intelligence artificielle, permettant des applications telles que la génération de code, les agents conversationnels et la synthèse de texte. Cependant, ces modèles posent également des défis importants aux fournisseurs de cloud, qui doivent déployer de plus en plus d'unités de traitement graphique (GPU) pour répondre à la demande croissante d'inférence LLM.

Le problème est que les GPU sont non seulement chers, mais aussi gourmands en énergie, et la capacité à fournir l’électricité nécessaire à leur fonctionnement est limitée. En conséquence, les fournisseurs de cloud sont souvent confrontés au dilemme : soit rejeter les requêtes des utilisateurs, soit augmenter leurs coûts opérationnels et leur impact environnemental.

Pour résoudre ce problème, les chercheurs de Microsoft Azure ont développé une nouvelle technique appelée Splitwise, qui vise à rendre l'inférence LLM plus efficace et durable en divisant le calcul en deux phases distinctes et en les allouant à différentes machines. Vous pouvez en savoir plus sur cette technique en détail dans leur «Splitwise : inférence LLM générative efficace utilisant la division de phase" document de recherche.

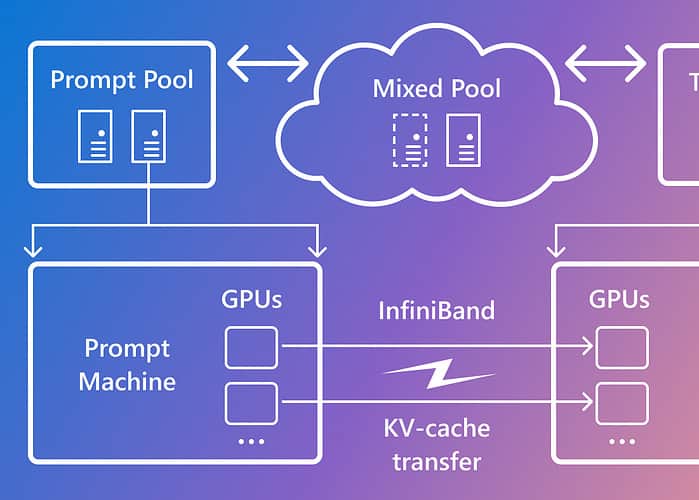

Splitwise est basé sur l'observation que l'inférence LLM se compose de deux phases avec des caractéristiques différentes : la phase d'invite et la phase de génération de jetons. Dans la phase d'invite, le modèle traite l'entrée utilisateur, ou l'invite, en parallèle, en utilisant beaucoup de calcul GPU. Dans la phase de génération de jetons, le modèle génère chaque jeton de sortie de manière séquentielle, en utilisant une grande partie de la bande passante mémoire du GPU. En plus de séparer les deux phases d'inférence LLM en deux pools de machines distincts, Microsoft a utilisé un troisième pool de machines pour le traitement par lots mixte entre les phases d'invite et de jeton, dimensionné dynamiquement en fonction des demandes de calcul en temps réel.

Grâce à Splitwise, Microsoft a pu obtenir les résultats suivants :

- Débit 1.4 fois plus élevé à un coût 20 % inférieur à celui des conceptions actuelles.

- Débit 2.35 fois plus élevé avec les mêmes budgets de coût et de puissance.

Splitwise est une percée dans l’efficacité et la durabilité de l’inférence LLM. En séparant les phases d'invite et de jeton, Splitwise libère un nouveau potentiel dans l'utilisation du GPU et permet aux fournisseurs de cloud de traiter plus de requêtes plus rapidement avec le même budget énergétique. Splitwise fait désormais partie de vLLM et peut également être implémenté avec d'autres frameworks. Les chercheurs de Microsoft Azure prévoient de poursuivre leurs travaux pour rendre l'inférence LLM plus efficace et durable, et envisagent des pools de machines sur mesure permettant un débit maximal, des coûts réduits et une efficacité énergétique.