Opera اولین مرورگری است که Local LLMs را ادغام می کند

1 دقیقه خواندن

به روز شده در

صفحه افشای ما را بخوانید تا بدانید چگونه می توانید به MSPoweruser کمک کنید تا تیم تحریریه را حفظ کند ادامه مطلب

یادداشت های کلیدی

- کاربران اکنون میتوانند مستقیماً مدلهای هوش مصنوعی قدرتمند را در دستگاههای خود مدیریت کرده و به آنها دسترسی داشته باشند و حریم خصوصی و سرعت بیشتری را در مقایسه با هوش مصنوعی مبتنی بر ابر ارائه میدهند.

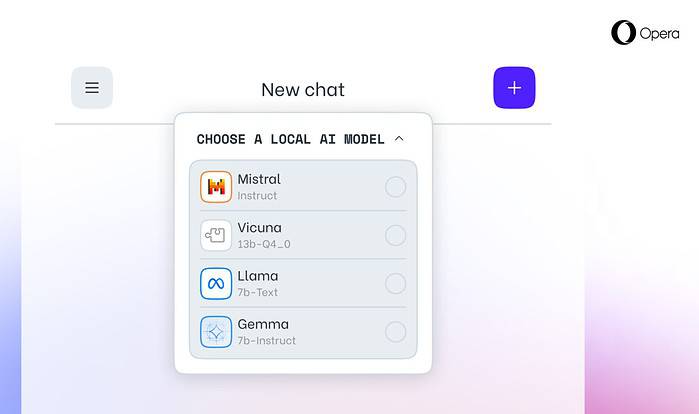

اپرا امروز اعلام کرد پشتیبانی آزمایشی از 150 مدل زبان بزرگ محلی (LLM) در مرورگر توسعه دهنده Opera One آن. با این پشتیبانی، کاربران اکنون میتوانند مستقیماً مدلهای هوش مصنوعی قدرتمند را در دستگاههای خود مدیریت کرده و به آنها دسترسی داشته باشند و حریم خصوصی و سرعت بیشتری را در مقایسه با هوش مصنوعی مبتنی بر ابر ارائه دهند.

انتخاب گسترده و حریم خصوصی با LLM های محلی

ادغام اپرا شامل LLM های محبوبی مانند Meta's Llama، Vicuna، Gemma گوگل، Mistral AI's Mixtral و بسیاری دیگر می شود. LLM های محلی نیاز به اشتراک گذاری داده ها با سرورها را از بین می برند و از حریم خصوصی کاربر محافظت می کنند. برنامه کاهش ویژگی های هوش مصنوعی اپرا به توسعه دهندگان امکان دسترسی زودهنگام به این ویژگی های پیشرفته را می دهد.

نحوه دسترسی به LLM های محلی در اپرا

کاربران می توانند بازدید کنند سایت توسعه دهنده اپرا برای ارتقاء به Opera One Developer، انتخاب و دانلود LLM محلی مورد نظر خود را قادر می سازد. در حالی که به فضای ذخیره سازی (2 تا 10 گیگابایت در هر مدل) نیاز است، LLM های محلی می توانند افزایش سرعت قابل توجهی را نسبت به جایگزین های مبتنی بر ابر، بسته به سخت افزار، ارائه دهند.

تعهد اپرا به نوآوری هوش مصنوعی

کریستیان کولوندرا، مرورگرهای EVP و بازی در اپرا، گفت: «معرفی Local LLM به این روش به Opera اجازه میدهد تا راههای ایجاد تجربیات و دانش را در فضای هوش مصنوعی محلی در حال ظهور سریع آغاز کند.