Microsoft Research presenta Splitwise, una nueva técnica para aumentar la eficiencia de la GPU para modelos de lenguajes grandes

2 minuto. leer

Publicado el

Lea nuestra página de divulgación para descubrir cómo puede ayudar a MSPoweruser a sostener el equipo editorial. Leer más

Notas clave

- Splitwise es un gran avance en la eficiencia y sostenibilidad de la inferencia de LLM.

- Al separar las fases de aviso y token, Splitwise desbloquea un nuevo potencial en el uso de GPU y permite a los proveedores de la nube atender más consultas más rápido con el mismo presupuesto de energía.

Los modelos de lenguaje grande (LLM) están transformando los campos del procesamiento del lenguaje natural y la inteligencia artificial, permitiendo aplicaciones como la generación de código, agentes conversacionales y resúmenes de texto. Sin embargo, estos modelos también plantean desafíos importantes para los proveedores de la nube, que necesitan implementar cada vez más unidades de procesamiento de gráficos (GPU) para satisfacer la creciente demanda de inferencia LLM.

El problema es que las GPU no sólo son caras, sino que también consumen mucha energía, y la capacidad de suministrar la electricidad necesaria para hacerlas funcionar es limitada. Como resultado, los proveedores de la nube a menudo enfrentan el dilema de rechazar las consultas de los usuarios o aumentar sus costos operativos y su impacto ambiental.

Para abordar este problema, investigadores de Microsoft Azure han desarrollado una técnica novedosa llamada Splitwise, cuyo objetivo es hacer que la inferencia LLM sea más eficiente y sostenible al dividir el cálculo en dos fases distintas y asignarlas a diferentes máquinas. Puedes leer sobre esta técnica en detalle en su “Splitwise: inferencia generativa eficiente de LLM mediante división de fases" trabajo de investigación.

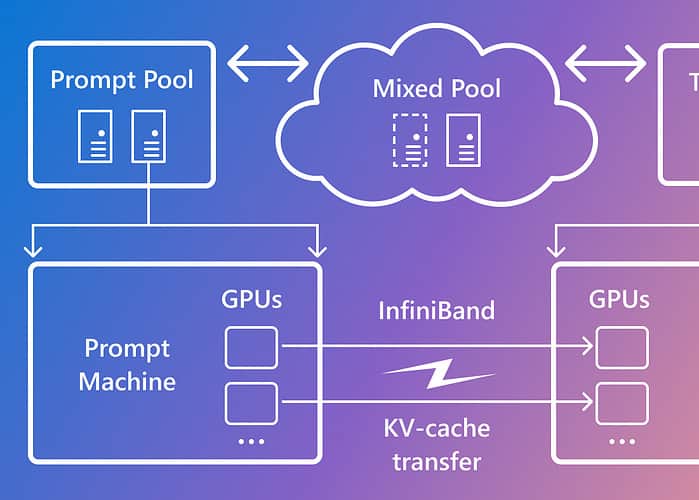

Splitwise se basa en la observación de que la inferencia LLM consta de dos fases con características diferentes: la fase de aviso y la fase de generación de tokens. En la fase de solicitud, el modelo procesa la entrada del usuario, o solicitud, en paralelo, utilizando una gran cantidad de cálculo de GPU. En la fase de generación de tokens, el modelo genera cada token de salida de forma secuencial, utilizando una gran cantidad de ancho de banda de memoria de la GPU. Además de separar las dos fases de inferencia de LLM en dos grupos de máquinas distintos, Microsoft utilizó un tercer grupo de máquinas para el procesamiento por lotes mixto en las fases de solicitud y token, cuyo tamaño se dimensionó dinámicamente en función de las demandas computacionales en tiempo real.

Usando Splitwise, Microsoft pudo lograr lo siguiente:

- Rendimiento 1.4 veces mayor a un costo 20 % menor que los diseños actuales.

- 2.35 veces más rendimiento con el mismo costo y presupuesto de energía.

Splitwise es un gran avance en la eficiencia y sostenibilidad de la inferencia de LLM. Al separar las fases de aviso y token, Splitwise desbloquea un nuevo potencial en el uso de GPU y permite a los proveedores de la nube atender más consultas más rápido con el mismo presupuesto de energía. Splitwise ahora es parte de vLLM y también se puede implementar con otros marcos. Los investigadores de Microsoft Azure planean continuar su trabajo para hacer que la inferencia LLM sea más eficiente y sustentable, y visualizan grupos de máquinas personalizados que impulsen el máximo rendimiento, costos reducidos y eficiencia energética.