Microsoft presenta la familia de modelos Phi-3 que superan a otros modelos de su clase

2 minuto. leer

Publicado el

Lea nuestra página de divulgación para descubrir cómo puede ayudar a MSPoweruser a sostener el equipo editorial. Leer más

En diciembre de 2023, Microsoft lanzó fi-2 modelo con 2.7 millones de parámetros que ofrecía un rendimiento de última generación entre los modelos de lenguaje base con menos de 13 millones de parámetros. En los últimos cuatro meses, varios otros modelos lanzados superaron al Phi-2. Recientemente, Meta lanzó la familia de modelos Llama-3 que superó a todos los modelos de código abierto lanzados anteriormente.

Anoche, Microsoft Research anunció la familia de modelos Phi-3 a través de un informe técnico. Hay tres modelos de la familia Phi-3:

- phi-3-mini (3.8B)

- phi-3-pequeño (7B)

- phi-3-medio (14B)

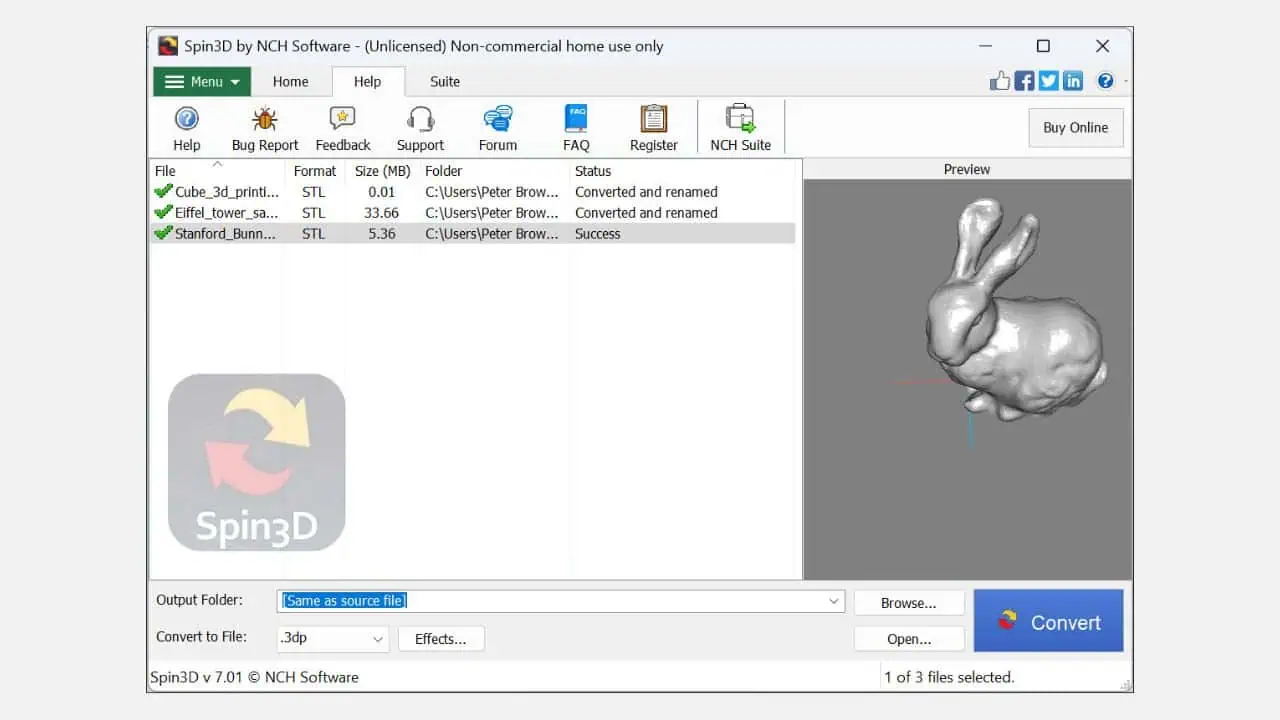

El phi-3-mini con un modelo de lenguaje de 3.8 millones de parámetros está entrenado en 3.3 billones de tokens. Según los puntos de referencia, el phi-3-mini supera al Mixtral 8x7B y al GPT-3.5. Microsoft afirma que este modelo es lo suficientemente pequeño como para implementarlo en un teléfono. Microsoft utilizó una versión ampliada del conjunto de datos que se utilizó para phi-2, compuesto por datos web muy filtrados y datos sintéticos. Según los resultados comparativos de Microsoft en el documento técnico, phi-3-small y phi-3-medium logran una impresionante puntuación MMLU de 75.3 y 78.2 respectivamente.

En términos de capacidades LLM, si bien el modelo Phi-3-mini alcanza un nivel similar de comprensión del lenguaje y capacidad de razonamiento como el de modelos mucho más grandes, todavía está fundamentalmente limitado por su tamaño para ciertas tareas. El modelo simplemente no tiene la capacidad de almacenar conocimientos factuales extensos, lo que se puede ver, por ejemplo, en el bajo rendimiento de TriviaQA. Sin embargo, creemos que esta debilidad se puede resolver mediante el aumento con un motor de búsqueda.