El modelo Phi-2 2.7B de Microsoft supera al modelo Google Gemini Nano-2 3.2B recientemente anunciado

2 minuto. leer

Publicado el

Lea nuestra página de divulgación para descubrir cómo puede ayudar a MSPoweruser a sostener el equipo editorial. Leer más

En los últimos meses, Microsoft Research ha lanzado un conjunto de modelos de lenguaje pequeño (SLM) llamado "Phi". El Phi-1 se lanzó primero con 1.3 millones de parámetros y estaba especializado para la codificación básica de Python. En septiembre, Microsoft Research liberado Modelo Phi-1.5 con 1.3 millones de parámetros, pero fue entrenado con una nueva fuente de datos que incluía varios textos sintéticos de PNL. A pesar de su pequeño tamaño, el phi-1.5 ofrecía un rendimiento casi de última generación en comparación con otros modelos de tamaño similar.

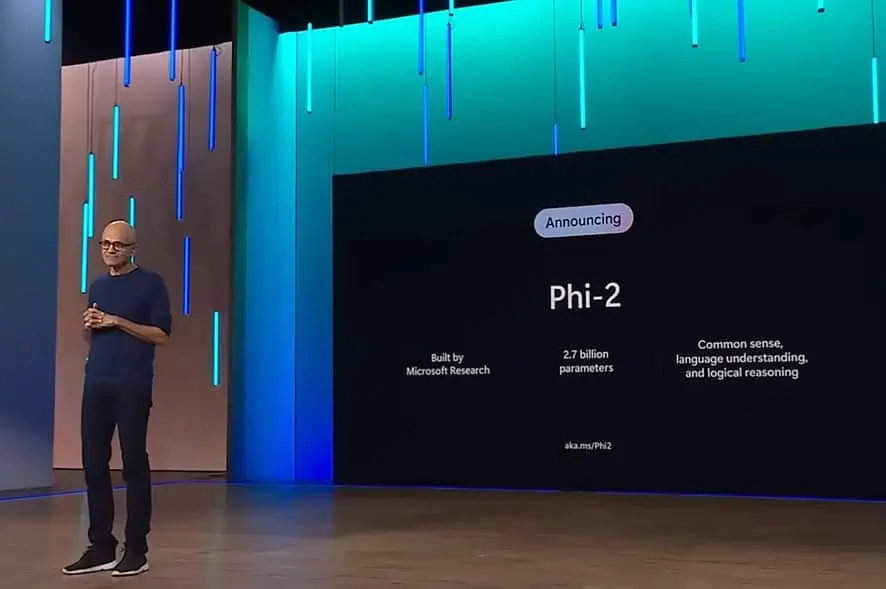

Microsoft anunció hoy el lanzamiento del modelo Phi-2 con 2.7 millones de parámetros. Microsoft Research afirma que este nuevo SLM ofrece un rendimiento de última generación entre los modelos de lenguaje base con menos de 13 mil millones de parámetros. En algunos puntos de referencia complejos, Phi-2 iguala o supera a modelos hasta 25 veces más grandes.

la semana pasada Google anunció Conjunto de modelos lingüísticos de Géminis. El Gemini Nano es el modelo más eficiente de Google creado para tareas en dispositivos y puede ejecutarse directamente en silicio móvil. El modelo de lenguaje pequeño similar a Gemini Nano permite funciones como resumen de texto, respuestas inteligentes contextuales y revisión avanzada y corrección gramatical.

Según Microsoft, el nuevo modelo Phi-2 iguala o supera al nuevo Google Gemini Nano-2, a pesar de ser de menor tamaño. Puede encontrar la comparación de puntos de referencia entre los modelos Google Gemini Nano-2 y Phi-2 a continuación.

| Modelo | Tamaño | BBH | boolq | MBPP | MMLU |

|---|---|---|---|---|---|

| Géminis Nano 2 | 3.2B | 42.4 | 79.3 | 27.2 | 55.8 |

| fi-2 | 2.7B | 59.3 | 83.3 | 59.1 | 56.7 |

Además de superar al Gemini Nano-2, Phi-2 también supera el rendimiento de los modelos Mistral y Llama-2 en los parámetros 7B y 13B en varios puntos de referencia. Encuentre los detalles a continuación.

| Modelo | Tamaño | BBH | Sentido común Razonamiento | Idioma Entender | Matemáticas | Codificación |

|---|---|---|---|---|---|---|

| Llama-2 | 7B | 40.0 | 62.2 | 56.7 | 16.5 | 21.0 |

| 13B | 47.8 | 65.0 | 61.9 | 34.2 | 25.4 | |

| 70B | 66.5 | 69.2 | 67.6 | 64.1 | 38.3 | |

| Mistral | 7B | 57.2 | 66.4 | 63.7 | 46.4 | 39.4 |

| fi-2 | 2.7B | 59.2 | 68.8 | 62.0 | 61.1 | 53.7 |

Si bien los dos modelos phi anteriores estuvieron disponibles en Hugging Face, Fi–2 está disponible en el catálogo de modelos de Azure. Puedes aprender más sobre Phi-2 esta página.