Microsoft Research stellt Splitwise vor, eine neue Technik zur Steigerung der GPU-Effizienz für große Sprachmodelle

2 Minute. lesen

Veröffentlicht am

Lesen Sie unsere Offenlegungsseite, um herauszufinden, wie Sie MSPoweruser dabei helfen können, das Redaktionsteam zu unterstützen Lesen Sie weiter

Wichtige Hinweise

- Splitwise ist ein Durchbruch in der Effizienz und Nachhaltigkeit von LLM-Inferenzen.

- Durch die Trennung der Eingabeaufforderungs- und Token-Phase erschließt Splitwise neue Potenziale bei der GPU-Nutzung und ermöglicht Cloud-Anbietern, mehr Anfragen schneller und mit dem gleichen Leistungsbudget zu bearbeiten.

Große Sprachmodelle (LLMs) verändern die Bereiche der Verarbeitung natürlicher Sprache und der künstlichen Intelligenz und ermöglichen Anwendungen wie Codegenerierung, Konversationsagenten und Textzusammenfassung. Diese Modelle stellen jedoch auch Cloud-Anbieter vor große Herausforderungen, die immer mehr Grafikprozessoren (GPUs) bereitstellen müssen, um der wachsenden Nachfrage nach LLM-Inferenz gerecht zu werden.

Das Problem besteht darin, dass GPUs nicht nur teuer, sondern auch stromhungrig sind und die Kapazität, den für ihren Betrieb erforderlichen Strom bereitzustellen, begrenzt ist. Daher stehen Cloud-Anbieter oft vor dem Dilemma, entweder Benutzeranfragen abzulehnen oder ihre Betriebskosten und Umweltauswirkungen zu erhöhen.

Um dieses Problem anzugehen, haben Forscher von Microsoft Azure eine neuartige Technik namens entwickelt Splitwise, das darauf abzielt, die LLM-Inferenz effizienter und nachhaltiger zu machen, indem die Berechnung in zwei verschiedene Phasen aufgeteilt und verschiedenen Maschinen zugewiesen wird. Sie können mehr über diese Technik in ihrem „Splitwise: Effiziente generative LLM-Inferenz mithilfe der Phasenaufteilung" Forschungsbericht.

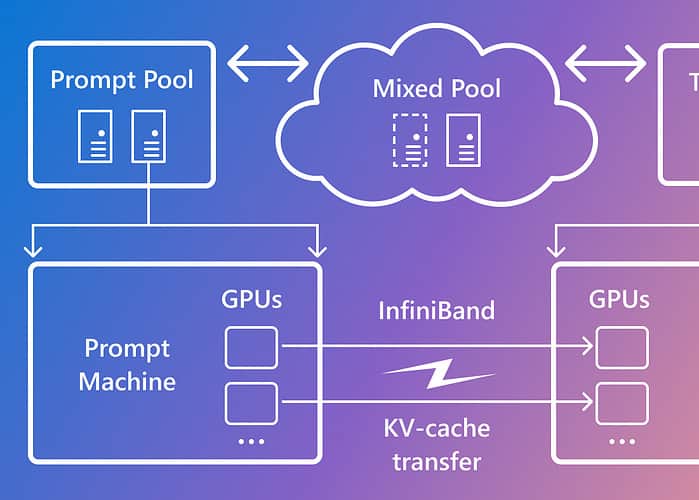

Splitwise basiert auf der Beobachtung, dass die LLM-Inferenz aus zwei Phasen mit unterschiedlichen Merkmalen besteht: der Prompt-Phase und der Token-Generierungsphase. In der Eingabeaufforderungsphase verarbeitet das Modell die Benutzereingabe oder Eingabeaufforderung parallel und nutzt dabei viel GPU-Rechenleistung. In der Token-Generierungsphase generiert das Modell jedes Ausgabe-Token nacheinander und nutzt dabei viel GPU-Speicherbandbreite. Zusätzlich zur Aufteilung der beiden LLM-Inferenzphasen in zwei unterschiedliche Maschinenpools nutzte Microsoft einen dritten Maschinenpool für gemischte Stapelverarbeitung über die Eingabeaufforderungs- und Token-Phasen hinweg, dessen Größe dynamisch auf der Grundlage der Echtzeit-Rechenanforderungen basiert.

Mit Splitwise konnte Microsoft Folgendes erreichen:

- 1.4-mal höherer Durchsatz bei 20 % geringeren Kosten als aktuelle Designs.

- 2.35-mal höherer Durchsatz bei gleichen Kosten- und Leistungsbudgets.

Splitwise ist ein Durchbruch in der Effizienz und Nachhaltigkeit von LLM-Inferenzen. Durch die Trennung der Eingabeaufforderungs- und Token-Phase erschließt Splitwise neue Potenziale bei der GPU-Nutzung und ermöglicht Cloud-Anbietern, mehr Anfragen schneller und mit dem gleichen Leistungsbudget zu bearbeiten. Splitwise ist mittlerweile Teil von vLLM und kann auch mit anderen Frameworks implementiert werden. Die Forscher von Microsoft Azure planen, ihre Arbeit fortzusetzen, um die LLM-Inferenz effizienter und nachhaltiger zu gestalten, und stellen sich maßgeschneiderte Maschinenpools vor, die maximalen Durchsatz, reduzierte Kosten und Energieeffizienz ermöglichen.