Opera bliver den første browser til at integrere lokale LLM'er

1 min. Læs

Opdateret den

Læs vores oplysningsside for at finde ud af, hvordan du kan hjælpe MSPoweruser med at opretholde redaktionen Læs mere

Nøgle noter

- Brugere kan nu direkte administrere og få adgang til kraftfulde AI-modeller på deres enheder, hvilket giver forbedret privatliv og hastighed sammenlignet med cloud-baseret AI.

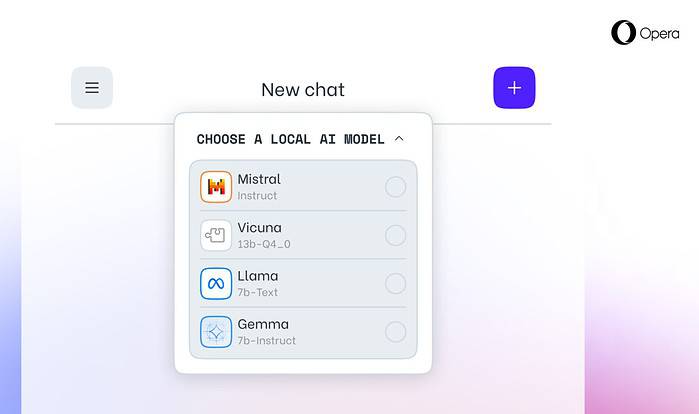

Opera i dag annoncerede eksperimentel understøttelse af 150 lokale store sprogmodeller (LLM'er) i dens Opera One-udviklerbrowser. Med denne support kan brugere nu direkte administrere og få adgang til kraftfulde AI-modeller på deres enheder, hvilket giver forbedret privatliv og hastighed sammenlignet med cloud-baseret AI.

Udvidet valg og privatliv med lokale LLM'er

Operas integration inkluderer populære LLM'er som Meta's Llama, Vicuna, Googles Gemma, Mistral AI's Mixtral og mange flere. Lokale LLM'er eliminerer behovet for at dele data med servere, hvilket beskytter brugernes privatliv. Operas AI Feature Drops Program giver udviklere tidlig adgang til disse banebrydende funktioner.

Sådan får du adgang til lokale LLM'er i Opera

Brugere kan besøge Operas udviklerside at opgradere til Opera One Developer, hvilket muliggør valg og download af deres foretrukne lokale LLM. Mens de kræver lagerplads (2-10 GB pr. model), kan lokale LLM'er tilbyde et betydeligt hastighedsboost i forhold til skybaserede alternativer, afhængigt af hardware.

Operas forpligtelse til AI-innovation

"Introduktion af lokale LLM'er på denne måde giver Opera mulighed for at begynde at udforske måder at opbygge oplevelser og knowhow inden for det hurtigt voksende lokale AI-rum," sagde Krystian Kolondra, EVP Browsers and Gaming hos Opera.