Microsoft Research introducerer Splitwise, en ny teknik til at øge GPU-effektiviteten til store sprogmodeller

2 min. Læs

Udgivet den

Læs vores oplysningsside for at finde ud af, hvordan du kan hjælpe MSPoweruser med at opretholde redaktionen Læs mere

Nøgle noter

- Splitwise er et gennembrud inden for LLM-slutningseffektivitet og bæredygtighed.

- Ved at adskille prompt- og tokenfaserne frigør Splitwise nyt potentiale i GPU-brug og gør det muligt for cloud-udbydere at betjene flere forespørgsler hurtigere under det samme strømbudget.

Store sprogmodeller (LLM'er) transformerer områderne naturlig sprogbehandling og kunstig intelligens, hvilket muliggør applikationer som kodegenerering, samtaleagenter og tekstresumé. Disse modeller udgør dog også betydelige udfordringer for cloud-udbydere, som har brug for at implementere flere og flere grafikprocessorenheder (GPU'er) for at imødekomme den voksende efterspørgsel efter LLM-inferens.

Problemet er, at GPU'er ikke kun er dyre, men også strømkrævende, og kapaciteten til at levere den nødvendige elektricitet til at drive dem er begrænset. Som følge heraf står cloud-udbydere ofte over for dilemmaet med enten at afvise brugerforespørgsler eller øge deres driftsomkostninger og miljøpåvirkning.

For at løse dette problem har forskere hos Microsoft Azure udviklet en ny teknik kaldet Splitwise, som har til formål at gøre LLM-inferens mere effektiv og bæredygtig ved at opdele beregningen i to adskilte faser og allokere dem til forskellige maskiner. Du kan læse mere om denne teknik i deres "Splitwise: Effektiv generativ LLM-inferens ved hjælp af faseopdeling" forskningsartikel.

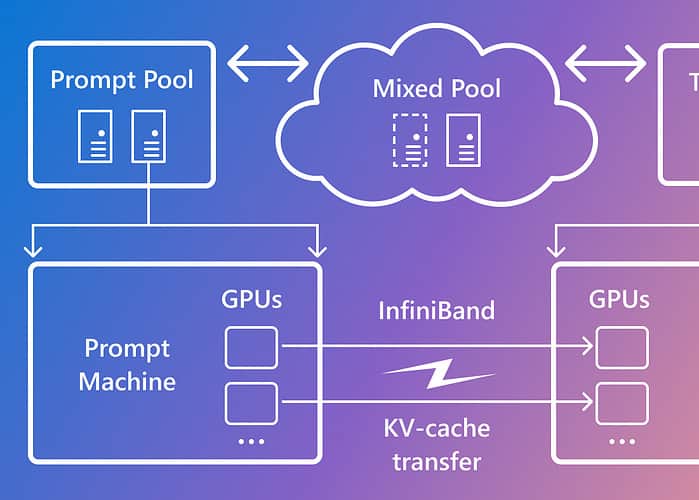

Splitwise er baseret på den observation, at LLM-inferens består af to faser med forskellige karakteristika: promptfasen og token-genereringsfasen. I promptfasen behandler modellen brugerinput eller prompt parallelt ved hjælp af en masse GPU-beregning. I tokengenereringsfasen genererer modellen hvert outputtoken sekventielt ved at bruge en masse GPU-hukommelsesbåndbredde. Ud over at adskille de to LLM-inferensfaser i to adskilte maskinpuljer, brugte Microsoft en tredje maskinpulje til blandet batching på tværs af prompt- og tokenfaserne, dimensioneret dynamisk baseret på realtidsberegningskrav.

Ved at bruge Splitwise var Microsoft i stand til at opnå følgende:

- 1.4 gange højere gennemløb til 20 % lavere omkostninger end nuværende designs.

- 2.35 gange mere gennemløb med samme omkostnings- og strømbudgetter.

Splitwise er et gennembrud inden for LLM-slutningseffektivitet og bæredygtighed. Ved at adskille prompt- og tokenfaserne frigør Splitwise nyt potentiale i GPU-brug og gør det muligt for cloud-udbydere at betjene flere forespørgsler hurtigere under det samme strømbudget. Splitwise er nu en del af vLLM og kan også implementeres med andre rammer. Forskerne hos Microsoft Azure planlægger at fortsætte deres arbejde med at gøre LLM-inferens mere effektiv og bæredygtig og forestiller sig skræddersyede maskinpuljer, der driver maksimal gennemstrømning, reducerede omkostninger og strømeffektivitet.