Opera se stává prvním prohlížečem, který integruje místní LLM

1 min. číst

Aktualizováno dne

Přečtěte si naši informační stránku a zjistěte, jak můžete pomoci MSPoweruser udržet redakční tým Dozvědět se více

Klíčové poznámky

- Uživatelé nyní mohou přímo spravovat a přistupovat k výkonným modelům umělé inteligence na svých zařízeních, což nabízí lepší soukromí a rychlost ve srovnání s cloudovou umělou inteligencí.

Opera dnes oznámila, experimentální podpora pro 150 místních velkých jazykových modelů (LLM) v rámci svého vývojářského prohlížeče Opera One. Díky této podpoře mohou nyní uživatelé přímo spravovat a přistupovat k výkonným modelům umělé inteligence na svých zařízeních, což nabízí lepší soukromí a rychlost ve srovnání s cloudovou umělou inteligencí.

Rozšířený výběr a soukromí s místními LLM

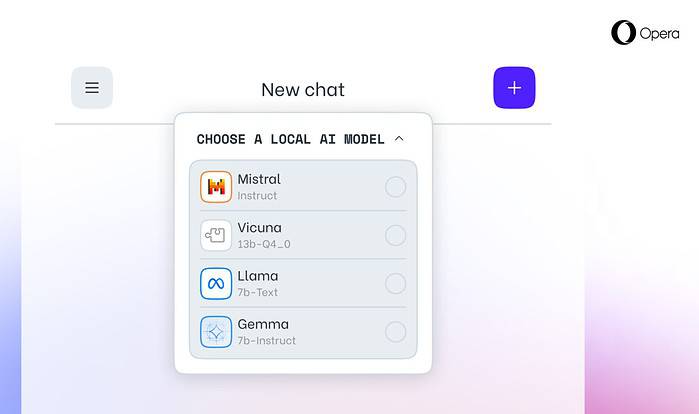

Integrace Opery zahrnuje oblíbené LLM jako Meta's Llama, Vicuna, Google Gemma, Mistral AI Mixtral a mnoho dalších. Místní LLM eliminují potřebu sdílet data se servery a chrání soukromí uživatelů. Program Opera's AI Feature Drops Program umožňuje vývojářům včasný přístup k těmto špičkovým funkcím.

Jak získat přístup k místním LLM v Opeře

Uživatelé mohou navštívit Vývojářský web Opery upgradovat na Opera One Developer a umožnit tak výběr a stažení preferovaného místního LLM. Zatímco vyžadují úložný prostor (2–10 GB na model), místní LLM mohou nabídnout výrazné zvýšení rychlosti oproti cloudovým alternativám v závislosti na hardwaru.

Závazek Opery k inovacím AI

„Zavedení Local LLM tímto způsobem umožňuje Opeře začít zkoumat způsoby budování zkušeností a know-how v rychle se rozvíjejícím místním prostoru umělé inteligence,“ řekl Krystian Kolondra, EVP Browsers and Gaming v Opeře.