自由软件基金会认为 GitHub Copilot 应该是非法的

3分钟读

更新

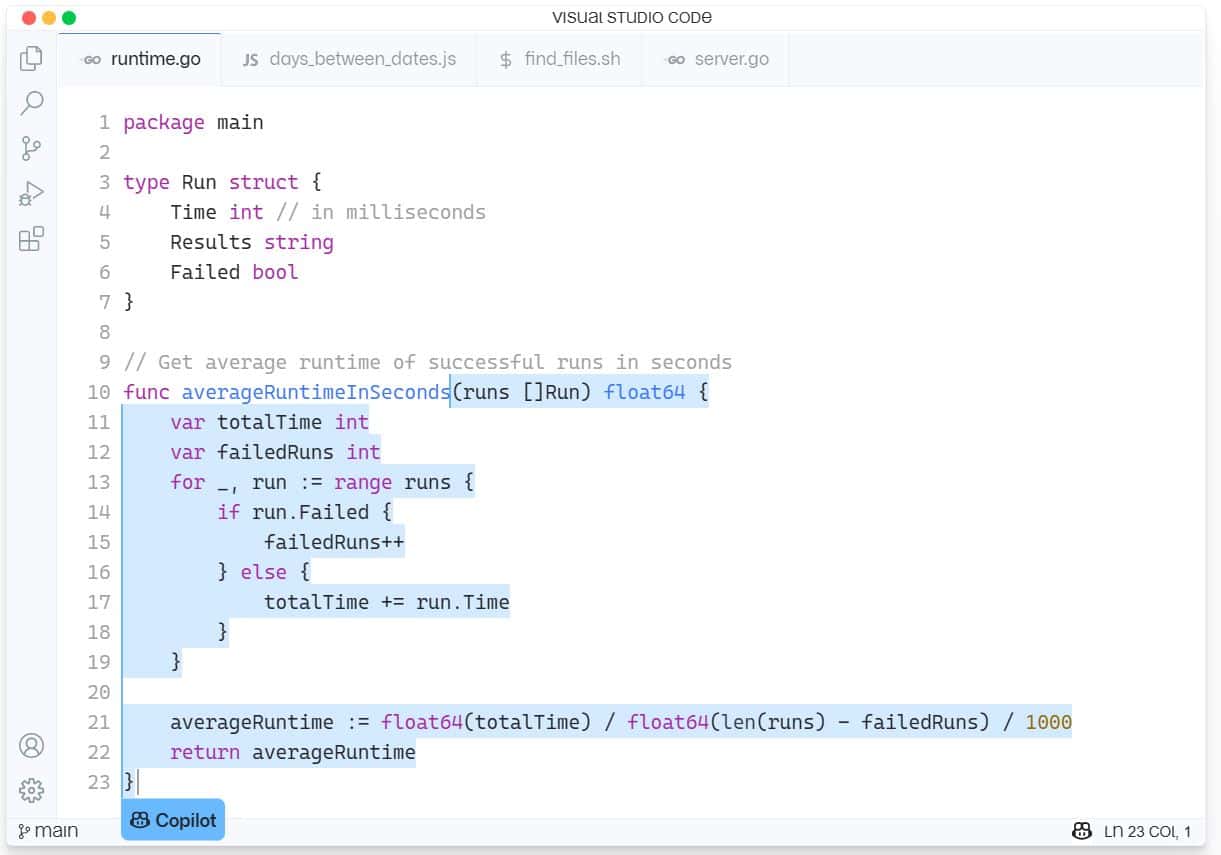

GitHub Copilot 是一项新的 AI 辅助服务,用于内置于 Microsoft 的 Visual Studio Code 中的软件开发。 GitHub Copilot 支持多种语言和框架,并通过在 IDE 内为整行或整个函数提供建议,使开发人员的生活更轻松。 GitHub Copilot 由 OpenAI Codex 提供支持,并接受了数十亿行开源代码的培训。

最后一个问题导致自由软件基金会(FSF)在他们的引擎盖上有一只大蜜蜂,称该工具“从我们的角度来看是不可接受和不公正的”。

这位开源软件倡导者抱怨说,Copilot 需要诸如 Microsoft 的 Visual Studio IDE 或 Visual Studio Code 编辑器之类的闭源软件才能运行,并且它构成了“作为软件替代品的服务”,这意味着它是一种获得对他人计算能力的方式。

FSF 认为 Copilot 存在许多问题,仍需要在法庭上进行测试。

“开发人员想知道在他们的软件上训练神经网络是否可以被认为是合理使用。 其他可能想要使用 Copilot 的人想知道从 GitHub 托管的存储库复制的代码片段和其他元素是否会导致侵犯版权。 即使一切都可能是合法的,活动人士想知道,一家专有软件公司从他们的工作中构建服务是否存在根本上的不公平,”FSF 写道。

FSF 要求白皮书帮助回答这些问题,以检查以下问题:

- Copilot 的公共存储库培训是否侵犯版权? 合理使用?

- Copilot 的输出产生违反 GPL 许可作品的可起诉索赔的可能性有多大?

- 使用 Copilot 的开发人员能否遵守 GPL 等自由软件许可证?

- 开发人员如何确保他们拥有版权的代码免受 Copilot 产生的违规行为?

- 如果 Copilot 生成的代码会导致违反自由软件许可作品的行为,版权所有者如何发现这种违规行为?

- 训练有素的 AI/ML 模型是否受版权保护? 谁拥有版权?

- 像 FSF 这样的组织是否应该主张改变与这些问题相关的版权法?

FSF 将为已发表的白皮书支付 500 美元,如果有必要进行进一步研究,可能会释放更多资金。

想要投稿的可以发到 [电子邮件保护] 21 月 XNUMX 日之前。 阅读有关该过程的更多信息 在 FSF.org 这里。

微软回应即将到来的挑战时表示:“这是一个新的空间,我们热衷于与开发人员就这些主题进行讨论,并引领行业为训练 AI 模型制定适当的标准。”

鉴于 Copilot 有时会从其他开源应用程序中窃取全部功能,我们的读者是否同意 FSF,或者 FSF 只是因为它是人工智能而不是人类重新利用代码而变得虚伪? 在下面的评论中让我们知道您的观点。

通过 信息世界

用户论坛

0消息