Snowflake Arctic 自豪地被誉为“企业人工智能的最佳法学硕士”。这是一个相当大的主张

您现在可以在 HuggingFace 上尝试 Snowflake

2分钟读

发表于

重点说明

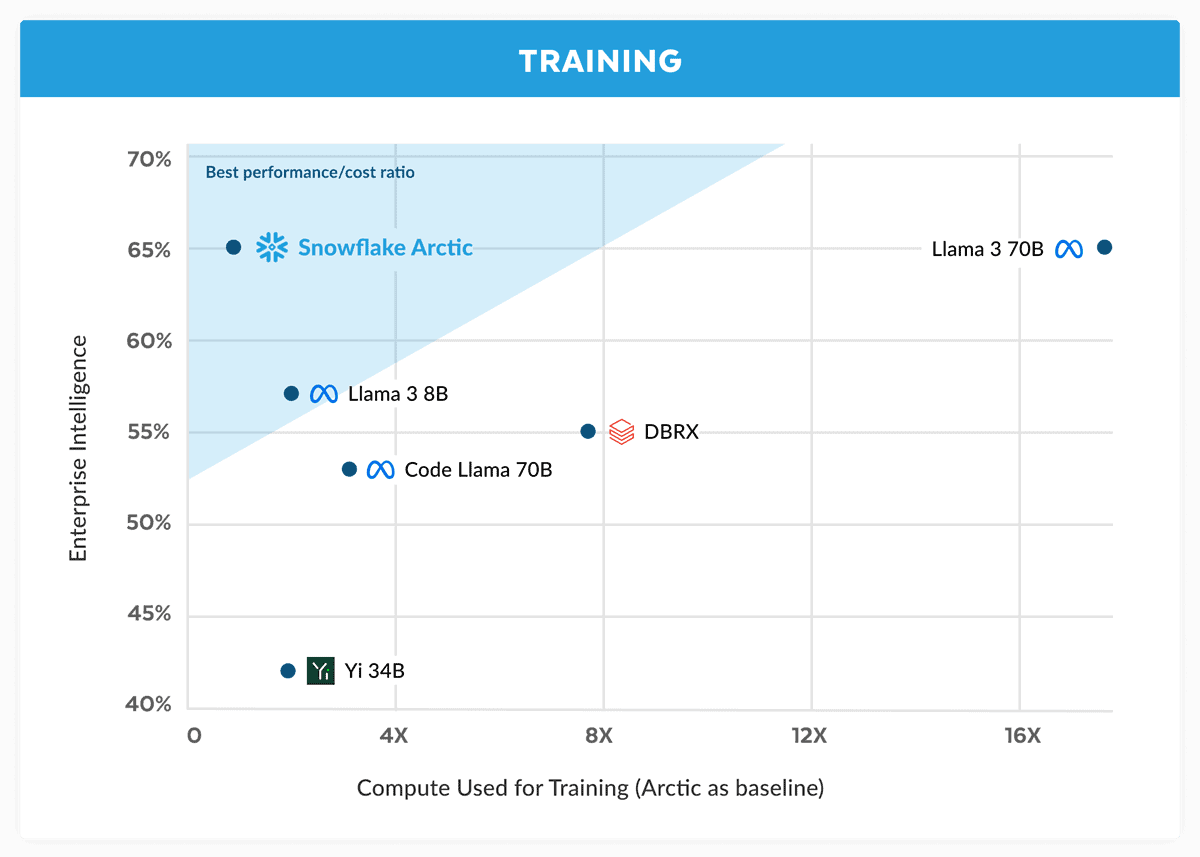

- Snowflake推出Arctic,声称它可以以更低的成本与Llama 3 70B相媲美。

- Arctic 擅长编码和 SQL 生成等企业任务。

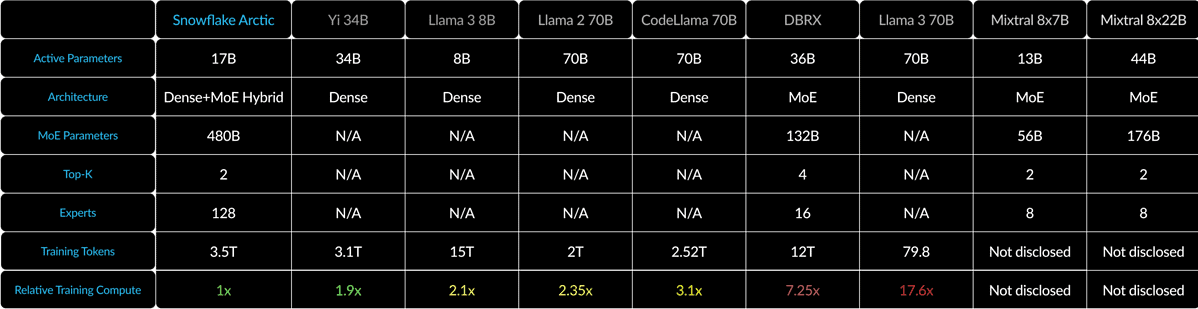

- Arctic 使用 Dense-MoE 混合系统优化了各种批量大小的效率。

Snowflake 是一家最初由前甲骨文科学家创建的云计算巨头,现在正在人工智能战争中向巨头发起挑战。公司推出 北极雪花,其最新的“企业人工智能最佳法学硕士”,并声称它比 Llama 3 70B 更好,并且比后者的 8B 变体更好。

Snowflake 在公告中声称 Arctic 模型的性能与 Llama 3 70B 相当,但计算要求和成本较低。它被誉为编码(HumanEval+ 和 MBPP+)、SQL 生成(Spider)和指令跟踪(IFEval)等领域和基准中企业智能任务的理想选择。

这是一个很大的主张,特别是考虑到 羊驼 3 70B 在重要测试中,与 GPT-4 Turbo 和 Claude 3 Opus 等其他主要模型相比,它表现良好。据报道,Meta 即将推出的模型在 MMLU(用于理解学科)、GPQA(生物学、物理和化学以及 HumanEval(编码))等基准测试中得分很高。

Snowflake Arctic 使用密集 MoE 混合技术将 10B 密集变压器与 128×3.66B MoE MLP 混合在一起。总共有 480B 个参数,但只有 17B 被主动使用,通过 top-2 选通进行选择。

对于像 1 这样的小批量大小,与 Code-Llama 4B 相比,Arctic 将内存读取量减少了 70 倍,比 Mixtral 2.5x8B 减少了 22 倍。但是,随着批量大小显着增加,Arctic 变得受计算限制。它的计算量比 CodeLlama 4B 和 Llama 70 3B 少 70 倍。

您可以尝试一下 Snowflake Arctic 拥抱脸。该公司还承诺该模型将很快登陆 AWS、Microsoft Azure、Perplexity 等其他模型花园。