微软的 Phi-2 2.7B 型号优于最近发布的 Google Gemini Nano-2 3.2B 型号

2分钟读

发表于

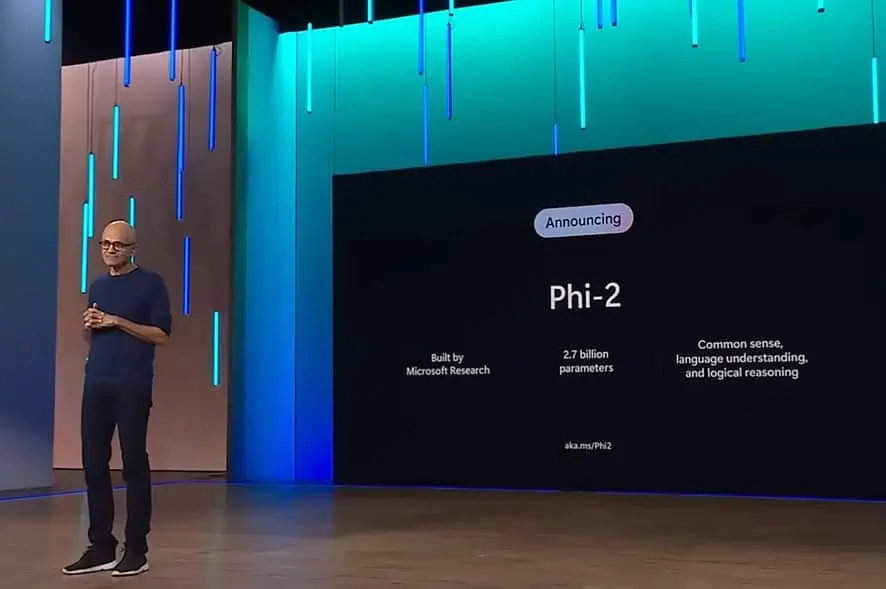

在过去的几个月里,微软研究院发布了一套名为“Phi”的小型语言模型(SLM)。 Phi-1 首先发布,拥有 1.3 亿个参数,专门用于基本的 Python 编码。 XNUMX月,微软研究院 发布 Phi-1.5 模型具有 1.3 亿个参数,但它是使用包含各种 NLP 合成文本的新数据源进行训练的。 尽管尺寸很小,但与其他类似尺寸的型号相比,phi-1.5 提供了近乎最先进的性能。

今天,微软宣布发布拥有 2 亿个参数的 Phi-2.7 模型。 微软研究院声称,这种新的 SLM 在参数少于 13 亿的基本语言模型中提供了最先进的性能。 在一些复杂的基准测试中,Phi-2 的性能可与大 25 倍的模型相匹配或优于模型。

上周,谷歌 公布 Gemini 语言模型套件。 Gemini Nano 是 Google 专为设备上任务而构建的最高效模型,它可以直接在移动芯片上运行。 类似 Gemini Nano 的小语言模型可实现文本摘要、上下文智能回复以及高级校对和语法纠正等功能。

据微软称,新的 Phi-2 型号尽管尺寸较小,但与新的 Google Gemini Nano-2 相当或优于新的 Google Gemini Nano-2。 您可以在下面找到 Google Gemini Nano-2 和 Phi-XNUMX 模型之间的基准比较。

| 型号 | 尺寸 | BBH | 布尔Q | MBPP | 百万美元 |

|---|---|---|---|---|---|

| 双子座纳米2 | 3.2B | 42.4 | 79.3 | 27.2 | 55.8 |

| Φ2 | 2.7B | 59.3 | 83.3 | 59.1 | 56.7 |

除了超越 Gemini Nano-2 之外,Phi-2 还在各种基准测试中的 2B 和 7B 参数上超越了 Mistral 和 Llama-13 模型的性能。 查找下面的详细信息。

| 型号 | 尺寸 | BBH | 常识 推理 | 语言 理解 | 数学 | 编码 |

|---|---|---|---|---|---|---|

| 羊驼-2 | 7B | 40.0 | 62.2 | 56.7 | 16.5 | 21.0 |

| 13B | 47.8 | 65.0 | 61.9 | 34.2 | 25.4 | |

| 70B | 66.5 | 69.2 | 67.6 | 64.1 | 38.3 | |

| 寒冷西北风 | 7B | 57.2 | 66.4 | 63.7 | 46.4 | 39.4 |

| Φ2 | 2.7B | 59.2 | 68.8 | 62.0 | 61.1 | 53.7 |

虽然前两个 phi 模型已在 Hugging Face 上提供, 披–2 已在 Azure 模型目录中提供。 您可以了解更多有关 Phi-2 的信息 相关信息.