Microsoft giới thiệu dòng model Phi-3 vượt trội so với các dòng model khác cùng loại

2 phút đọc

Được đăng trên

Đọc trang tiết lộ của chúng tôi để tìm hiểu cách bạn có thể giúp MSPoweruser duy trì nhóm biên tập Tìm hiểu thêm

Trở lại tháng 2023 năm XNUMX, Microsoft đã phát hành Phi-2 mô hình có 2.7 tỷ tham số mang lại hiệu suất vượt trội so với các mô hình ngôn ngữ cơ sở có ít hơn 13 tỷ tham số. Trong bốn tháng qua, một số mẫu khác được tung ra thị trường đã vượt trội hơn Phi-2. Gần đây, Meta đã phát hành dòng mô hình Llama-3 vượt trội hơn tất cả các mô hình nguồn mở được phát hành trước đó.

Đêm qua, Microsoft Research đã công bố dòng mẫu Phi-3 thông qua báo cáo kỹ thuật. Có ba mẫu trong dòng Phi-3:

- phi-3-mini (3.8B)

- phi-3-nhỏ (7B)

- phi-3-trung bình (14B)

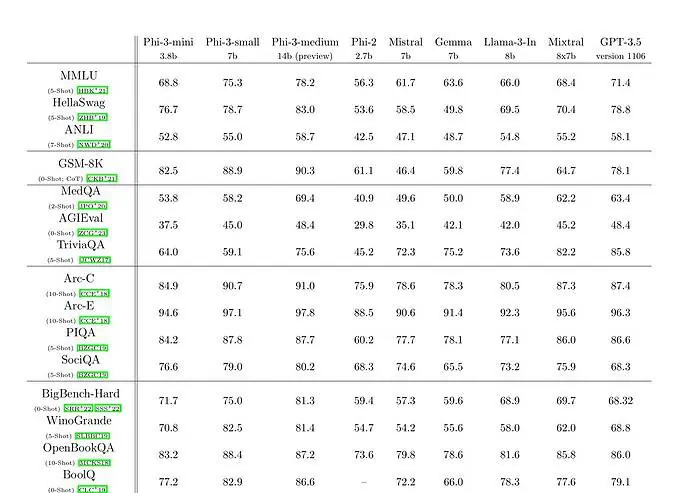

Phi-3-mini với mô hình ngôn ngữ tham số 3.8 tỷ được đào tạo trên 3.3 nghìn tỷ mã thông báo. Theo điểm chuẩn, phi-3-mini đánh bại Mixtral 8x7B và GPT-3.5. Microsoft tuyên bố rằng mô hình này đủ nhỏ để triển khai trên điện thoại. Microsoft đã sử dụng phiên bản mở rộng của tập dữ liệu được sử dụng cho phi-2, bao gồm dữ liệu web được lọc kỹ càng và dữ liệu tổng hợp. Theo kết quả benchmark của Microsoft trên Tài liệu kỹ thuật, phi-3-small và phi-3-medium đạt được số điểm MMLU ấn tượng lần lượt là 75.3 và 78.2.

Về khả năng LLM, mặc dù mô hình Phi-3-mini đạt được mức độ hiểu ngôn ngữ và khả năng suy luận tương tự như các mô hình lớn hơn nhiều, nhưng về cơ bản, nó vẫn bị hạn chế bởi kích thước của nó đối với một số nhiệm vụ nhất định. Đơn giản là mô hình không có khả năng lưu trữ kiến thức thực tế sâu rộng, chẳng hạn như có thể thấy điều này với hiệu suất thấp trên TriviaQA. Tuy nhiên, chúng tôi tin rằng điểm yếu này có thể được giải quyết bằng cách tăng cường bằng công cụ tìm kiếm.