Microsoft Azure AI представляє «Prompt Shields» для боротьби з маніпуляціями LLM

2 хв. читати

Опубліковано

Прочитайте нашу сторінку розкриття інформації, щоб дізнатися, як ви можете допомогти MSPoweruser підтримувати редакційну команду Читати далі

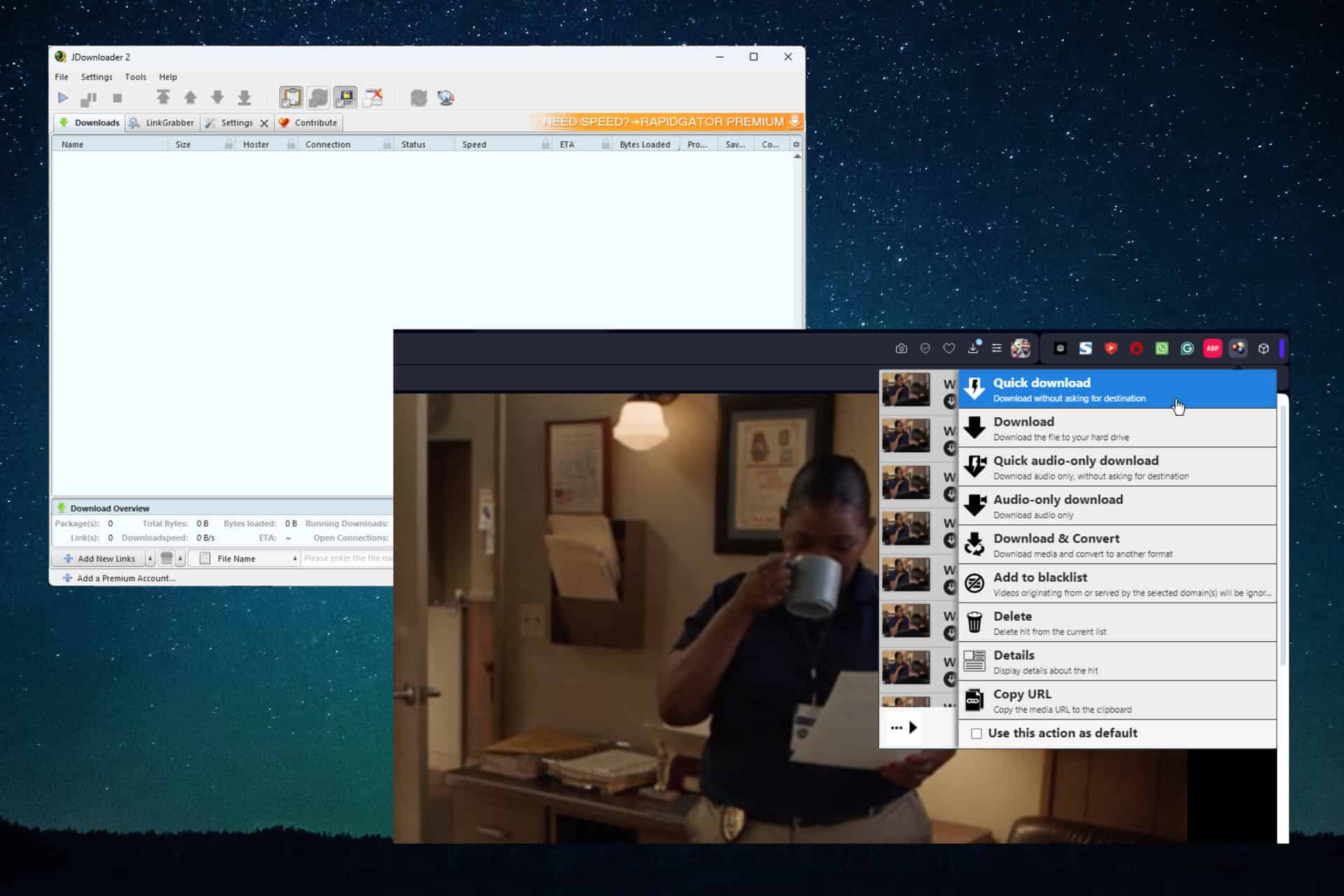

Microsoft сьогодні оголошений значне підвищення безпеки для платформ Azure OpenAI Service і Azure AI Content Safety. Нова функція під назвою «Prompt Shields» пропонує надійний захист від дедалі складніших атак, націлених на великі мовні моделі (LLM).

Prompt Shields захищає від:

- Прямі атаки: Також відомі як атаки джейлбрейка, ці спроби явно вказують LLM ігнорувати протоколи безпеки або виконувати зловмисні дії.

- Непрямі атаки: Ці атаки непомітно вбудовують шкідливі інструкції в начебто звичайний текст, щоб обманом спонукати LLM до небажаної поведінки.

Prompt Shields інтегровано з фільтрами вмісту Azure OpenAI Service і доступно в Azure AI Content Safety. Завдяки вдосконаленим алгоритмам машинного навчання та обробці природної мови Prompt Shields може ідентифікувати та нейтралізувати потенційні загрози в підказках користувачів і сторонніх даних.

Прожектор: нова техніка захисту

Корпорація Майкрософт також представила «Spotlighting», спеціалізований оперативний інженерний підхід, призначений для запобігання непрямим атакам. Методи висвітлення, такі як розмежування та позначення даних, допомагають LLM чітко розрізняти законні інструкції та потенційно шкідливі вбудовані команди.

доступність

Prompt Shields наразі доступний для загальнодоступної попередньої версії в рамках безпеки вмісту AI Azure і буде доступний у службі Azure OpenAI 1 квітня. Найближчим часом планується інтеграція в Azure AI Studio.