Google тепер використовує моделі BERT для покращення якості результатів пошуку

1 хв. читати

Опубліковано

Прочитайте нашу сторінку розкриття інформації, щоб дізнатися, як ви можете допомогти MSPoweruser підтримувати редакційну команду Читати далі

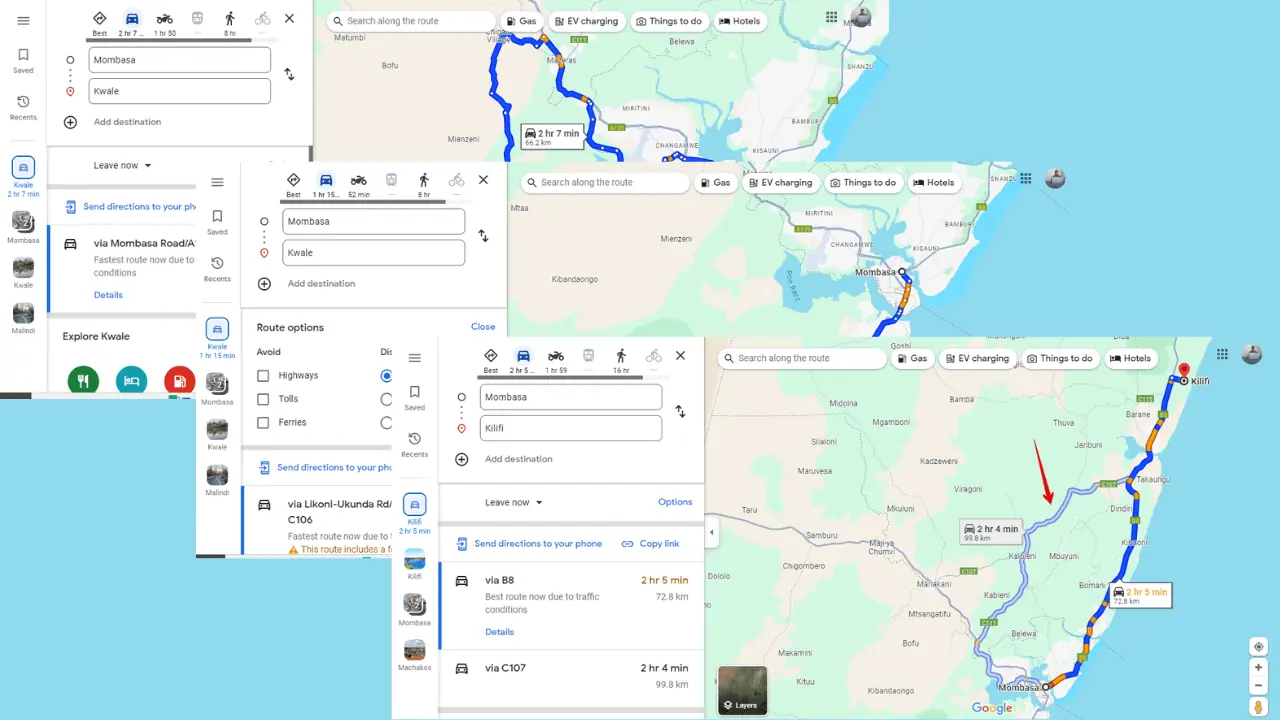

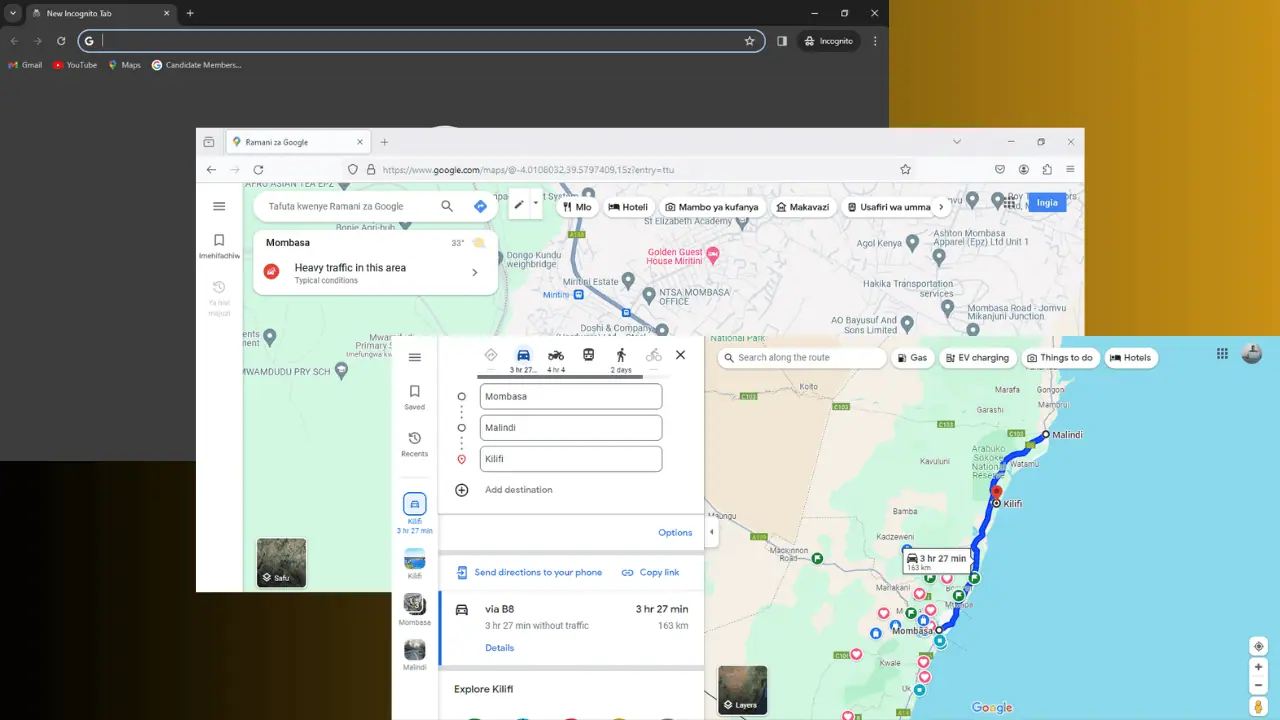

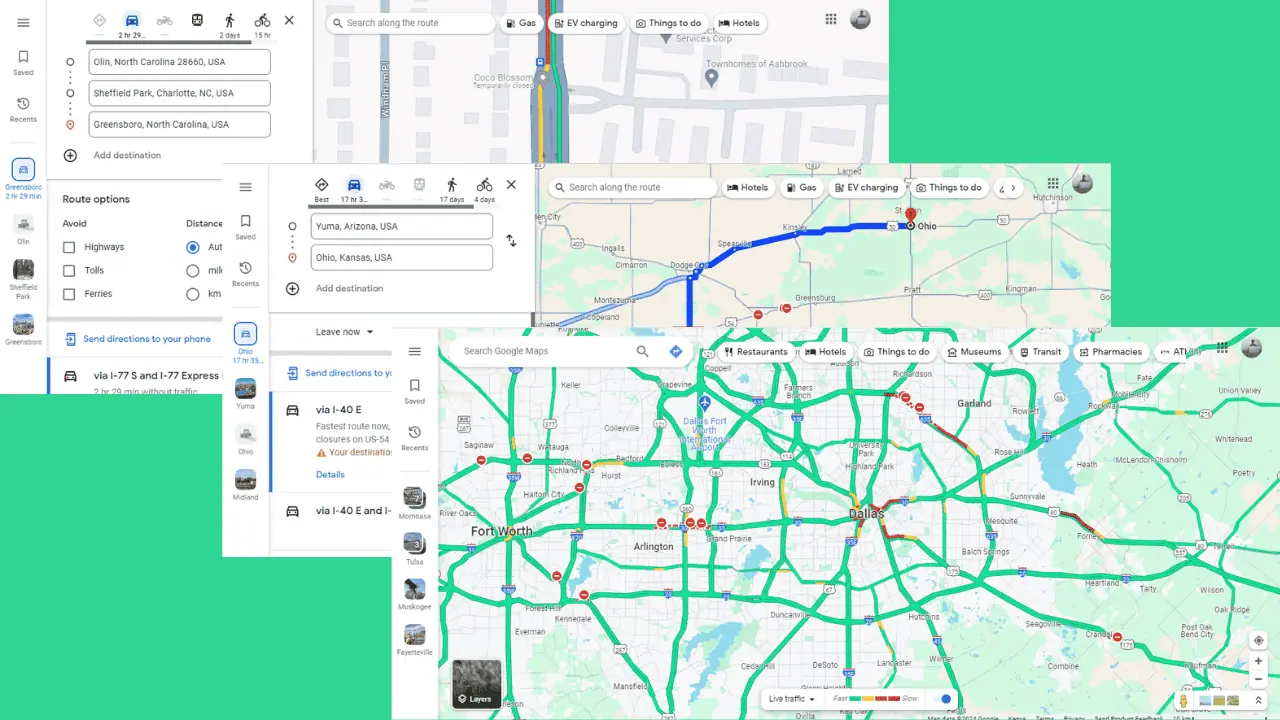

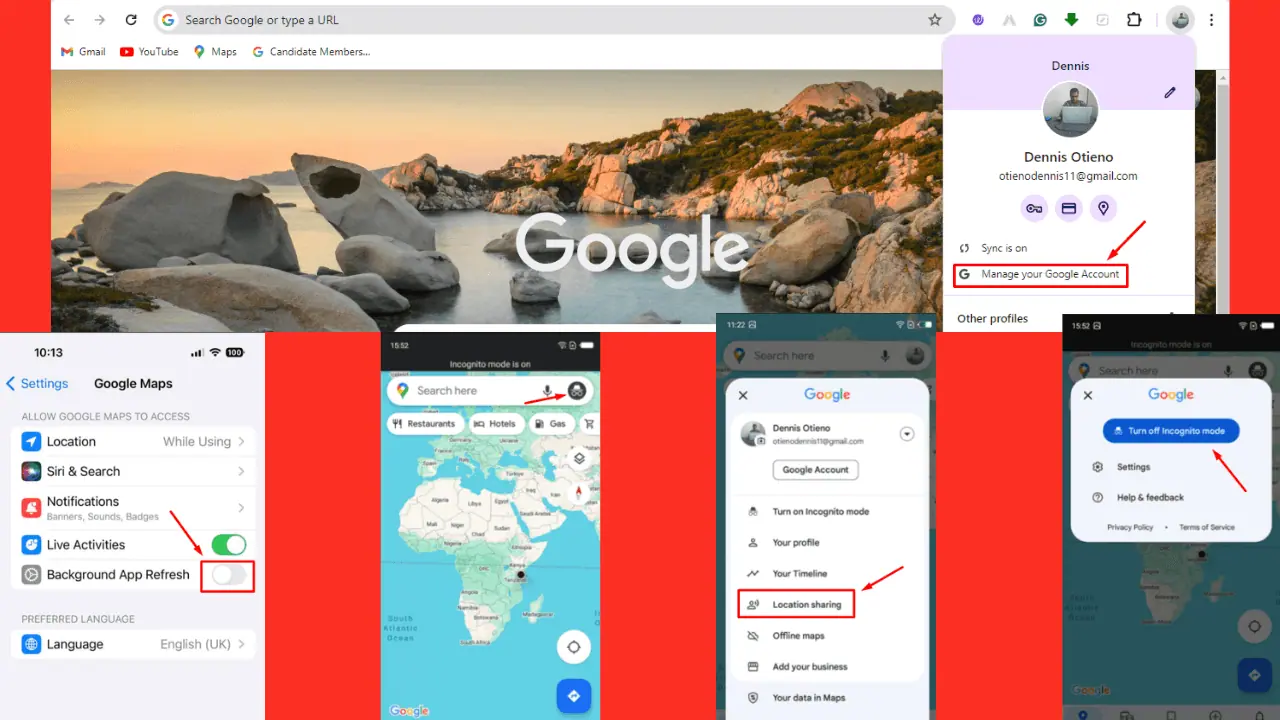

Сьогодні Google оголосила, що буде покращувати результати пошуку за допомогою техніки BERT. Bidirectional Encoder Representations from Transformers (BERT) — це метод на основі нейронної мережі для попереднього навчання обробки природної мови (NLP). Замість того, щоб розглядати кожне слово в реченні, BERT розгляне повний контекст слова, розглядаючи слова, які стоять перед і після нього. Google надав наступний приклад того, як BERT покращить результати пошуку.

Ось пошук за запитом «Мандрівнику з Бразилії в 2019 році потрібна віза». Слово «to» та його зв’язок з іншими словами в запиті особливо важливі для розуміння значення. Йдеться про бразильця, який подорожує до США, а не навпаки. Раніше наші алгоритми не розуміли важливості цього з’єднання, і ми повертали результати щодо громадян США, які подорожують до Бразилії.

Подивіться на зображення на початку статті. Google тепер може розуміти «стояти» як фізичну активність і надавати відповідні результати. Google зазначив, що BERT допоможе Пошуку краще зрозуміти один з 10 пошукових запитів у США англійською мовою. У найближчі місяці Google також представить технологію BERT у більшій кількості мов і регіонів.

джерело: Google