Opera กลายเป็นเบราว์เซอร์ตัวแรกที่รวม Local LLM

1 นาที. อ่าน

อัปเดตเมื่อวันที่

อ่านหน้าการเปิดเผยข้อมูลของเราเพื่อดูว่าคุณจะช่วย MSPoweruser รักษาทีมบรรณาธิการได้อย่างไร อ่านเพิ่มเติม

หมายเหตุสำคัญ

- ขณะนี้ผู้ใช้สามารถจัดการและเข้าถึงโมเดล AI อันทรงพลังบนอุปกรณ์ของตนได้โดยตรง ซึ่งให้ความเป็นส่วนตัวและความเร็วที่เพิ่มขึ้นเมื่อเทียบกับ AI บนคลาวด์

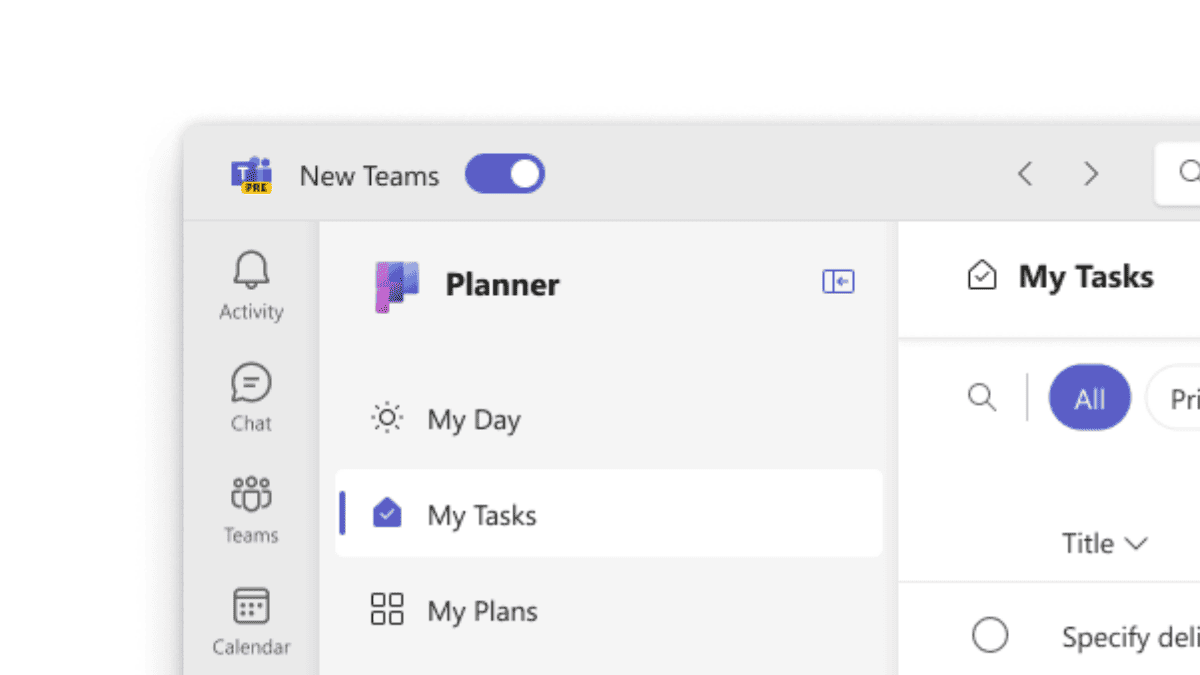

โอเปร่าวันนี้ ประกาศ การสนับสนุนการทดลองสำหรับโมเดลภาษาขนาดใหญ่ (LLM) ท้องถิ่น 150 รายการภายในเบราว์เซอร์นักพัฒนา Opera One ด้วยการสนับสนุนนี้ ผู้ใช้สามารถจัดการและเข้าถึงโมเดล AI อันทรงพลังบนอุปกรณ์ของตนได้โดยตรง โดยให้ความเป็นส่วนตัวและความเร็วที่เพิ่มขึ้นเมื่อเทียบกับ AI บนคลาวด์

เพิ่มทางเลือกและความเป็นส่วนตัวด้วย LLM ท้องถิ่น

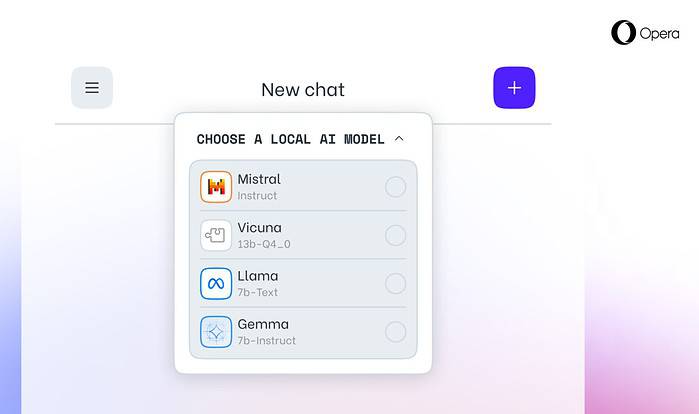

การบูรณาการของ Opera รวมถึง LLM ยอดนิยม เช่น Llama ของ Meta, Vicuna, Gemma ของ Google, Mixtral ของ Mistral AI และอีกมากมาย LLM ในพื้นที่ขจัดความจำเป็นในการแบ่งปันข้อมูลกับเซิร์ฟเวอร์ เพื่อปกป้องความเป็นส่วนตัวของผู้ใช้ โปรแกรม AI Feature Drops ของ Opera ช่วยให้นักพัฒนาสามารถเข้าถึงฟีเจอร์ล้ำสมัยเหล่านี้ได้ก่อนใคร

วิธีการเข้าถึง LLM ท้องถิ่นใน Opera

ผู้ใช้สามารถเยี่ยมชม ไซต์ผู้พัฒนาของ Opera เพื่ออัปเกรดเป็น Opera One Developer ช่วยให้สามารถเลือกและดาวน์โหลด LLM ท้องถิ่นที่ต้องการได้ แม้ว่าต้องใช้พื้นที่จัดเก็บข้อมูล (2-10 GB ต่อรุ่น) LLM ในพื้นที่สามารถเสนอการเร่งความเร็วได้อย่างมีนัยสำคัญเหนือทางเลือกอื่นบนคลาวด์ โดยขึ้นอยู่กับฮาร์ดแวร์

ความมุ่งมั่นของ Opera ต่อนวัตกรรม AI

“การแนะนำ LLM ท้องถิ่นในลักษณะนี้ทำให้ Opera สามารถเริ่มสำรวจวิธีการสร้างประสบการณ์และความรู้ความชำนาญภายในพื้นที่ AI ท้องถิ่นที่กำลังเติบโตอย่างรวดเร็ว” Krystian Kolondra รองประธานฝ่ายเบราว์เซอร์และเกมของ Opera กล่าว