Microsoft patenterar ett "Multiple Stage Shy User Interface" designat för 3D Touch

4 min. läsa

Publicerad den

Läs vår informationssida för att ta reda på hur du kan hjälpa MSPoweruser upprätthålla redaktionen Läs mer

Microsoft håller på att bygga upp en ganska stor portfölj av 3D Touch-baserade användargränssnittspatent, där det senaste är en förfining av de så kallade blyga användargränssnittselementen som vanligtvis finns i många operativsystem.

Exempel på "blyga" användargränssnitt skulle vara videokontrollerna som försvinner från skärmen om du inte trycker på skärmen, eller webbläsarens adressfält som också försvinner när du läser men inte rör sidan.

Gemensamt för den typen av kontroller är att det bara finns en nivå av interaktion – de är antingen synliga eller osynliga.

Microsofts förfining skulle vara att lägga till flera steg i interaktionen, där avsikten samlas in genom mer än att bara röra skärmen, som att till exempel närma sig skärmen med fingret eller sväva över kontrollerna, upptäckt med 3D Touch-sensorer som Microsoft redan demonstrerat i Nokia McLaren.

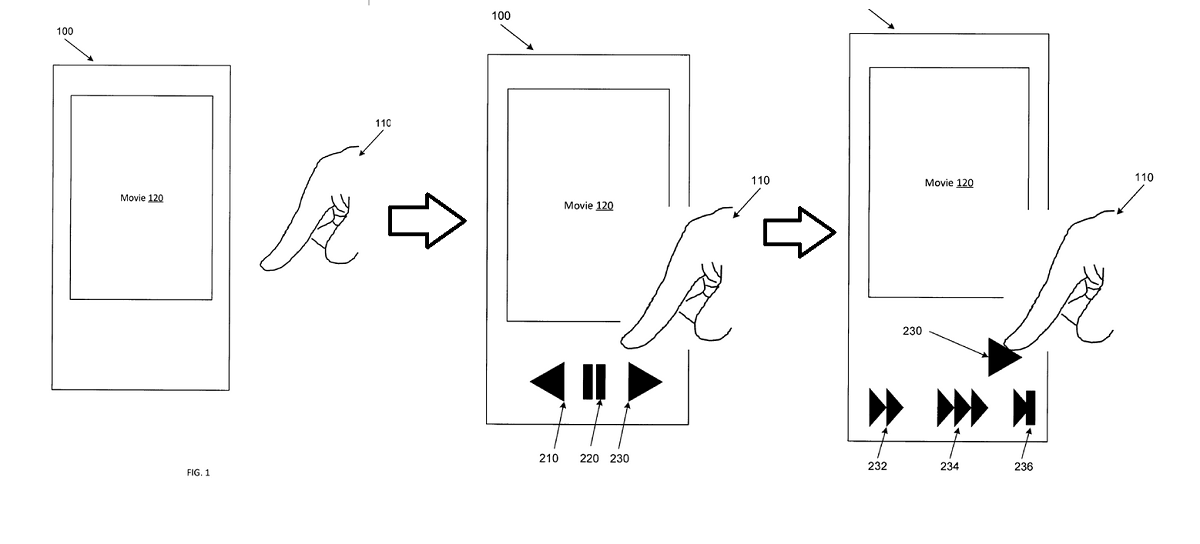

I exemplet ovan skulle en användare närma sig en videospelare med fingret, vilket skulle avslöja kontrollerna. När de kommer närmare snabbspolningsknappen framåt avslöjas olika hastigheter för snabbspolning framåt som ett andra steg, vilket gör användarens interaktion mer flytande och bekväm.

Med patentets egna ord:

Exempel på apparater och metoder förbättras jämfört med konventionella tillvägagångssätt för interaktion mellan människa och enhet genom att avslöja UI-element eller funktionalitet i flera kontextberoende stadier baserat på att urskilja en användares avsikt. Exempel på apparater och metoder kan förlita sig på tredimensionella (3D) berörings- eller hovringssensorer som detekterar närvaron, positionen, orienteringen, färdriktningen eller färdhastigheten för en pekare (t.ex. användarens finger, redskap, penna, penna). 3D-sensorerna kan tillhandahålla information från vilken en bestämning kan göras om vid vilket objekt, element eller område i ett gränssnitt en användare pekar, gester, eller på annat sätt interagerar med eller indikerar en avsikt att interagera med. Om användaren inte har navigerat aktivt på enheten, kan exempelapparater och metoder dyka upp (t.ex. visa) kontextrelevanta UI-element eller åtgärder som inte tidigare visades. Om en användare till exempel tittar på en video, kan ett översta lager av videokontrollelement visas. Till skillnad från konventionella system, om användaren sedan bibehåller eller begränsar sitt fokus på eller nära ett visst UI-element som just avslöjades, kan ett andra eller efterföljande lager av videokontrollelement eller effekter dyka upp. Efterföljande djupare lager i en hierarki kan presenteras när användaren interagerar med elementen på ytan.

Exempel på apparater och metoder kan underlätta förbättrade, snabbare och mer intuitiva interaktioner med ett bredare spektrum av UI-element, kontroller eller effekter utan att kräva ihållande tillstånd på skärmen eller dolda gester som kan vara svåra att upptäcka eller lära sig. Enkla lagerkontroller som avslöjas när en skärmberöring eller gest detekteras är välkända. Dessa kontroller som visas selektivt när en skärmberöring eller gest detekteras kan kallas "skygga" kontroller. Exempel på apparater och metoder förbättrar dessa beröringsbaserade tillvägagångssätt med ett lager genom att tillhandahålla flerlagers blyga kontroller och effekter som avslöjas på ett sammanhangskänsligt sätt baserat på inmatningar inklusive beröring, hovring, taktil eller röstinteraktioner. Svävningskänsliga gränssnitt kan upptäcka inte bara närvaron av en användares finger, utan också vinkeln med vilken fingret pekar, hastigheten med vilken fingret rör sig, i vilken riktning fingret rör sig eller andra egenskaper hos fingret. Sålunda, snarare än en binär {touch: yes/no}-tillståndsdetektering, kan ett inmatningsutrymme av högre ordning analyseras för att bestämma en användares avsikt med avseende på ett användargränssnittselement. 3D-närhetsdetektorer kan avgöra vilket objekt eller vilket skärmläge användaren avser att interagera med och kan sedan upptäcka och karakterisera flera attribut för interaktionen.

Det är inte känt om Microsoft fortfarande arbetar med 3D Touch för sina telefoner, men tekniken skulle vara lika tillämplig på RealSense-kameror som med Windows Hello eller med Hololens via blickavkänning och handspårning.

Skulle våra läsare uppskatta ett användargränssnitt som svarar dynamiskt på din avsikt eller skulle du föredra ett som förblir ganska fixerat och förutsägbart? Låt oss veta nedan.