Microsoft Azure AI avslöjar "Prompt Shields" för att bekämpa LLM-manipulation

2 min. läsa

Publicerad den

Läs vår informationssida för att ta reda på hur du kan hjälpa MSPoweruser upprätthålla redaktionen Läs mer

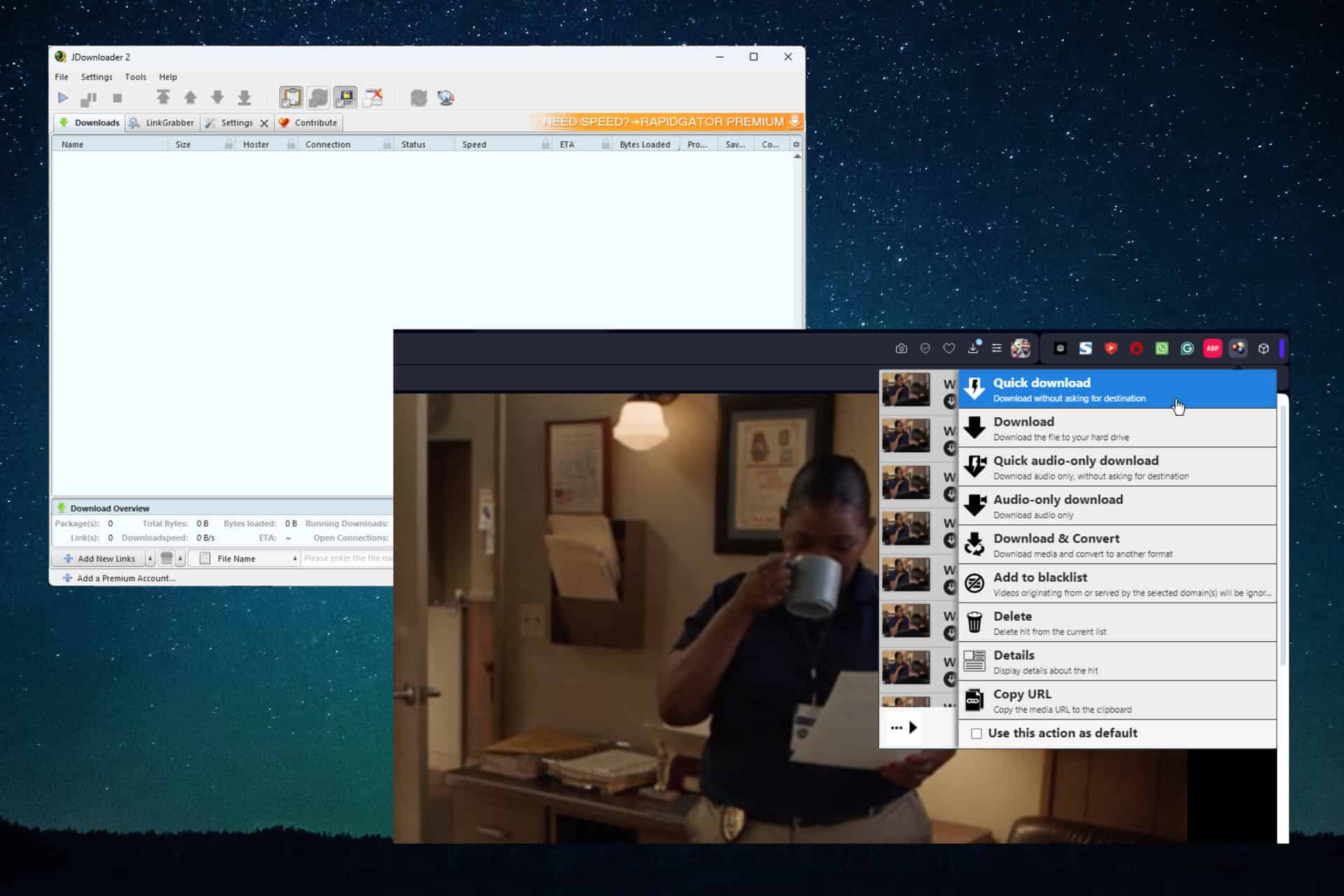

Microsoft idag meddelade en stor säkerhetsförbättring för dess Azure OpenAI Service och Azure AI Content Safety-plattformar. Den nya funktionen, kallad "Prompt Shields", erbjuder robust försvar mot allt mer sofistikerade attacker som riktar sig mot stora språkmodeller (LLM).

Prompt Shields skyddar mot:

- Direkta attacker: Även kända som jailbreak-attacker, dessa försök instruerar uttryckligen LLM att ignorera säkerhetsprotokoll eller utföra skadliga åtgärder.

- Indirekta attacker: Dessa attacker bäddar subtilt in skadliga instruktioner i till synes normal text, i syfte att lura LLM till oönskat beteende.

Prompt Shields är integrerat med Azure OpenAI Service-innehållsfilter och är tillgängliga i Azure AI Content Safety. Tack vare avancerade maskininlärningsalgoritmer och naturlig språkbehandling kan Prompt Shields identifiera och neutralisera potentiella hot i användarmeddelanden och data från tredje part.

Spotlighting: A Novel Defense Technique

Microsoft introducerade också "Spotlighting", en specialiserad prompt ingenjörskonst som utformats för att motverka indirekta attacker. Spotlighting-tekniker, såsom avgränsning och datamarkering, hjälper LLM:er att tydligt skilja mellan legitima instruktioner och potentiellt skadliga inbäddade kommandon.

Tillgänglighet

Prompt Shields är för närvarande i offentlig förhandsvisning som en del av Azure AI Content Safety och kommer att finnas tillgänglig i Azure OpenAI Service den 1 april. Integrering i Azure AI Studio planeras inom en snar framtid.