Opera postane prvi brskalnik, ki integrira lokalne LLM

1 min. prebrati

Posodobljeno dne

Preberite našo stran za razkritje, če želite izvedeti, kako lahko pomagate MSPoweruser vzdrževati uredniško skupino Preberi več

Ključne opombe

- Uporabniki lahko zdaj neposredno upravljajo in dostopajo do zmogljivih modelov umetne inteligence na svojih napravah, kar ponuja izboljšano zasebnost in hitrost v primerjavi z umetno inteligenco v oblaku.

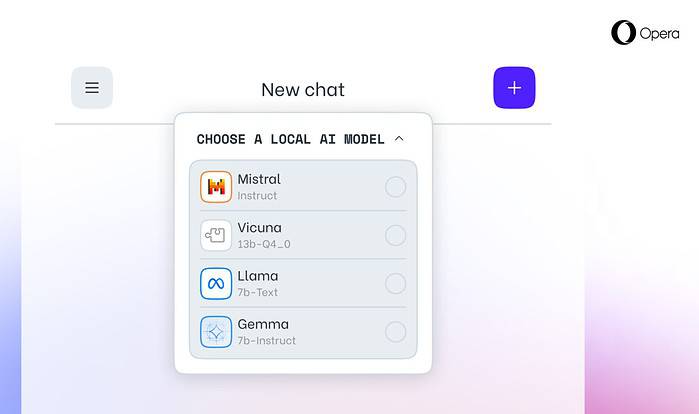

Opera danes razglasitve eksperimentalna podpora za 150 lokalnih modelov velikih jezikov (LLM) v svojem brskalniku za razvijalce Opera One. S to podporo lahko uporabniki zdaj neposredno upravljajo in dostopajo do zmogljivih modelov umetne inteligence na svojih napravah, kar ponuja izboljšano zasebnost in hitrost v primerjavi z umetno inteligenco v oblaku.

Razširjena izbira in zasebnost z lokalnimi LLM

Integracija Opere vključuje priljubljene LLM-je, kot so Metina Llama, Vicuna, Googlova Gemma, Mistral AI Mixtral in še veliko več. Lokalni LLM-ji odpravljajo potrebo po skupni rabi podatkov s strežniki in ščitijo zasebnost uporabnikov. Opera's AI Feature Drops Program omogoča razvijalcem zgodnji dostop do teh vrhunskih funkcij.

Kako dostopati do lokalnih LLM v Operi

Uporabniki lahko obiščejo Spletno mesto za razvijalce Opera za nadgradnjo na Opera One Developer, ki omogoča izbiro in prenos njihovega želenega lokalnega LLM. Medtem ko potrebujejo prostor za shranjevanje (2–10 GB na model), lahko lokalni LLM ponudijo znatno povečanje hitrosti v primerjavi z alternativami v oblaku, odvisno od strojne opreme.

Operina zavezanost inovacijam umetne inteligence

»Uvedba lokalnih LLM-jev na ta način omogoča Operi, da začne raziskovati načine gradnje izkušenj in znanja znotraj hitro razvijajočega se lokalnega prostora umetne inteligence,« je povedal Krystian Kolondra, EVP za brskalnike in igre pri Operi.