Opera sa stáva prvým prehliadačom, ktorý integruje lokálne LLM

1 min. čítať

Aktualizované na

Prečítajte si našu informačnú stránku a zistite, ako môžete pomôcť MSPoweruser udržať redakčný tím Čítaj viac

Kľúčové poznámky

- Používatelia môžu teraz priamo spravovať a pristupovať k výkonným modelom AI na svojich zariadeniach, čo ponúka lepšie súkromie a rýchlosť v porovnaní s AI založenou na cloude.

Opera dnes oznámila, experimentálna podpora pre 150 miestnych veľkých jazykových modelov (LLM) v rámci vývojárskeho prehliadača Opera One. Vďaka tejto podpore môžu teraz používatelia priamo spravovať a pristupovať k výkonným modelom AI na svojich zariadeniach, čo ponúka lepšie súkromie a rýchlosť v porovnaní s umelou inteligenciou založenou na cloude.

Rozšírený výber a ochrana osobných údajov s miestnymi LLM

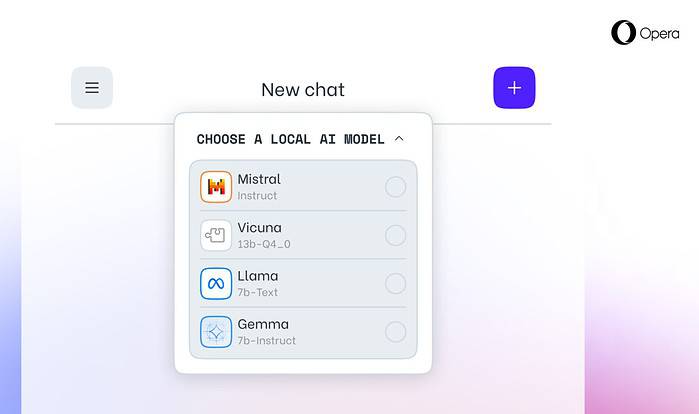

Integrácia Opery zahŕňa populárne LLM ako Meta's Llama, Vicuna, Google Gemma, Mistral AI Mixtral a mnoho ďalších. Lokálne LLM eliminujú potrebu zdieľania údajov so servermi, čím chránia súkromie používateľov. Program Opera's AI Feature Drops Program umožňuje vývojárom skorý prístup k týmto špičkovým funkciám.

Ako získať prístup k lokálnym LLM v Opere

Používatelia môžu navštíviť Vývojársky web Opera inovovať na Opera One Developer, čo umožní výber a stiahnutie preferovaného lokálneho LLM. Aj keď vyžadujú úložný priestor (2 – 10 GB na model), miestne LLM môžu ponúknuť výrazné zvýšenie rýchlosti oproti cloudovým alternatívam v závislosti od hardvéru.

Záväzok Opery k inováciám AI

„Zavedenie lokálnych LLM týmto spôsobom umožňuje Opere začať skúmať spôsoby budovania skúseností a know-how v rámci rýchlo sa rozvíjajúceho lokálneho priestoru AI,“ povedal Krystian Kolondra, EVP Browsers and Gaming v Opera.