Opera devine primul browser care integrează LLM-uri locale

1 min. citit

Actualizat pe

Citiți pagina noastră de dezvăluire pentru a afla cum puteți ajuta MSPoweruser să susțină echipa editorială Află mai multe

Note cheie

- Utilizatorii pot acum să gestioneze și să acceseze direct modele AI puternice pe dispozitivele lor, oferind confidențialitate și viteză îmbunătățite în comparație cu AI bazată pe cloud.

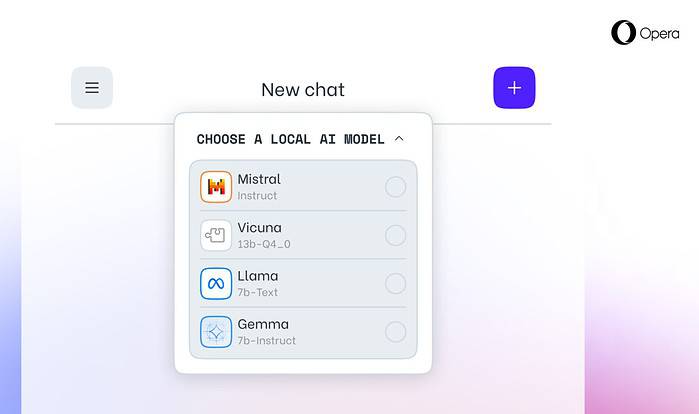

Opera azi a anunțat suport experimental pentru 150 de modele locale de limbi mari (LLM) în browserul său pentru dezvoltatori Opera One. Cu acest suport, utilizatorii pot acum să gestioneze și să acceseze direct modele AI puternice pe dispozitivele lor, oferind confidențialitate și viteză îmbunătățite în comparație cu IA bazată pe cloud.

Opțiuni extinse și confidențialitate cu LLM-uri locale

Integrarea Opera include LLM-uri populare precum Llama de la Meta, Vicuna, Gemma de la Google, Mixtral de la Mistral AI și multe altele. LLM-urile locale elimină necesitatea de a partaja date cu serverele, protejând confidențialitatea utilizatorilor. Programul Opera AI Feature Drops permite dezvoltatorilor acces timpuriu la aceste funcții de ultimă oră.

Cum să accesați LLM-urile locale în Opera

Utilizatorii pot vizita Site-ul pentru dezvoltatori Opera pentru a face upgrade la Opera One Developer, permițând selectarea și descărcarea LLM-ului lor local preferat. Deși necesită spațiu de stocare (2-10 GB per model), LLM-urile locale pot oferi o creștere semnificativă a vitezei față de alternativele bazate pe cloud, în funcție de hardware.

Angajamentul Opera față de inovarea AI

„Introducerea LLM-urilor locale în acest fel îi permite Opera să înceapă să exploreze modalități de a construi experiențe și know-how în spațiul AI local care se dezvoltă rapid”, a declarat Krystian Kolondra, EVP Browsers and Gaming la Opera.