Microsoft Research introduce Splitwise, o nouă tehnică pentru a crește eficiența GPU-ului pentru modelele de limbaj mari

2 min. citit

Publicat în data de

Citiți pagina noastră de dezvăluire pentru a afla cum puteți ajuta MSPoweruser să susțină echipa editorială Află mai multe

Note cheie

- Splitwise este o descoperire în eficiența și sustenabilitatea inferenței LLM.

- Separând fazele prompt și token, Splitwise deblochează un nou potențial în utilizarea GPU-ului și le permite furnizorilor de cloud să depună mai multe interogări mai rapid cu același buget de putere.

Modelele de limbaj mari (LLM) transformă domeniile procesării limbajului natural și ale inteligenței artificiale, permițând aplicații precum generarea de coduri, agenții conversaționali și rezumarea textului. Cu toate acestea, aceste modele reprezintă și provocări semnificative pentru furnizorii de cloud, care trebuie să implementeze din ce în ce mai multe unități de procesare grafică (GPU) pentru a răspunde cererii tot mai mari de inferență LLM.

Problema este că GPU-urile nu sunt doar scumpe, ci și consumatoare de energie, iar capacitatea de a furniza energie electrică necesară pentru a le rula este limitată. Drept urmare, furnizorii de servicii cloud se confruntă adesea cu dilema fie de a respinge întrebările utilizatorilor, fie de a-și crește costurile operaționale și impactul asupra mediului.

Pentru a aborda această problemă, cercetătorii de la Microsoft Azure au dezvoltat o tehnică nouă numită Splitwise, care își propune să facă inferența LLM mai eficientă și mai durabilă prin împărțirea calculului în două faze distincte și alocarea acestora pe mașini diferite. Puteți citi despre această tehnică în detaliu în „Splitwise: Inferență generativă eficientă LLM folosind divizarea fază" lucrare de cercetare.

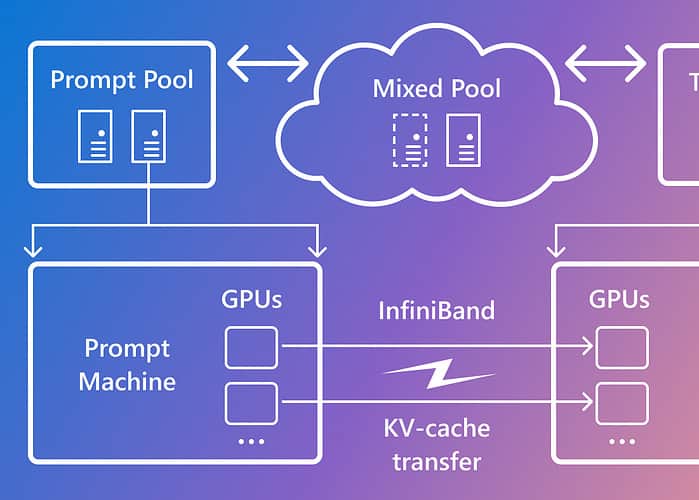

Splitwise se bazează pe observația că inferența LLM constă din două faze cu caracteristici diferite: faza promptă și faza de generare a simbolurilor. În faza de prompt, modelul procesează intrarea utilizatorului, sau promptul, în paralel, folosind o mulțime de calcul GPU. În faza de generare a token-ului, modelul generează fiecare jeton de ieșire secvenţial, folosind o mare lățime de bandă a memoriei GPU. Pe lângă separarea celor două faze de inferență LLM în două pool-uri distincte de mașini, Microsoft a folosit un al treilea pool de mașini pentru loturi mixte în fazele prompt și token, dimensionate dinamic pe baza cerințelor de calcul în timp real.

Folosind Splitwise, Microsoft a reușit să obțină următoarele:

- Debit de 1.4 ori mai mare la un cost cu 20% mai mic decât modelele actuale.

- Performanță de 2.35 ori mai mare cu aceleași bugete de cost și putere.

Splitwise este o descoperire în eficiența și sustenabilitatea inferenței LLM. Separând fazele prompt și token, Splitwise deblochează un nou potențial în utilizarea GPU-ului și le permite furnizorilor de cloud să depună mai multe interogări mai rapid cu același buget de putere. Splitwise face acum parte din vLLM și poate fi implementat și cu alte cadre. Cercetătorii de la Microsoft Azure intenționează să-și continue munca pentru a face inferența LLM mai eficientă și mai durabilă și au în vedere grupuri de mașini personalizate care conduc la un randament maxim, costuri reduse și eficiență energetică.