Viitorul model Llama-3 400B al Meta ar putea depăși GPT-4 Turbo și Claude 3 Opus

Nu le depășește, dar are potențial

2 min. citit

Publicat în data de

Citiți pagina noastră de dezvăluire pentru a afla cum puteți ajuta MSPoweruser să susțină echipa editorială Află mai multe

Note cheie

- Meta dezvăluie Llama-3, cel mai puternic model al său, cu parametri de 700B

- Llama-3 prezintă potențial de îmbunătățire, în ciuda faptului că se află în faza de antrenament

- Cifrele recente sugerează că este aproape de Claude 3 Opus și GPT-4 Turbo în benchmark-uri

Meta este pregătită să lanseze cel mai puternic model AI al său, cel Lama-3 cu parametri 400B. În ea anunț joi, modelul open-source va alimenta în curând instrumentul de asistent Meta AI care vine pe WhatsApp și Instagram.

Dar adevărul este că există o mulțime de modele AI puternice pe piață în acest moment. GPT-4 Turbo cu o fereastră de context de 128k de la OpenAI există de ceva timp, iar Claude 3 Opus de la Anthropic este acum disponibil pe Amazon Bedrock.

Deci, cum se compară aceste modele între ele, pe baza mai multor criterii de referință? Iată o comparație a modului în care aceste modele puternice au fost testate în mai multe opțiuni. Aceste cifre sunt preluate din informații disponibile public și a lui Meta anunț.

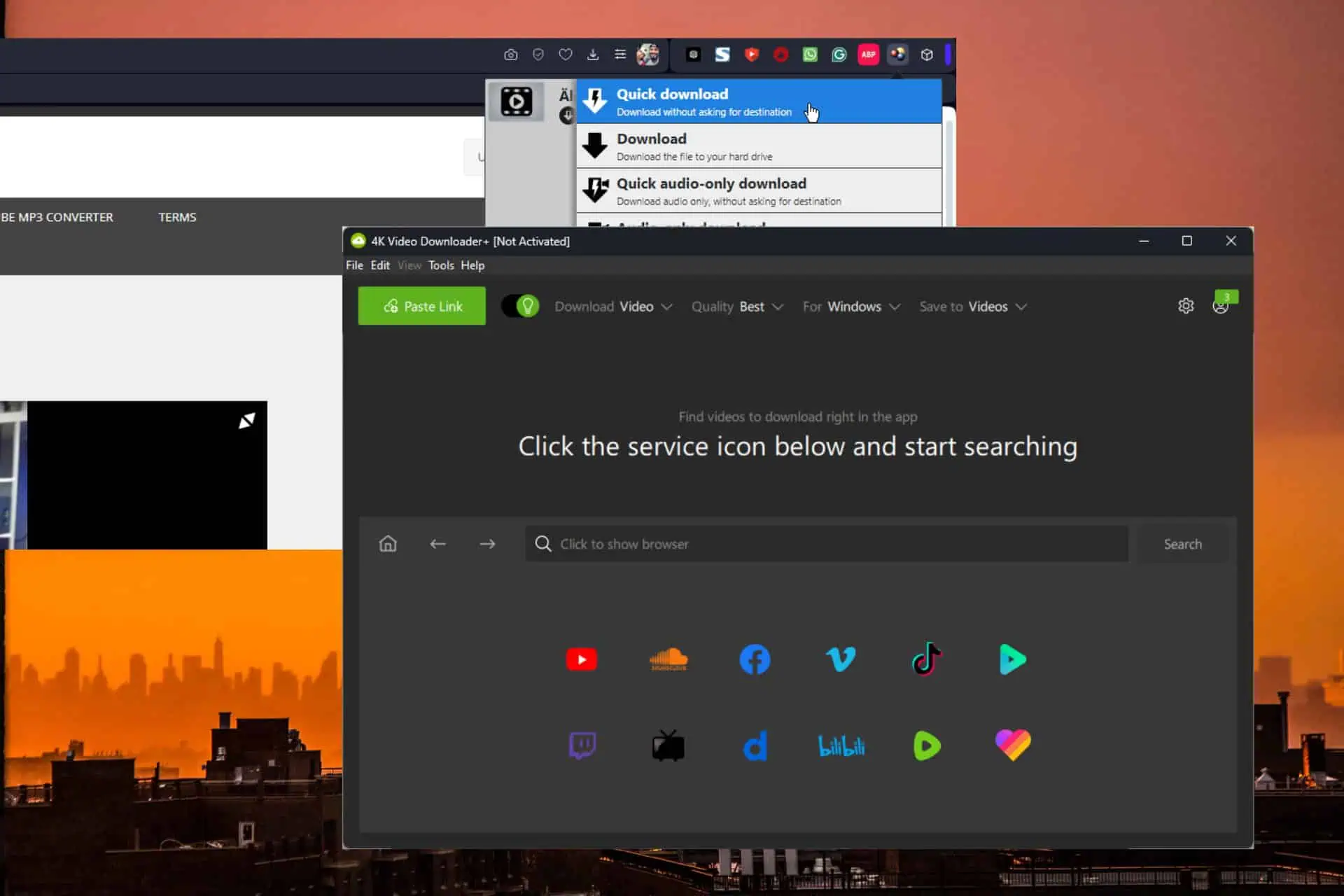

| Benchmark | Lama 3 400B | Claude 3 Opus | GPT-4 Turbo | Gemini Ultra 1.0 | Gemini Pro 1.5 |

| MMLU | 86.1 | 86.8 | 86.5 | 83.7 | 81.9 |

| GPQA | 48 | 50.4 | 49.1 | - | - |

| HumanEval | 84.1 | 84.9 | 87.6 | 74.4 | 71.9 |

| MATH | 57.8 | 60.1 | 72.2 | 53.2 | 58.5 |

După cum puteți vedea, Llama-3 400B se încadrează ușor în aceste puncte de referință, obținând 86.1 în MMLU, 48 în GPQA, 84.1 în HumanEval și 57.8 în MATH.

Dar, având în vedere că este încă în faza de antrenament, există o posibilitate bună de îmbunătățiri mari odată ce este complet implementat. Iar pentru un model open-source, acesta este mult dincolo de impresionant.

MMLU testează cât de bine modelele înțeleg diferite subiecte fără a le preda direct, acoperind o gamă largă de subiecte. GPQA, pe de altă parte, sortează modelele în funcție de cât de bine se descurcă în biologie, fizică și chimie, în timp ce HumanEval se concentrează pe modul în care codifică.