Free Software Foundation uważa, że GitHub Copilot powinien być nielegalny

3 minuta. czytać

Zaktualizowano na

Przeczytaj naszą stronę z informacjami, aby dowiedzieć się, jak możesz pomóc MSPoweruser w utrzymaniu zespołu redakcyjnego Czytaj więcej

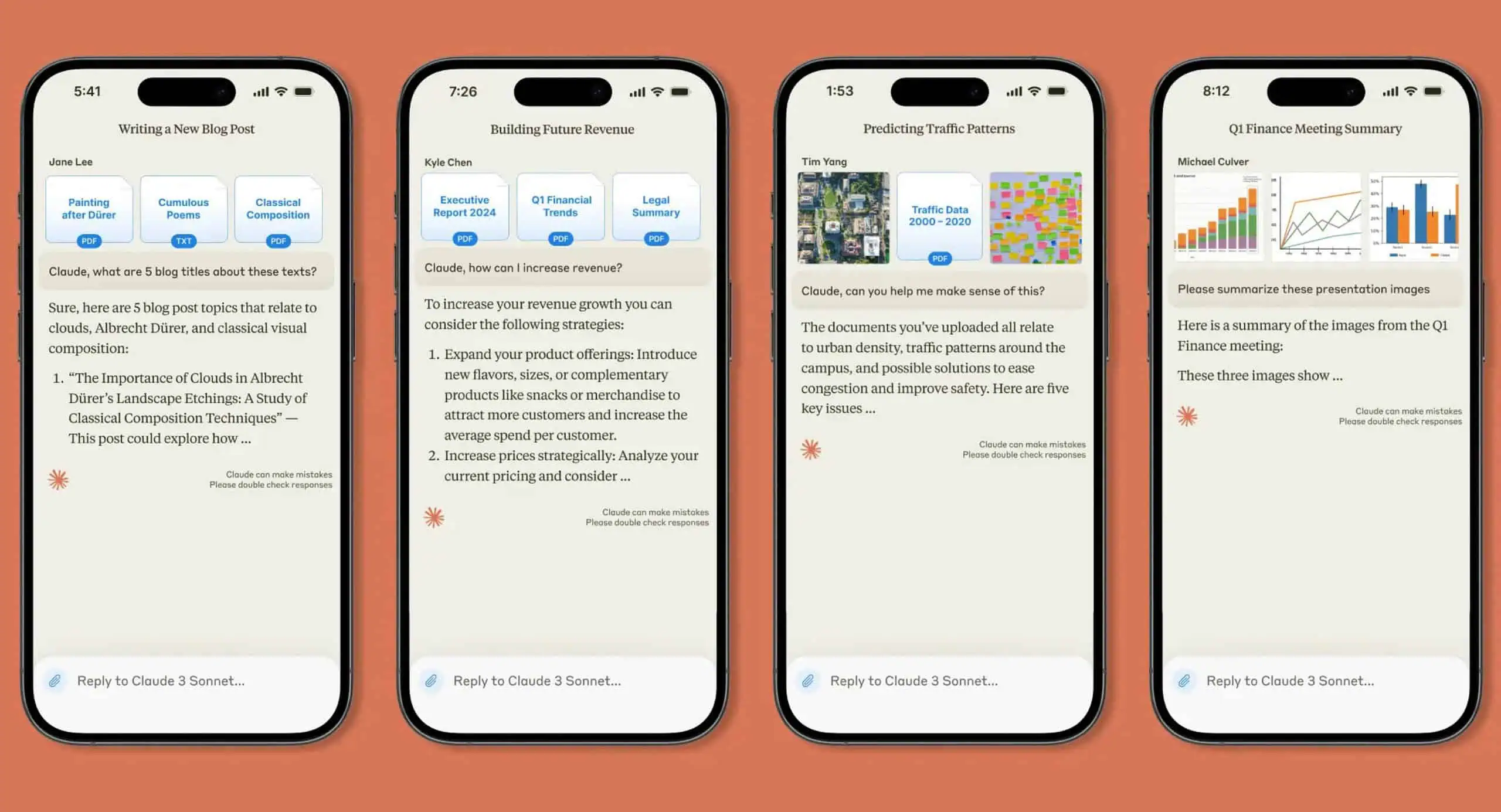

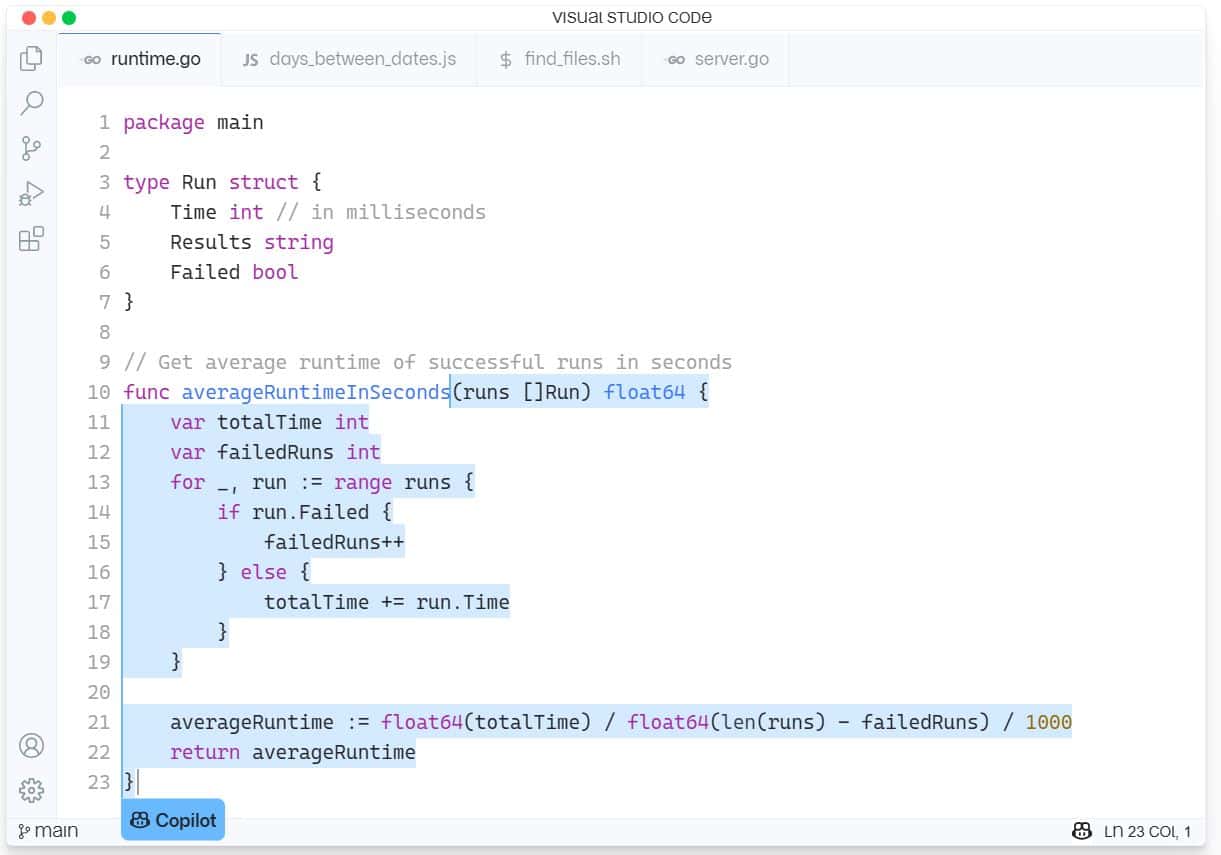

GitHub Copilot to nowa usługa pomocy AI do tworzenia oprogramowania wbudowana w Visual Studio Code firmy Microsoft. GitHub Copilot obsługuje różne języki i frameworki oraz ułatwia życie programistom, oferując sugestie dotyczące całych linii lub całych funkcji bezpośrednio w środowisku IDE. GitHub Copilot jest obsługiwany przez OpenAI Codex i został przeszkolony w miliardach wierszy kodu o otwartym kodzie źródłowym.

Ostatni problem spowodował, że Free Software Foundation (FSF) ma ogromną pszczołę w swojej masce, nazywając narzędzie „nie do przyjęcia i niesprawiedliwe z naszej perspektywy”.

Adwokat oprogramowania open source skarży się, że Copilot wymaga do działania oprogramowania o zamkniętym kodzie źródłowym, takiego jak Microsoft Visual Studio IDE lub edytor Visual Studio Code, i że stanowi ono „usługę jako substytut oprogramowania”, co oznacza, że jest sposobem na zdobycie władzy nad komputerami innych ludzi.

FSF uznała, że istnieje wiele problemów z Copilotem, które wciąż muszą zostać przetestowane w sądzie.

„Deweloperzy chcą wiedzieć, czy szkolenie sieci neuronowej na ich oprogramowaniu można uznać za dozwolony użytek. Inni, którzy mogą chcieć korzystać z Copilot, zastanawiają się, czy fragmenty kodu i inne elementy skopiowane z repozytoriów hostowanych na GitHub mogą spowodować naruszenie praw autorskich. I nawet jeśli wszystko może być zgodne z prawem, aktywiści zastanawiają się, czy nie jest coś fundamentalnie niesprawiedliwego w tym, że firma produkująca oprogramowanie własnościowe buduje usługi na podstawie ich pracy” – napisał FSF.

Pomoc odpowiada na te pytania, które FSF wezwała do opracowania białych ksiąg, które analizują następujące kwestie:

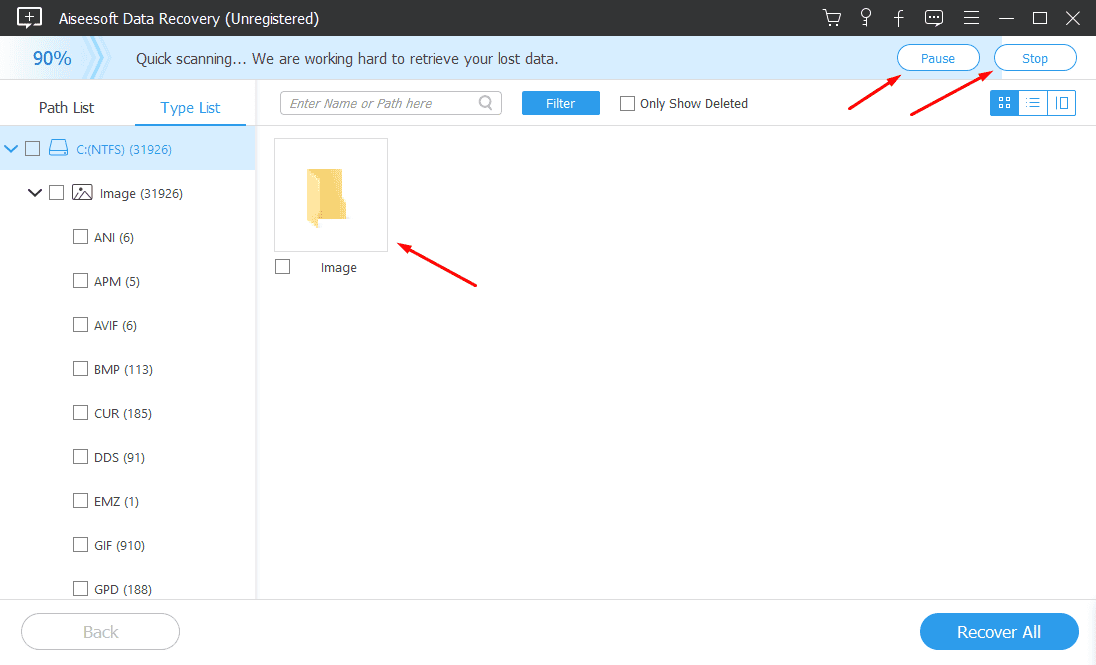

- Czy szkolenie Copilot dotyczące repozytoriów publicznych narusza prawa autorskie? Dozwolonego użytku?

- Jakie jest prawdopodobieństwo, że dane wyjściowe Copilot wygenerują uzasadnione roszczenia dotyczące naruszeń dzieł na licencji GPL?

- Czy programiści korzystający z Copilot mogą przestrzegać licencji wolnego oprogramowania, takich jak GPL?

- W jaki sposób programiści mogą zapewnić ochronę kodu, do którego posiadają prawa autorskie, przed naruszeniami generowanymi przez Copilot?

- Jeśli Copilot generuje kod, który powoduje naruszenie dzieła objętego licencją wolnego oprogramowania, w jaki sposób właściciel praw autorskich może wykryć to naruszenie?

- Czy wytrenowany model AI/ML jest chroniony prawem autorskim? Kto posiada prawa autorskie?

- Czy organizacje takie jak FSF powinny opowiadać się za zmianami w prawie autorskim odnoszącym się do tych pytań?

FSF zapłaci 500 USD za opublikowane białe księgi i może uwolnić więcej funduszy, jeśli uzasadnione będą dalsze badania.

Ci, którzy chcą złożyć wniosek, mogą go wysłać na adres [email chroniony] przed 21 sierpnia. Przeczytaj więcej o tym procesie na FSF.org tutaj.

Microsoft odpowiedział na nadchodzące wyzwanie, mówiąc: „To jest nowa przestrzeń i chętnie angażujemy się w dyskusję z programistami na te tematy i kierujemy branżą w ustalaniu odpowiednich standardów szkolenia modeli AI”.

Biorąc pod uwagę, że Copilot czasami kradnie całe funkcje z innych aplikacji Open Source, czy nasi czytelnicy zgadzają się z FSF, czy też FSF jest obłudny tylko dlatego, że jest sztuczną inteligencją, a nie ludzkim kodem zmieniającym przeznaczenie? Daj nam znać swoje zdanie w komentarzach poniżej.

przez świat informacji